看实验的时候感觉自己在统计方面好欠缺

所以现在来填坑=。=

××××××××××××我是快乐的小学渣××××××××××××××××××××××××××××××××××

(参考http://blog.sina.com.cn/s/blog_6b1c9ed50101l02a.html)

(1)p-value:表征了在原假设成立的条件下,重复进行当前的试验,获得现有统计量t及其更极端情况的概率。

用来判断是否拒绝原假设。如果p小于给定的α(显著性水平:犯一类错误的概率、错误拒绝原假设的最大概率),则拒绝原假设,否则接受。而且p越小,拒绝的信心越大。

通常针对single test,对于multi-test,应该考虑使用更严格的q-value

(2)false positive rate: 使用α来表示大小

(3)多重检验

http://www.bbioo.com/lifesciences/40-114656-1.html(not read yet)

在进行多重假设检验时,每个单独的假设都具有其本身的I型错误。在这种情况下,如果不进行任何的控制,犯I-型错误的概率会随着假设检验的个数而迅速增加。

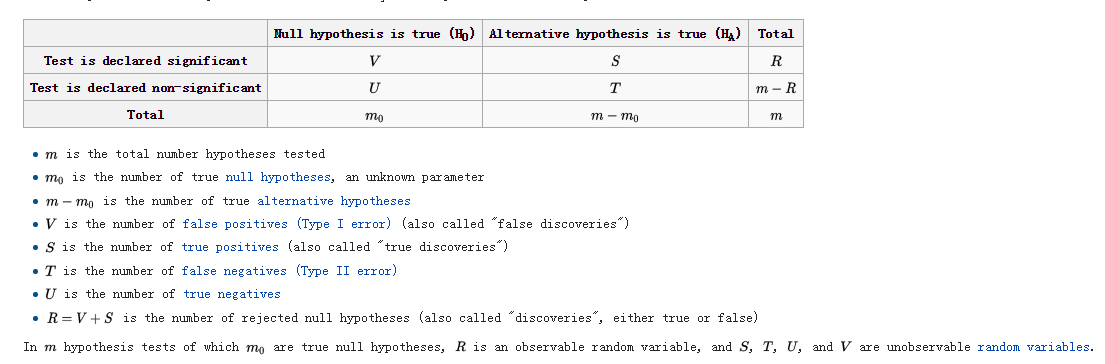

总体错误率(family-wise error rate,FWER):至少出现一次错误地拒绝真实H0的可能性;FWER小于等于alpha。而研究者更关心的是能否尽量多地识别出差异表达的基因,并且能够容忍和允许总的拒绝中发生少量的错误识别,称为错误发现false discovery。即需要在错误发现和总的拒绝次数R之间寻找一种平衡,即在检验出尽可能多的候选变量的同时将错误发现率控制在一个可以接受的范围。

错误发现率(False Discovery Rate,FDR),表示了在所有R次拒绝中错误发现的期望比例。错误发现率将范围限定在总的拒绝次数中;而假阳性率则针对所有变量数而言。

Benjamini and Hochberg Method:

给定FDR的控制水平alpha,多重假设检验次数M,通过求得拒绝H0的次数N,可得出多重检验M次中,有多少次是被错误识别的(=alpha * N)。Benjamini和Hochberg给出了一个基于p-value的逐步向下控制程序,用于求出拒绝H0的次数N的值。并且证明在BH控制下,FDR 小于等于 alpha。步骤:

设总共有m个候选基因,每个基因对应的p值从小到大排列分别是p(1),p(2),...,p(m),则若想控制fdr不能超过q,则只需找到最大的正整数i,使得 p(i)<= (i*q)/m.然后,挑选对应p(1),p(2),...,p(i)的基因做为差异表达基因,这样就能从统计学上保证fdr不超过q。

(4) pFDR

反映了已经在拒绝H0的情况下H0 = 0的概率。可以认为pFDR是贝叶斯后验p值。

q-value量化了在观察统计量T = t时,拒绝H0所犯的最小pFDR。p-value的定义基于H0=0的条件而量化T属于Talpha的概率,显然q值是p值定义的一个逆过程,q值是基于T属于Talpha的条件而量化H0=0的概率。

和BH控制不同,q值和pFDR正好相反,即通过选定的拒绝域Talpha去估计对应的q值,当q小于等于alpha时,可保证FDR小于等于alpha。BH计算错误发现率时具有保守性,即在降低假阳性的同时,也减少了正确的假设。为此可采用q-value用于FDR计算。Storey给出了关于q值和pFDR的估计算法。

根据p-value或q-value可以计算对应的FDR,多重假设检验中拒绝H0的次数。

q-value(i)=p(i)*length(p)/rank(p) (???)

(5)Bonferroni校正

如果在同一数据集上同时检验n个独立的假设,那么用于每一假设的统计显著水平,应为仅检验一个假设时的显著水平的1/n。举个例子:如要在同一数据集上检验两个独立的假设,显著水平设为常见的0.05。此时用于检验该两个假设应使用更严格的 0.025。即0.05* (1/2)。该方法是由Carlo Emilio Bonferroni发展的,因此称Bonferroni校正。这样做的理由是基于这样一个事实:在同一数据集上进行多个假设的检验,每20个假设中就有一个可能纯粹由于概率,而达到0.05的显著水平。

(6)https://en.wikipedia.org/wiki/False_discovery_rate