YOLOv1-darknet 内容解析

1. 核心思想

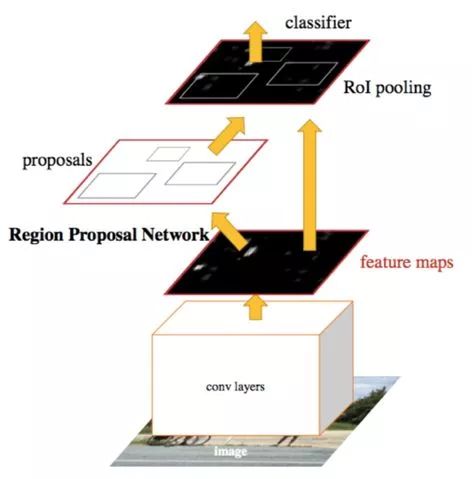

目标检测分为二阶段和一阶段的方法,二阶段方法主要有Fast R-CNN系列,Mask R-CNN等,主要方法是用算法生成一些列作为样本的候选框,然后再使用卷积神经网络进行样本的分类;

一阶段方法(End to End方法)主要有SSD系列,YOLO系列,这种方法是将目标边框的定位问题转化为回归问题处理。

由于思想的不同,二阶段检测方法在检测准确率和定位精度有优势,一阶段检测方法在速度上占有优势。

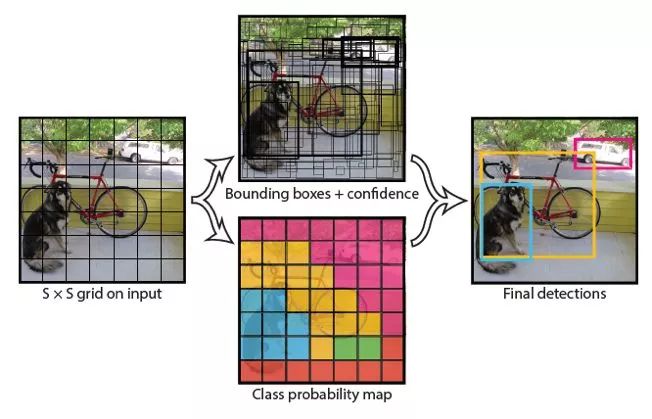

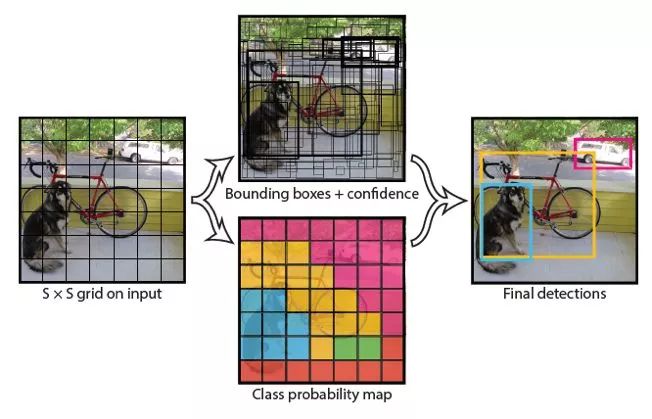

所以YOLO的核心思想是,直接在输出层回归bounding box的位置和bounding box所属的类别(整张图作为网络的输入,把 Object Detection 的问题转化成一个 Regression 问题)。

2. 特点

- 速度快,因为没有复杂的检测流程,只需要将图像输入到神经网络就可以得到检测结果,YOLO可以非常快的完成物体检测任务。

- YOLO在训练和测试时都能够看到一整张图像的信息,因此YOLO在检测物体时能很好的利用上下文信息,从而不容易在背景上预测出错误的物体信息。

- YOLO可以学到物体的泛化特征:当YOLO在自然图像上做训练,在艺术作品上做测试时,YOLO表现的性能比DPM、R-CNN等之前的物体检测系统要好很多。因为YOLO可以学习到高度泛化的特征,从而迁移到其他领域。

3. 缺点

-

YOLO的物体检测精度低于其他state-of-the-art的物体检测系统。

-

YOLO容易产生物体的定位错误。

-

YOLO对小物体的检测效果不好(尤其是密集的小物体,因为一个栅格只能预测2个物体)。

4. 算法流程

-

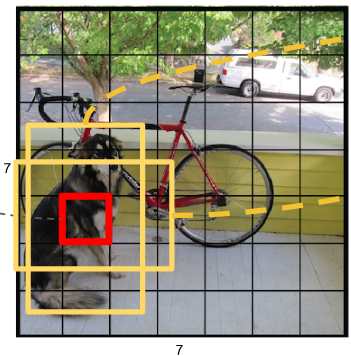

Resize成448 ( imes) 448,图片分割得到7 ( imes) 7 网格(cell)

-

CNN提取特征和预测:卷积部分负责提特征。全链接部分负责预测:

- 7 ( imes) 7 ( imes) 2 = 98个bounding box的坐标(x,y,w,h,confidence)

- 7 ( imes) 7 = 49个cell所属20个物体的概率

-

过滤得到的bbox, 使用nms算法

5. 详细内容

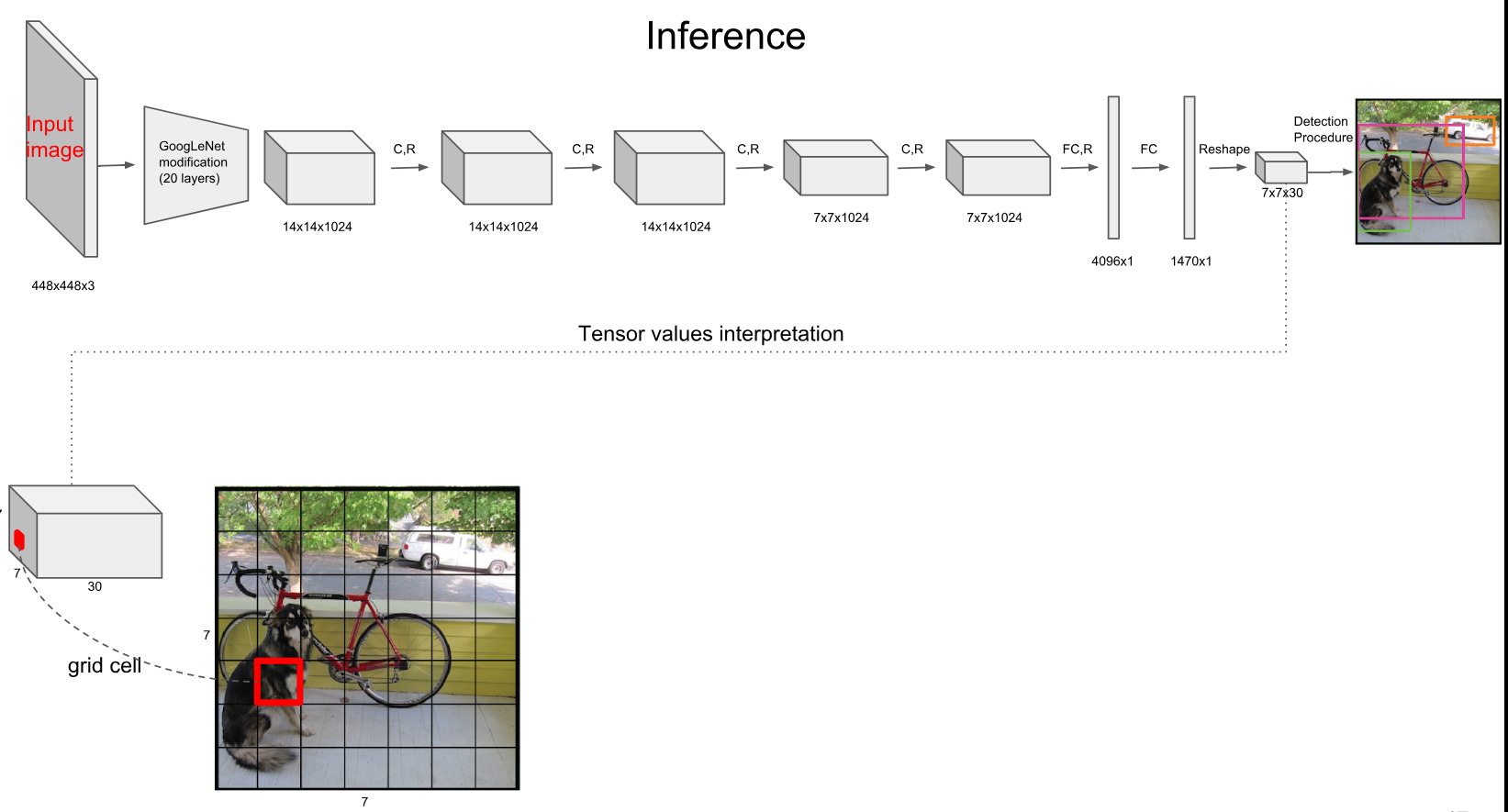

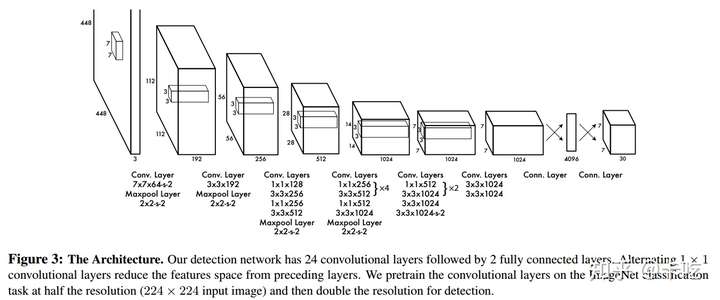

网络示意图:

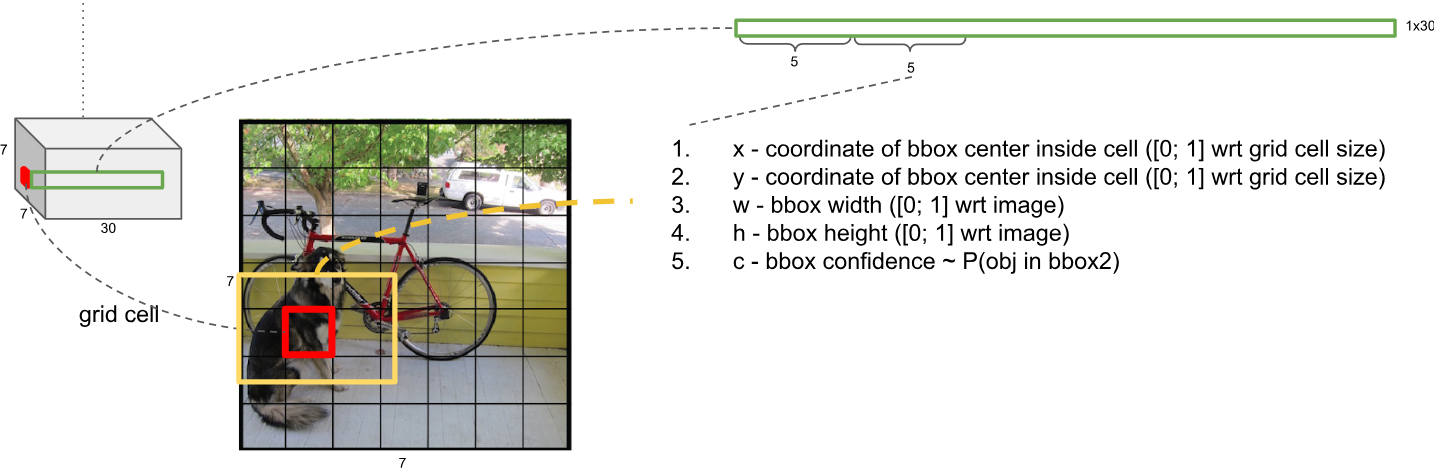

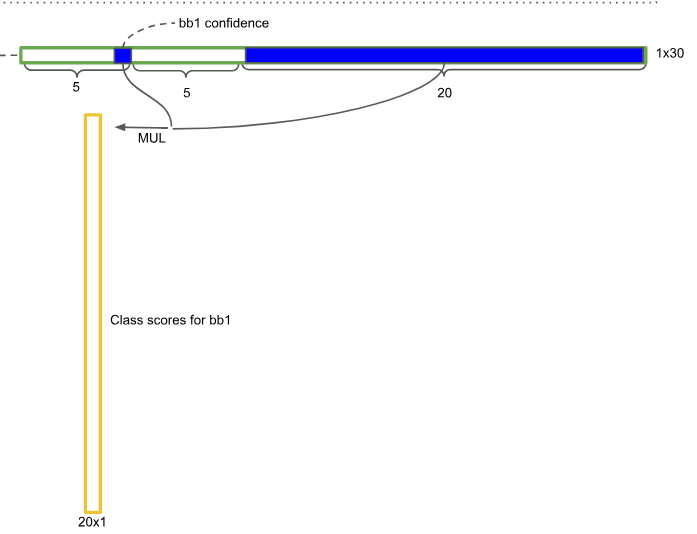

最后reshape层的计算:(5 = x,y,w,h,confidence)

这里BboxNum = 2, Class = 20,所以filter是30。

网络结构借鉴了 GoogLeNet 。24个卷积层,2个全链接层。(用1×1 reduction layers 紧跟 3×3 convolutional layers 取代Goolenet的 inception modules )

每个1 ( imes) 1 ( imes) 30 对应其中一个cell, 每个cell需要预测两个bounding box的中心坐标((x_c),(y_c),(w),(h)),其中(x_c,y_c)被归一化到0~1之间,w,h通过图像的width和height归一化到0~1之间。 每个bounding box除了要回归自身的位置之外,还要附带预测一个confidence值。 这个confidence代表了所预测的box中含有object的置信度和这个box预测的有多准两重信息:

第一项:$$Pr(Object)$$: 代表的是如果人工标注的框(ground truth box)落在一个gird cell中,则取1,否则取0。

第二项: $$IOU^{truth}_{pred}$$: 预测的bounding box和实际的ground truth box之间的IOU值。

这样前10个框来源就清楚了,即:(BboxNum imes 5).

剩余的20维度是用来对20个类进行预测,所以总共需要输出是 $$7 imes 7 imes (5 imes 2 + 20)$$。

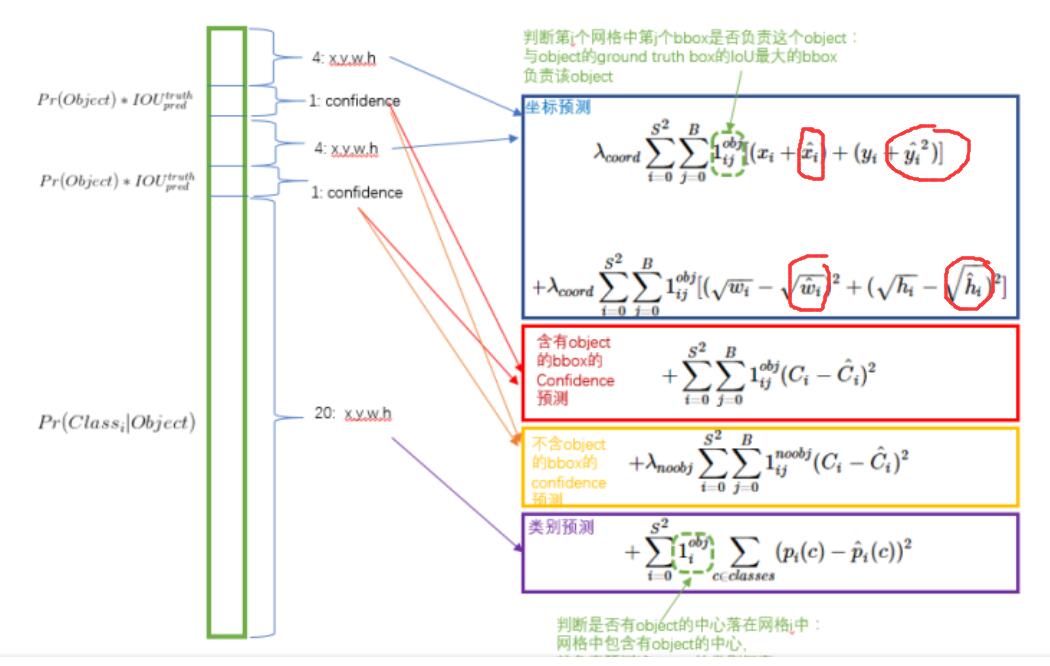

关键内容:损失函数的设计

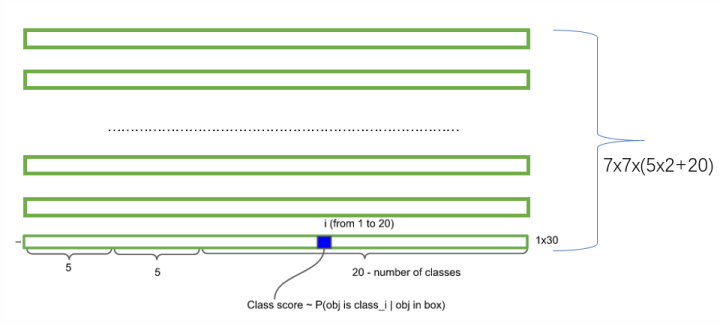

说明:每行是一个cell对应的两个bounding Box的相关信息,一共有(7 imes7)这么多的行

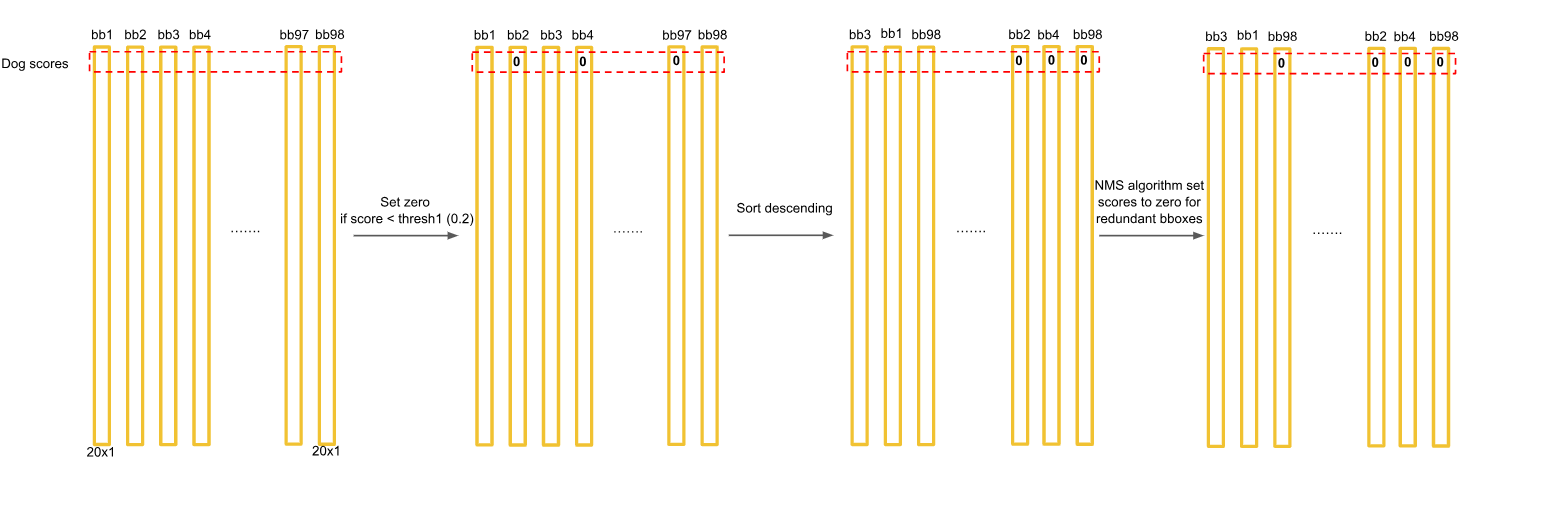

对应类别计算方法,需要与confidence相乘,得到以下矩阵:

按照下图所示步骤进行操作,这只是示意其中一个类,每一行都要进行如下操作:

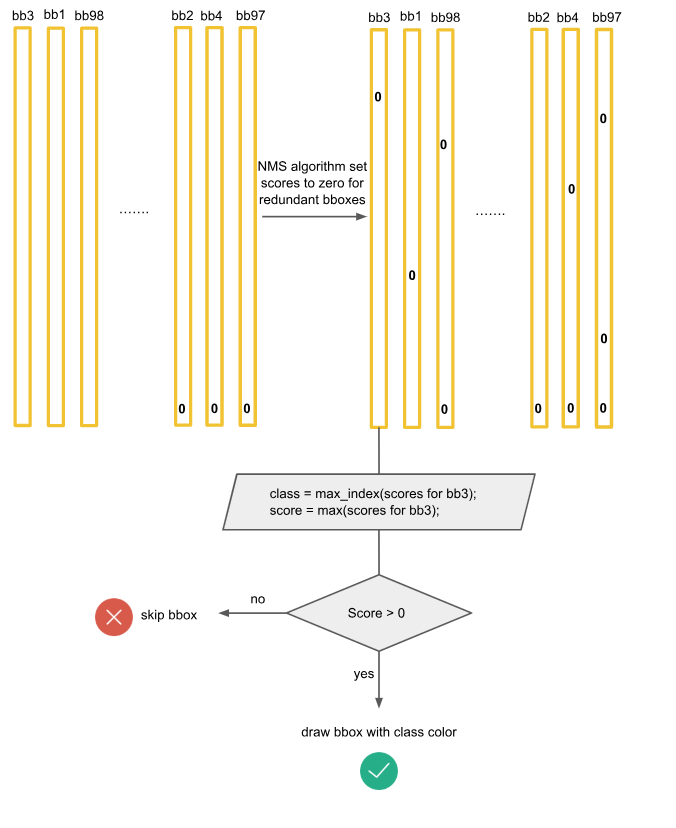

在所有做完nms之后选择对应的框画出来

得到以下效果:

总图:

损失函数由三个方面组成,一个是定位损失(localization error),一个是置信度损失,一个是分类损失(classification error)。简单的全部采用了sum-squared error loss来做这件事会有以下不足:

- 8维的localization error和20维的classification error同等重要是不合理的;(真实框的中心x坐标减去yolo实际预测框的中心x尖 )

- 如果一个网格中没有object(一幅图中这种网格很多),那么就会将这些网格中的box的confidence逼近到0,相比于较少的有object的网格,这种做法是overpowering的,这会导致网络不稳定甚至发散。

如何解决,重新设计新的loss计算方案:

-

更重视8维的坐标预测,给这些损失前面赋予更大的loss weight, 记为(lambda_{coord}),即坐标预测部分内容。(上图蓝色框)

-

对没有object的bbox的confidence loss,赋予小的loss weight,记为 (lambda_{coord}),在pascal VOC训练中取0.5。(上图橙色框)

-

有object的bbox的confidence loss (上图红色框) 和类别的loss (上图紫色框)的loss weight正常取1。

-

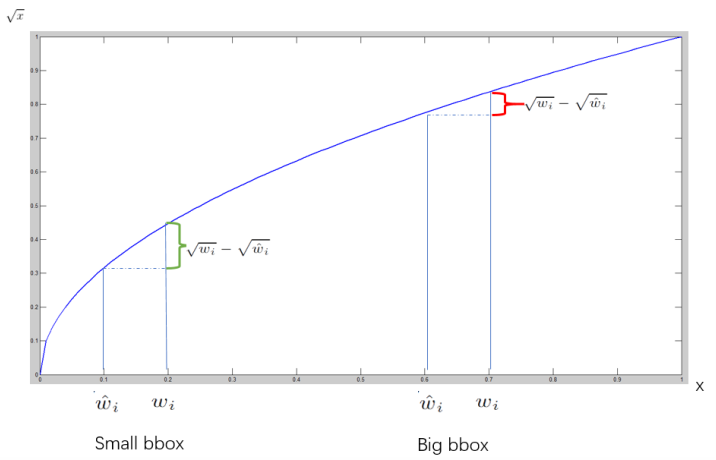

对不同大小的bbox预测中,相比于大bbox预测偏一点,小box预测偏一点更不能忍受。而sum-square error loss中对同样的偏移loss是一样。 为了缓和这个问题,作者用了一个比较取巧的办法,就是将box的width和height取平方根代替原本的height和width。 如下图:small bbox的横轴值较小,发生偏移时,反应到y轴上的loss(下图绿色)比big box(下图红色)要大。

-

-

一个网格预测多个bounding box,在训练时我们希望每个object(ground true box)只有一个bounding box专门负责(一个object 一个bbox)。具体做法是与ground true box(object)的IOU最大的bounding box 负责该ground true box(object)的预测。这种做法称作bounding box predictor的specialization(专职化)。每个预测器会对特定(sizes,aspect ratio or classed of object)的ground true box预测的越来越好。(个人理解:IOU最大者偏移会更少一些,可以更快速的学习到正确位置)

-

测试阶段,使用nms的时候,按照以下方式进行衡量是否保留改框:

[Pr(Class_i|Object) imes Pr(Object) imes IOU^{truth}_{pred}=Pr(Class_i) imes IOU^{truth}_{pred} ]