一文梳理无监督对比学习(MoCo/SimCLR/SwAV/BYOL/SimSiam)(微信推文)

自监督学习(Self-Supervised Learning) 2018-2020年发展综述 (微信推文)

对比学习(Contrastive Learning)综述(知乎)

综述文献:

2020TPAMI-Self-supervised Visual Feature Learning with Deep Neural Networks- A Survey

2020-A Survey on Semi-, Self- and Unsupervised Learning for Image Classification

几个经典的自监督学习模型:

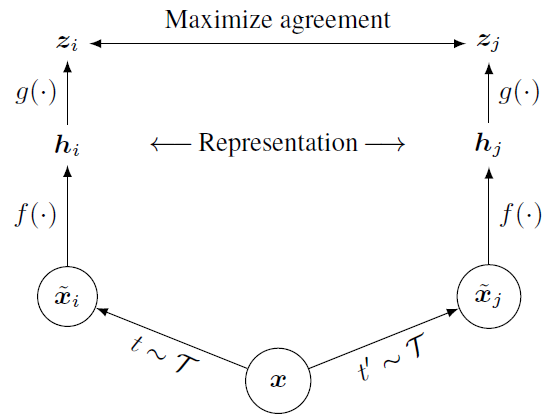

SimLCR

Chen Ting et al. ICML2020.

结论:

数据增强对表征学习的影响很大,有难度的增强的方法可以使表征学得更好;

batch size越大(即负样本越多),表征学习效果越好;

nonlinear projection head有助于提升表征学习质量。

MoCo

Kaiming He et al. CVPR2020.

提出momentum encoder,把batch size和queue size解耦,避免大的batch size,也不需要memory bank去存储所有编码好的样本了。

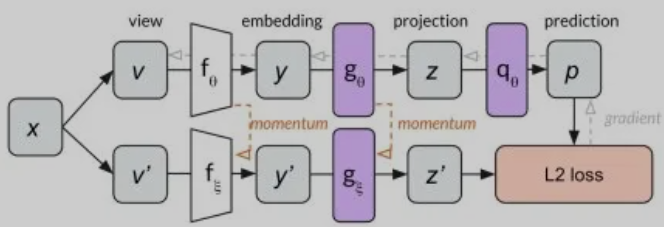

BYOL ()

前人的工作是用同一张图像的一个view的representation去predict另一个view的representation,但这样做容易出现退化解(collapsed solutions, e.g., outputting the same vector for all images),因为很多时候,representation具有view invariance。

然后作者把 “固定住权重” 改为 “权重以momentum的方式更新”。

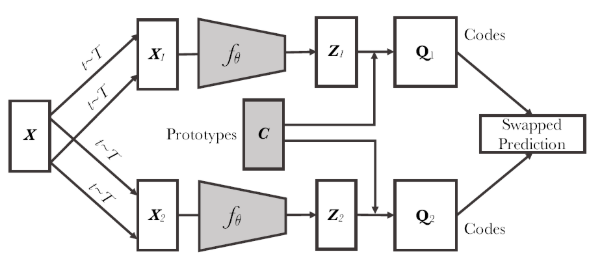

SwAV

motivation是去除负样本。

对各类样本进行聚类,得到聚类中心,根据每个样本与所有聚类中心的距离,得到样本的新的表示,用这种表示去做对比。

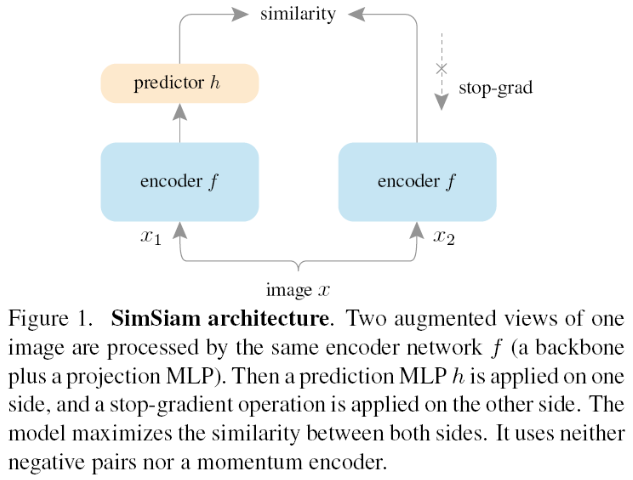

SimSiam

This method can be thought of as:

-

“BYOL without the momentum encoder”

-

“SimCLR without negative pairs”

-

“SwAV without online clustering”