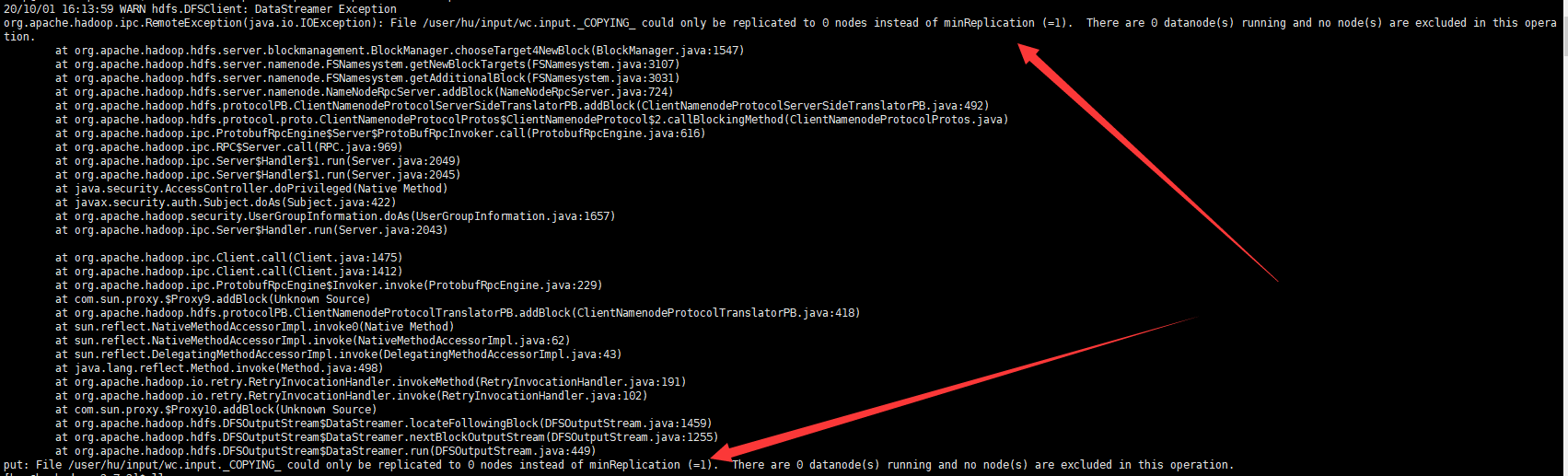

hadoop上传文件到web端hdfs显示hadoop could only be replicated to 0 nodes instead of 1解决办法

- 错误状态:在hadoop-2.7.2目录下执行bin/hdfs dfs -put 被执行文件 目标文件夹报错后解决!

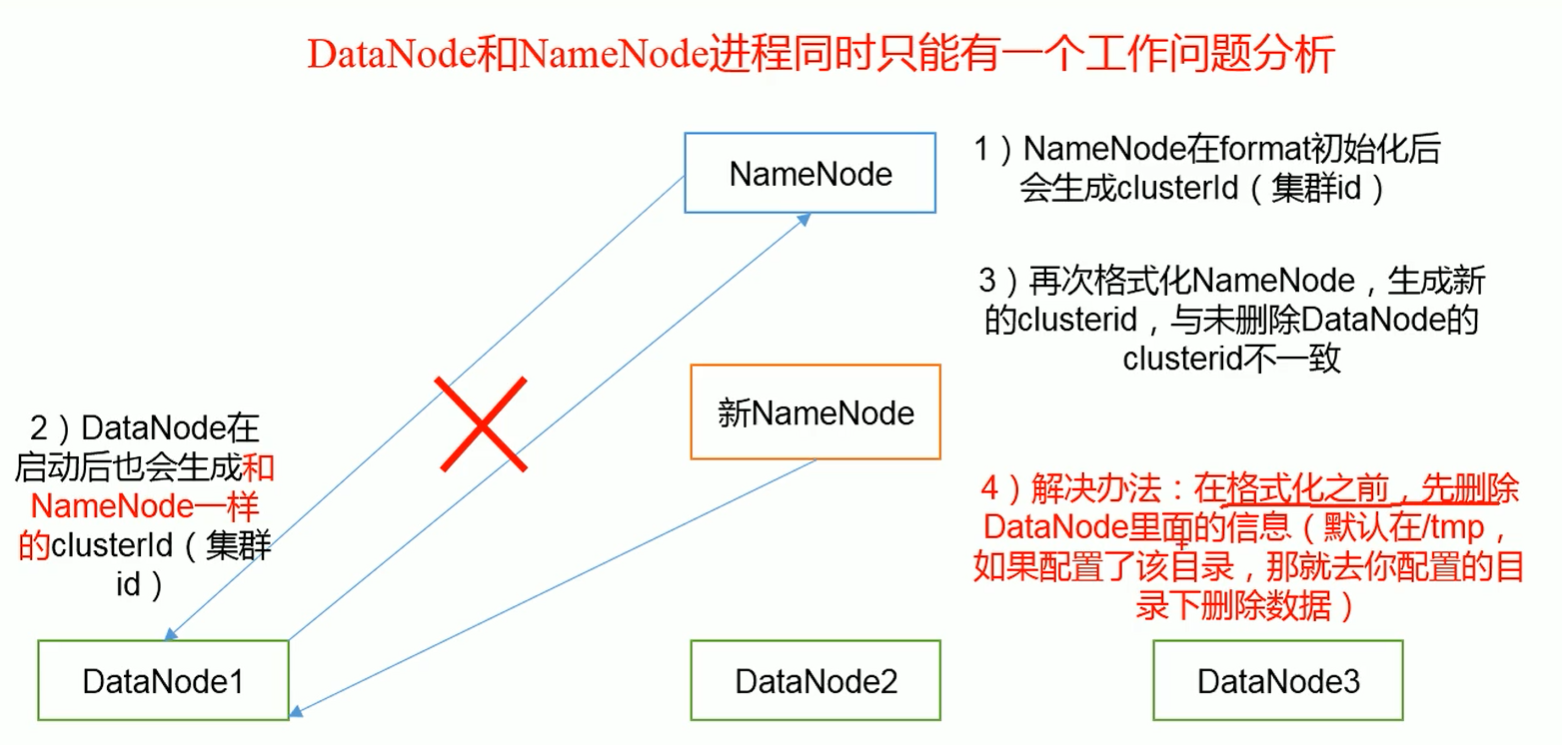

- 分析:这是我启动DataNode后又格式化NameNode导致二者集群id不一样即二者无法形成关联就上传不了文件

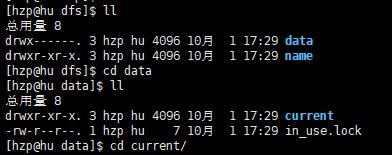

第一步:在hadoop-2.7.2文件夹下输入:cd data/tmp/dfs

第二步:ls -l 查看该目录下有两个目录一个是data一个是name 先cd data/current

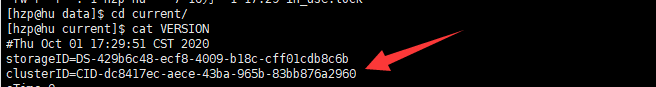

第三步:输入cat VERSION查看data/current/下的集群ID

第四步:去查看name/current/中的集群id发现二者不一样或者看不到data下有任何数据(原因:之前执行了sbin/hadoop-daemon.sh stop datanode清除data数据后没有再次启动DataNode导致的)

解决办法:

第一步:在hadoop-2.7.2文件夹下输入:sbin/hadoop-daemon.sh stop namenode再次输入:sbin/hadoop-daemon.sh stop datanode

第二步:格式化namenode----在hadoop-2.7.2文件夹下输入:bin/hdfs namenode -format

第三步:启动Namenode----在hadoop-2.7.2文件夹下输入:sbin/hadoop-daemon.sh start namenode

第四步:启动DataNode----在hadoop-2.7.2文件夹下输入:sbin/hadoop-daemon.sh start datanode

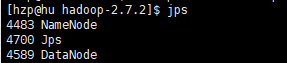

第五步:在hadoop-2.7.2文件夹下输入:jps(jak安装后才会有这个命令)查看下图表示二者都启动起来了。

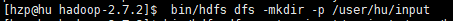

第六步:开启web下的hdfs后创建文件夹user/hu/input

第六步:再次上传就成功了

在上传的目标文件夹下执行:bin/hdfs dfs -put 目标文件 /user/hu/input上传后去web端查看表示成功!