现有的模型存在两个问题:

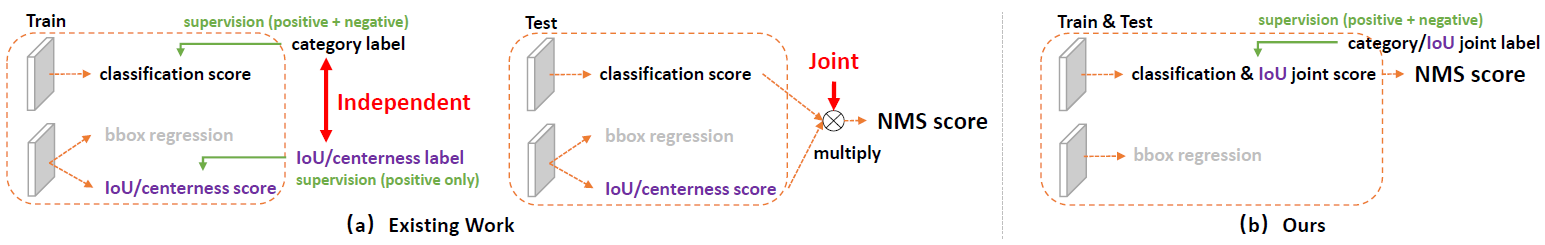

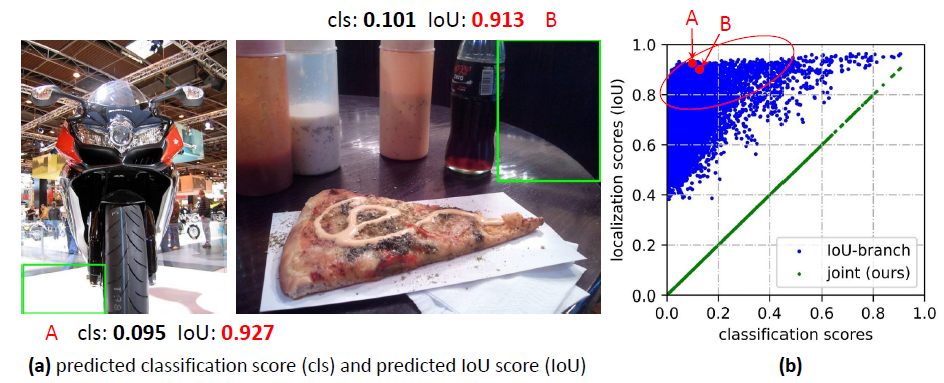

(1)classification score和quality score(包括IoU和centerness score)训练和推理时不一致.训练的时候这两个score是分别训练的,推理的时候将这两个score相乘作为NMS的依据,如下图(a)所示.

这有可能造成一些错误,如下图所示,在推理过程中,某些负例的cls score很低,但是IoU score又很高,两者相乘得到的乘积比较大,在NMS的时候有可能排在一些正例的前面,从而降低了mAP.

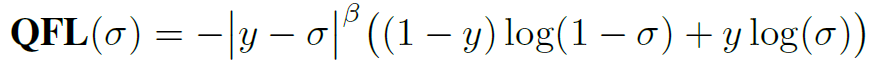

针对这个问题,解决的方法是在训练时就将classification score和quality score联合起来训练,此时分类标签不再是1,而是一个0~1之间的数,也就是IoU或者centerness score.此时将传统的Focal Loss改成了Quality Focal Loss(QFL):

其中y是标签label(0~1之间的1个数),delta是预测值.

(2)由于阻挡,影子,模糊等原因,有些GT object的边界不清晰,GT标签不可信,此时用Dirac distribution来处理就受限,解决的办法是采用General distribution,用平坦的分布来表明不清楚和模糊的边界,如下图所示.

把传统的边界回归问题转化为分类问题,把连续的目标值y的取值范围[y0,yn]离散化为[y0,y1,...,yi,yi+1,...,yn-1,yn],也就是把y分成n+1个单位,也就相当于n+1个类,离y最近的两个类yi+1和yi作为目标,计算下面的Distribution Focal Loss(DFL):

Generalized Focal Loss(GFL)包括了QFL和DFL两部分,如下图所示.

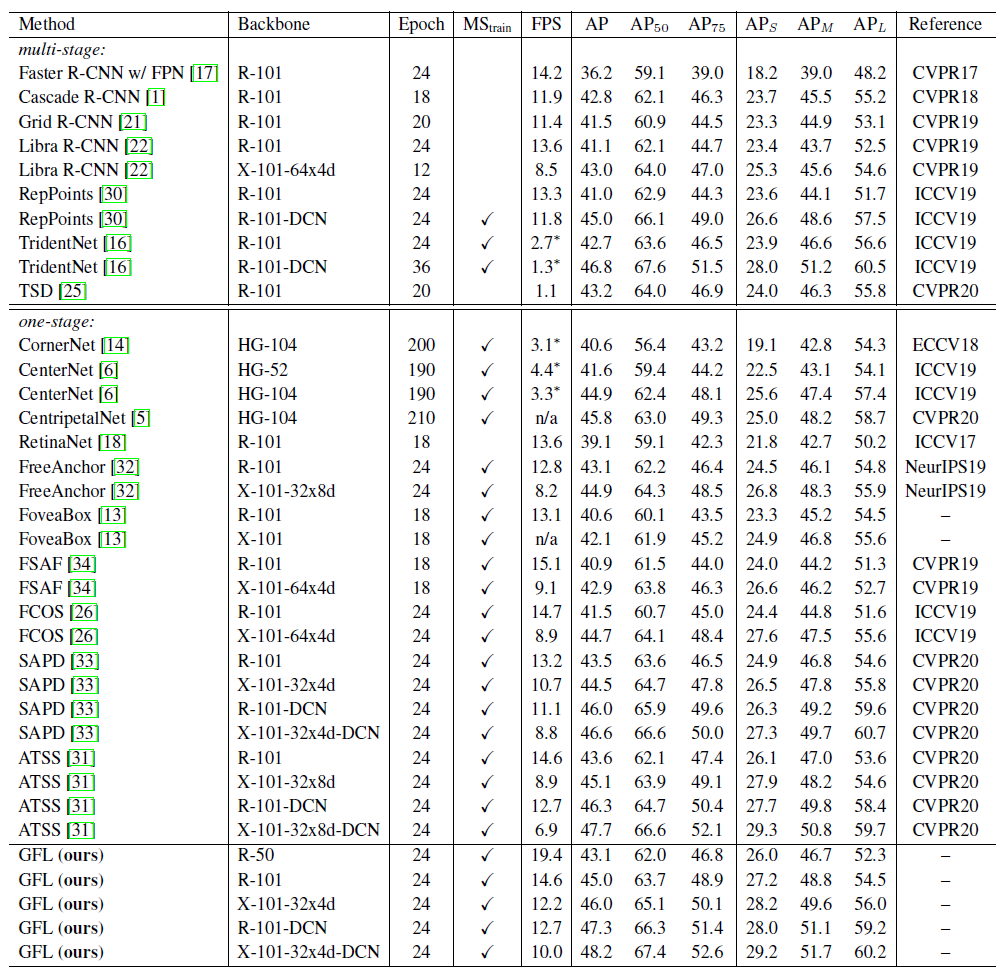

通过实验,证明了GFL提高了mAP.