近年来,随着机器人研究的不断发展,需要机器人实现的功能越来越多,对应的行为也越来越复杂,简单的运动控制已经不能满足需求,尤其是对于一些不易获取运动规律的任务,传统控制方法根本无法实现。这要求机器人具备更高的学习能力,可以与环境形成动态交互以应对未知情况。

Ananalytical diabolo model for robotic learning and control

原文链接:https://ieeexplore.ieee.org/abstract/document/9561578

利用机器学习可以解决解决机器人应用问题,即可以在传统方法失效时找到有效策略完成任务。机器学习算法可以分为三大类:有监督学习、无监督学习和强化学习。其中强化学习往往被用来处理复杂的决策任务,但是往往决策空间巨大,强化学习需要不断地试错,因此样本复杂度往往很高,从而限制强化学习在一些场景的应用。

Ananalytical diabolo model for robotic learning and control

原文链接:https://ieeexplore.ieee.org/abstract/document/9561578

而强化学习的一个分支-模仿学习则是直接从专家样本中学习,由于有比较高质量的决策行为数据,模仿学习(Imitation Learning)被认为是可以降低样本复杂度的一个手段。模仿学习又被称作示教学习(Learning from Demenstration),通过示教者的动作和编码回归得到一条优化的机器人轨迹。模仿学习时示教者根据任务要求进行轨迹示教,并通过相应的方式记录示教轨迹。

模仿学习可以分为以下过程:人类进行示教,机器人获取示教轨迹数据,利用学习模型进行理解,得到控制策略,然后机器人作为执行器控制运动再现行为,实现运动技能学习。[1]

原视频链接(来源于YouTube):https://www.youtube.com/watch?v=hD34o3DGYcw

行为获取-获得示教轨迹数据后,首先需要进行预处理,进行运动分割、降维、滤波、特征提取等处理,将预处理后的数据作为学习模型输入,为编码做准备。

行为表述-行为表述即为编码过程,研究如何将观察到的示教行为映射到机器人系统上,有效的表述方法需要具备一定的泛化能力和鲁棒性,能把学习到的能力应用在新环境中,并且具有一定抗干扰的能力。

行为再现-对于机器人模仿学习,需要评估模仿性能的度量。然后通过底层运动控制,将学习到的控制策略映射到机器人的执行器空间,实现真正意义的可再现。

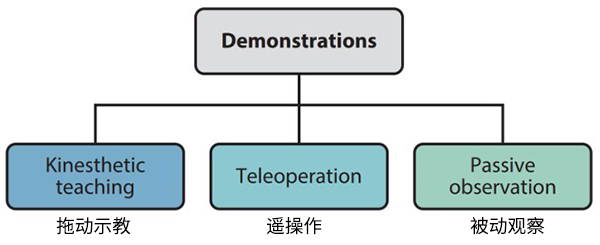

模仿学习中,示教数据(运动轨迹)的获取是训练模型的基础,在研究中采集示教数据的途径主要有三种[2]:

1)拖动示教。拖动示教是通过人实际移动机器人完成所需动作来进行演示。过程中的状态信息(比如关节角度和扭矩等)通过机器人的机载传感器记录,从而为机器学习模型生成训练数据。这种方法比较直观,对用户要求也较低,在轻型工业机器人场景中使用广泛。但是这种方法的演示质量取决于操作者动作的灵活性和流畅性,即使是专家操作者操作获取的数据也需要平滑或其他后处理。此外受到形态因素限制,这种方式对机械臂最有效,但是在其他平台(比如腿式机器人或灵巧手等)使用拖拽示教的难度较大。

2)遥操作。遥操作是另一种演示方法,可以用于轨迹学习、任务学习、抓取或者更高级的任务。遥操作需要通过手柄、图形界面或者其他方式向机器人提供外部输入。目前已存在多种交互设备(比如触觉设备或VR交互设备等)。与拖拽示教不同,遥操作不需要用户与机器人在同一现场,可以远程实现。遥操作的局限性包括需要开发输入界面等额外工作、需要更长时间的用户培训过程以及外部设备带来的可用性风险。

3)被动观察。被动观察主要是机器人通过观察演示者动作进行学习。演示者利用自己的身体完成任务,利用外部设备捕捉演示者的动作(演示者身体或操作的目标物)数据,其中最有效的数据获取方式为被动式光学动作捕捉。机器人在此过程中不参与任务执行,只是作为被动观察者。这种方式对于演示者最为轻松,对于演示过程不需要任何训练。这种方式也适用于具有多自由度的机器人以及非拟人机器人(这些场景很难使用拖拽示教方法)。这种方法需要将人类动作映射到机器人可执行的动作,其中存在的困难包括演示过程中的遮挡、快速移动和传感器噪声等。

原视频链接(来源于YouTube):https://www.youtube.com/watch?v=z8SfRrUvQ_4

NOKOV度量动作捕捉系统采用被动红外光学原理,通过捕捉粘贴在人体躯干(或操作的目标物)上的反光标志点来获取运动数据。NOKOV动作捕捉系统的定位精度高,静态重复精度达到0.037mm,绝对精度可以达到0.087mm,直线动态轨迹误差可以达到0.2mm,圆弧轨迹误差0.22mm[3]。此外NOKOV度量动作捕捉系统在满分辨率情况下的采样频率最高可以达到380Hz,满足对高运动速度演示进行数据采集的需求。NOKOV工程师有5年以上的项目经验,对于不同的场地情况可以给出定制化方案,使实验过程中的遮挡影响降到最小。

目前国外研究模仿学习知名的机构,比如瑞士联邦理工学院(EPFL)的LASA实验室、意大利技术研究院机器人实验室、德国达姆施塔特大学Prof. Jan Peters团队等,都使用了动作捕捉系统作为获取示教轨迹数据的重要手段。

Arm-hand motion-force coordination for physicalinteractions with non-flat surfaces using dynamical systems: Toward compliantrobotic massage

原文链接:https://ieeexplore.ieee.org/abstract/document/9196593

动作捕捉应用于示教学习案例举例

哈尔滨工业大学-3C装配任务精确控制

研究人员通过模仿学习方法提出一种有效的离线编程技术以实现3C装配线的自动化[4]。该过程包括两个阶段,第一阶段,NOKOV度量光学动作捕捉设备用于捕获在装配过程中人手的位姿信息;第二阶段,通过学习这些演示数据设计机器人控制策略,首先利用基于密度的空间聚类启发轨迹分割算法和基于局部离群因子的异常点检测算法对演示数据进行预处理,然后从已处理的数据中通过基于高斯混合模型的概率学习策略学习人类装配技能,从而驱动机器人在新环境下完成相同的装配任务。

演示数据由NOKOV度量光学动作捕捉设备获得,该平台能够跟踪粘贴在操作人员手上的三个反光标记点,操作简单,可以直观记录人工装配动作,并借用强化学习的框架提出一种迭代路径优化技术。研究通过演示一条简单的拾取-放置(pick-and-place)装配路径验证了迭代路径优化策略的有效性。

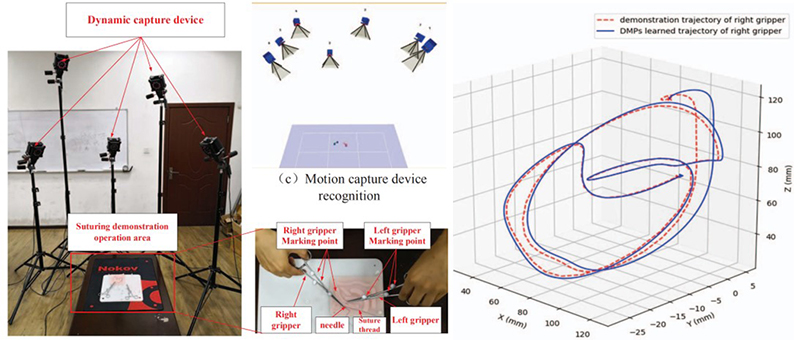

重庆邮电大学-基于模仿学习手术机器人缝合技能建模方法

手术辅助机器人可以帮助外科医生克服传统手术在操作精度、工作空间、距离和协同工作等方面的难点。为了让手术机器人系统实现像医生一样高质量的自动化操作,一项重要的基础工作是建立手术操作模型。

为此,重庆邮电大学的杨德伟老师团队以浅表组织缝合为建模对象,进行了缝合技能学习和建模研究[5]。为了获取医生缝合手术演示过程中的数据,研究人员建立了一套缝合手术演示采集系统。

系统包含一套NOKOV度量动作捕捉系统、手术钳、缝合针、线和伤口模型。根据DMPs方法将动作捕捉系统采集到的轨迹数据分为几个动态过程,利用示教者的操作轨迹数据去训练DMPs模型,最终验证了该方法对缝合过程的建模能力和对新场景的适应性。

武汉大学-轨迹预测

武汉大学的轨迹预测相关研究,以球状飞行物体为研究对象,研究内容包括运动目标的实时识别、定位与轨迹预测,通过搭建LSTM网络模型,对模型进行训练和测试,解决了球状飞行物体的识别与定位以及轨迹预测问题[6]。

实验采用Kinect深度相机和8镜头NOKOV度量动作捕捉系统方案搭建系统硬件平台,采用 ROS系统作为机器人的软件平台,并对系统进行标定。标定对象包括包括 Kinect 深度相机的内参标定,以及 Kinect 与 NOKOV 度量动作捕捉系统的联合标定。

运动目标识别采用基于混合高斯模型的背景差分法对运动目标进行识别,对运动目标进行相平面定位以获取对应像素点的点云信息,采用高斯牛顿法拟合点云质心获取运动目标的空间坐标,结合卡尔曼滤波对质心运动轨迹进行优化。

实验中,研究人员采用基于 RNN 的运动目标轨迹预测方法,利用NOKOV度量动作捕捉系统采集1000条运动目标完整运动轨迹,并将数据集80%的轨迹序列用于训练,20%的轨迹序列用于测试。最后将所搭建网络应用于不规则运动目标乒乓球拍的轨迹预测中,证明了所搭建网络的泛化能力。

实验中,研究人员采用基于RNN 的运动目标轨迹预测方法,利用NOKOV度量动作捕捉系统采集1000条运动目标完整运动轨迹,并将数据集80%的轨迹序列用于训练,20%的轨迹序列用于测试。最后将所搭建网络应用于不规则运动目标乒乓球拍的轨迹预测中,证明了所搭建网络的泛化能力。

参考文献:

[1]于建均,门玉森,阮晓钢,徐骢驰.模仿学习在机器人仿生机制研究中的应用[J].北京工业大学学报,2016,42(02):210-216.

[2] Recent Advances in Robot Learning fromDemonstration Harish Ravichandar, Athanasios S. Polydoros, Sonia Chernova, AudeBillard Annual Review of Control, Robotics, andAutonomous Systems 2020 3:1, 297-330.

[3] H. Hu, Z. Cao, X. Yang, H. Xiong and Y.Lou, "Performance Evaluation of Optical Motion Capture Sensors forAssembly Motion Capturing," in IEEE Access, vol. 9, pp. 61444-61454, 2021,doi: 10.1109/ACCESS.2021.3074260.

[4] Z. Zhao, H. Hu, X. Yang and Y. Lou,"A Robot Programming by Demonstration Method for Precise Manipulation in3C Assembly," 2019 WRC Symposium on Advanced Robotics and Automation (WRCSARA), 2019, pp. 172-177, doi: 10.1109/WRC-SARA.2019.8931947.

[5] D. Yang, Q. Lv, G. Liao, K. Zheng, J.Luo and B. Wei, "Learning from Demonstration: Dynamical MovementPrimitives Based Reusable Suturing Skill Modelling Method," 2018 ChineseAutomation Congress (CAC), 2018, pp. 4252-4257, doi: 10.1109/CAC.2018.8623781.

[6]杨明辉. 基于循环神经网络的运动目标轨迹预测[D].武汉大学,2019.