作业要求来源于:https://edu.cnblogs.com/campus/gzcc/GZCC-16SE2/homework/3075

一.把爬取的内容保存取MySQL数据库

- import pandas as pd

- import pymysql

- from sqlalchemy import create_engine

- conInfo = "mysql+pymysql://user:passwd@host:port/gzccnews?charset=utf8"

- engine = create_engine(conInfo,encoding='utf-8')

- df = pd.DataFrame(allnews)

- df.to_sql(name = ‘news', con = engine, if_exists = 'append', index = False)

二.爬虫综合大作业

- 选择一个热点或者你感兴趣的主题。

- 选择爬取的对象与范围。

- 了解爬取对象的限制与约束。

- 爬取相应内容。

- 做数据分析与文本分析。

- 形成一篇文章,有说明、技术要点、有数据、有数据分析图形化展示与说明、文本分析图形化展示与说明。

- 文章公开发布。

参考:

爬了一下天猫上的Bra购买记录,有了一些羞羞哒的发现...

Python做了六百万字的歌词分析,告诉你中国Rapper都在唱些啥

分析了42万字歌词后,终于搞清楚民谣歌手唱什么了

十二星座的真实面目

唐朝诗人之间的关系到底是什么样的?

中国姓氏排行榜

三.爬虫注意事项

1.设置合理的爬取间隔,不会给对方运维人员造成压力,也可以防止程序被迫中止。

- import time

- import random

- time.sleep(random.random()*3)

2.设置合理的user-agent,模拟成真实的浏览器去提取内容。

- 首先打开你的浏览器输入:about:version。

- 用户代理:

- 收集一些比较常用的浏览器的user-agent放到列表里面。

- 然后import random,使用随机获取一个user-agent

- 定义请求头字典headers={’User-Agen‘:}

- 发送request.get时,带上自定义了User-Agen的headers

3.需要登录

发送request.get时,带上自定义了Cookie的headers

headers={’User-Agen‘:

'Cookie': }

4.使用代理IP

通过更换IP来达到不断高 效爬取数据的目的。

headers = { "User-Agent": "", } proxies = { "http": " ", "https": " ", } response = requests.get(url, headers=headers, proxies=proxies)

四、爬取豆瓣的影评

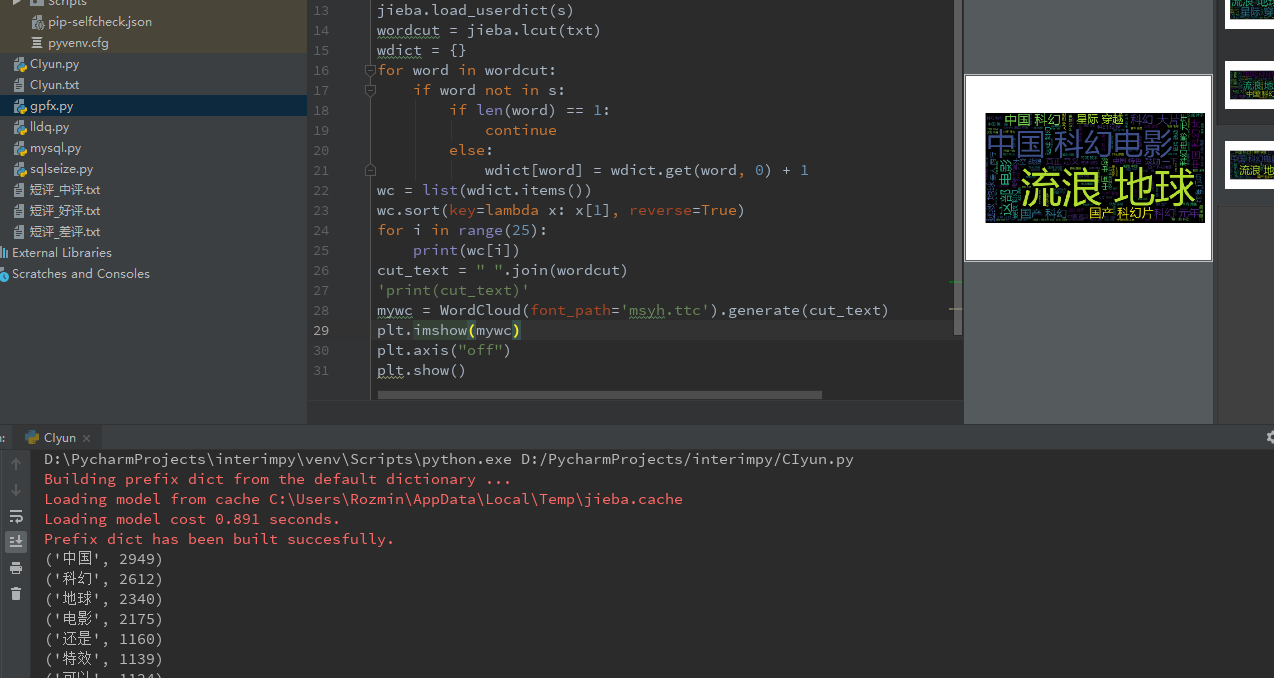

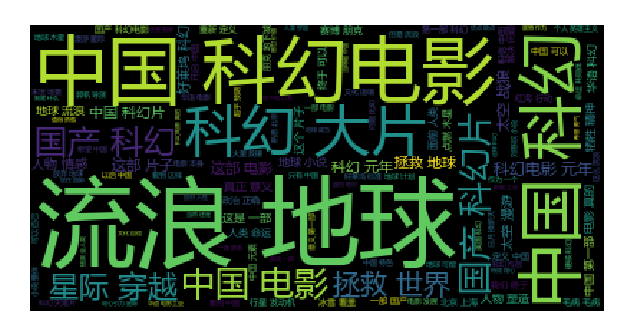

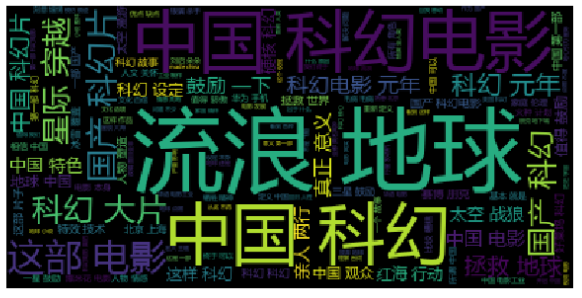

爬取《流浪地球》的好、中、差短评并分词分析。

import os import requests import codecs from bs4 import BeautifulSoup # 给请求指定一个请求头来模拟chrome浏览器 global headers headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/54.0.2840.99 Safari/537.36'} server = 'https://movie.douban.com/subject/26266893/comments' # 定义存储位置 global save_path save_path = os.getcwd()+"\Text\"+'短评_差评.txt' global page_max page_max = 25 global comments comments = '' # 获取短评内容 def get_comments(page): req = requests.get(url=page) html = req.content html_doc = str(html, 'utf-8') bf = BeautifulSoup(html_doc, 'html.parser') comment = bf.find_all(class_="short") for short in comment: global comments comments = comments + short.text # 写入文件 def write_txt(chapter, content, code): with codecs.open(chapter, 'a', encoding=code)as f: f.write(content) # 主方法 def main(): for i in range(0, page_max): try: page = server + '?start='+str(i*20)+'&limit=20&sort=new_score&status=P&percent_type=1' get_comments(page) write_txt(save_path, comments, 'utf8') except Exception as e: print(e) if __name__ == '__main__': main()

以下为各类高频词分析

# -*- coding: utf-8 -*- """ @author: Rozmin """ from wordcloud import WordCloud import matplotlib.pyplot as plt import jieba txt = open(r'短评_差评.txt', 'r', encoding='utf-8').read() s = [line.strip() for line in open('CIyun.txt', encoding='utf-8').readlines()] jieba.load_userdict(s) wordcut = jieba.lcut(txt) wdict = {} for word in wordcut: if word not in s: if len(word) == 1: continue else: wdict[word] = wdict.get(word, 0) + 1 wc = list(wdict.items()) wc.sort(key=lambda x: x[1], reverse=True) for i in range(25): print(wc[i]) cut_text = " ".join(wordcut) 'print(cut_text)' mywc = WordCloud(font_path='msyh.ttc').generate(cut_text) plt.imshow(mywc) plt.axis("off") plt.show()

抓取高频词前30

import jieba import os txt = open(os.getcwd()+"\Text\"+"短评_好评.txt","r", encoding='utf-8').read() words = jieba.lcut(txt) counts = {} for word in words: if len(word) == 1: continue else: counts[word] = counts.get(word, 0) + 1 items = list(counts.items()) items.sort(key=lambda x: x[1], reverse=True) for i in range(0, 1): word, count = items[i] print("{0:<6}{1:>6}".format(word, count))

好评的高频词分析:

中评的高频词分析:

差评的高频词分析:

前十好评高频出现词汇:

前十中评高频出现词汇:

前十差评高频出现词汇:

前十高频词汇分析基本没有任何参考价值,基本就是科幻、地球、特效、电影,这些都是电影的基本元素,其它的都是一些中性词汇。

然后,分析了11-30的高频词汇,提取了部分关键词:

好评:

中评:

差评:

总结

同类评分电影中,小破球的一星占比出奇的高。不管是意识形态还是商业利益,《流浪地球》注定要被美分狗和《战狼》PTSD 患者往死里整。《流浪地球》的评价问题已经不仅仅是一部电影的问题。《流浪地球》的口碑一度遭遇了严重下滑,更有人在豆瓣评分上恶意刷评价、改评价,导致电影评分从最初的高分8.5一下狂跌至7.9分。