年前的时候采用scrapy 爬取了某网站的数据,当时只是通过crawl 来运行了爬虫,现在还想通过持续的爬取数据所以需要把爬虫部署起来,查了下文档可以采用scrapyd来部署scrapy项目,scrapyd主要分两部分,一部分是服务器端(scrapyd),一个是客户端(scrapyd-client),服务器端主要聊调度和运行scrapy,客服端主要用于发布scrapy项目。

一.scrapyd 环境搭建

1.安装scrapyd可以采用pip和源码的两种方式安装

i.安装scrapyd

pip install scrapyd

ii.安装scrapyd-client

pip install scrapyd-client

2.运行scrapyd;

i.首先我们需要创建一个目录,用于存储发布我们部署的项目;

ii.执行scrapyd,运行启动,启动成功访问http://127.0.0.1:6800/,显示scrapyd界面,这样scrapyd安装成功;

iii.此时scrapyd只能在本机访问,我们需要去修改配置文件,运行所有的ip都可以访问。配置文件的路径在site-packagesscrapyd目录下,windows配置文件名字是default_scrapyd.conf,把bind_address改成0.0.0.0 这样就可以所有的地址都可以访问。

3.配置scrapyd-client。

i.安装完成scrapyd-client,我们要使用scrapyd-deploy来发布我们项目,但是在window运行scrapyd-deploy会出问题,这时候我们需要在python安装目录Scripts新建一个bat脚本

@echo off "D:Program FilesPythonPython35python.exe" "D:Program FilesPythonPython35Scriptsscrapyd-deploy" %*

说明:前面是python.exe 目录,中间是 scrapyd-deploy 目录,%*代表输入的参数。

以上我们就把scrapyd的服务器端和客户端配置完成了,我们来发布下自己的项目。

二.scrapy 项目发布

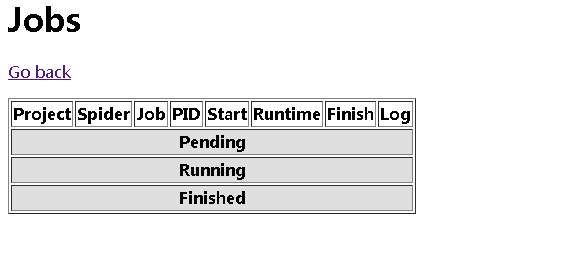

1.scrapyd安装成功,打开http://localhost:6800/ 可以看到scrapyd的一个页面,包括三个选项,jobs(任务),logs(日志),Documentation;

2.点击job可以看到目前运行的任务。

3.发布项目到scrapyd

i.配置scrapy工程scrapy.cfg文件

[settings] default = boss.settings [deploy:boss] #如果多个项目,这里可以添加一个别名 url = http://localhost:6800/ #这里设置scrapyd的服务器地址; project = boss

ii.通过scrapyd-deploy发布项目,需要进入scrapy的工程目录进行发布

scrapyd-deploy boss -p boss

语法:scrapyd-deploy <部署别名> -p 项目名称

发布成功以后,会返回以下结果。

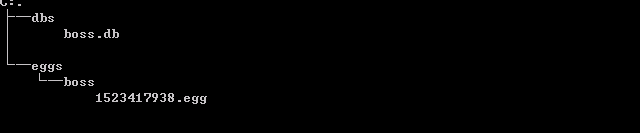

此时会在scrapyd目录下创建一个boss目录,把我们的scrapy项目打成一个egg的压缩文件。

三.启动、停止爬虫

这个时候我们需要调用scrapyd API来运行我们的爬虫。

1.启动爬虫

curl http://localhost:6800/schedule.json -d project=boss -d spider=zhaopin

语法:

curl http://<ip>:6800/schedule.json -d project=<项目名称> -d spider=<spider名称>

以下就是项目发布成功。

也可以在scrapyd管理界面看到项目的运行情况

2.停止爬虫

curl http://localhost:6800/cancel.json -d project=boss -d job=6700d2d43d3c11e8b1eaf8db8a950d02

语法:

curl http://<ip>:6800/cancel.json -d project=<项目名称> -d job=job_id(项目运行成功会返回ID)

3.常用的scrapyd API

1.获取状态 http://127.0.0.1:6800/daemonstatus.json 2.获取项目列表 http://127.0.0.1:6800/listprojects.json 3.获取项目下已发布的爬虫列表 http://127.0.0.1:6800/listspiders.json?project=<项目名称> 4.获取项目下已发布的爬虫版本列表 http://127.0.0.1:6800/listversions.json?project=<项目名称> 5.获取爬虫运行状态 http://127.0.0.1:6800/listjobs.json?project=<项目名称> 6.启动服务器爬虫 http://localhost:6800/schedule.json (post方式,data={"project":<项目名称>,"spider":<spider名称>}) 7.删除某一版本爬虫 http://127.0.0.1:6800/delversion.json (post方式,data={"project":<项目名称>,"version":<版本号>}) 8.删除某一工程,包括该工程下的各版本爬虫 http://127.0.0.1:6800/delproject.json(post方式,data={"project":<项目名称>})

注意:

删除之前需要停止爬虫,才可以再次删除