基础配置

关闭命令:service iptables stop

永久关闭防火墙:chkconfig iptables off

查看防火墙关闭状态 :service iptables status

【1】3台 yum install gcc //安装C语言运行库

【2】

远程上传工具:lrzsz

命令:yum install lrzsz

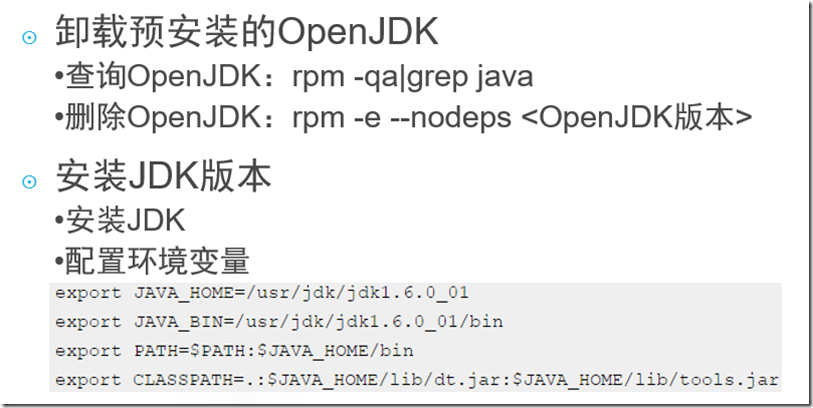

JDK配置

【4】etc/host 配置ip地址 与 主机名

192.168.92.101 macro1

【5】免密码登录

-ssh-keygen -t dsa -P '' -f ~/.ssh/id_dsa //生成私钥 ——3台主机都需要

-cat ~/.ssh/id_dsa.pub >> ~/.ssh/authorized_keys //将私钥追加到公钥 ,亦然

-查看: cd .ssh/ 查看 cat authorized_keys[公钥] id_dsa.pub[私钥]

-将3台机器地公钥同步整合,保持公钥一致【分别将其他两台地公钥加到对应公钥文件中】

===============================================

-分别将macro1刚才安装的Java文件 /usr/local/java 分别远程赋值到macro2 / 3 || -ex:scp ./usr/local/java root@macro2:/usr/local

-同理:将 /etc/host 传到 两外两台

- /etc/profile 同理

==================================

-Hadoop环境配置,同Java环境配置

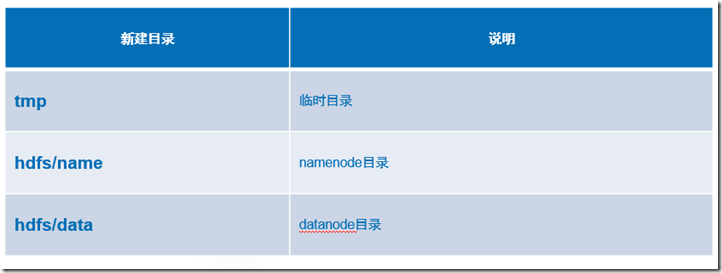

-mkdir temp || mkdir –p hdfs/name[data]

-配置7个配置文件

-将hadoop文件复制到 macro2/3两台主机

-格式化hdfs[bin目录下]: ./hdfs namenode –format [另外两台不需要格式化]——只需要格式化主机即可!

-进入【sbin目录下】 start-dfs.sh 开启datanode amenode

通过:jps查看当前java进程 :另外两台分别启动datanode

网页查看当前服务器状态:http://192.168.92.101:50070/

-进入【sbin目录下】 start-yarn.sh 开启 nodemanager--macro1、2、3三台服务器

通过:jps查看当前java进程 :另外两台分别启动NodeManager

网页查看当前集群状态:http://192.168.92.101:8099/

HDFS的shell操作:基本与Linux操作一致

在tmp路径下信建 wordcount 查询字符个数?

-touch wordcount

- hadoop fs -ls / 查看根目录下的子路径与文件

-hadoop fs –mkdir /input 创建input子目录 + output目录

-hadoop fs –put wordcount /input 将本地wordcount文件上传到 /input路径中

-hadoop fs –get /input/wordcount ./ 将/input/wordcount文件下载到 当前本地目录

-hadoop fs –cat /input/wordcount 查看 服务器 /input/wordcount中的内容

-

==========

-不支持目录切换操作

-

========

rm –rf wordcount 删除本地wordcoun文件t

HDFS原理&架构基本概念

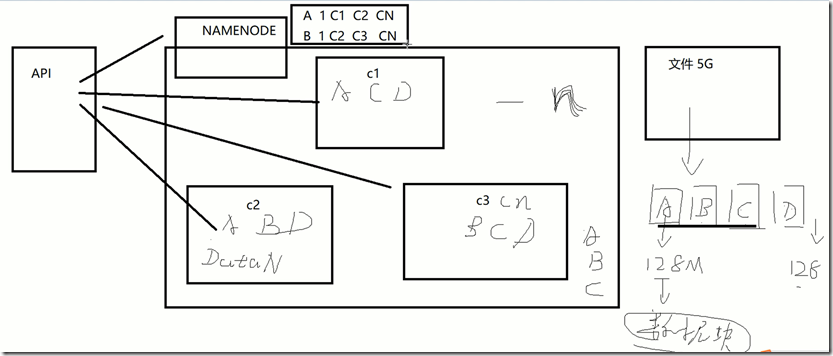

【1】心跳检测:namenode向所有datanode发送空包进行检测。

【2】单点故障:主服务器节点发生故障,从而导致所有集群的成员节点,都无法工作。Namenode【元数据】会挂掉,——管理者节点。

【3】选举策略:从所有成员节点当中,选举出一个新的节点作为主服务器。DataNode【块数据】挂掉——备份机制,3个备份。

============组件

(1) Namenode:负责保存数据的位置,IP,顺序等等信息,本身保存元数据

(2) Datanode:负责保存块数据

(3) 数据块:hadoop版本不同,定义不同

① 1.0:64M

② 2.0:128M

(4) 机架:包含了若干个datanode的一个资源划分,通常情况下有hadoop自行划分

Haddop

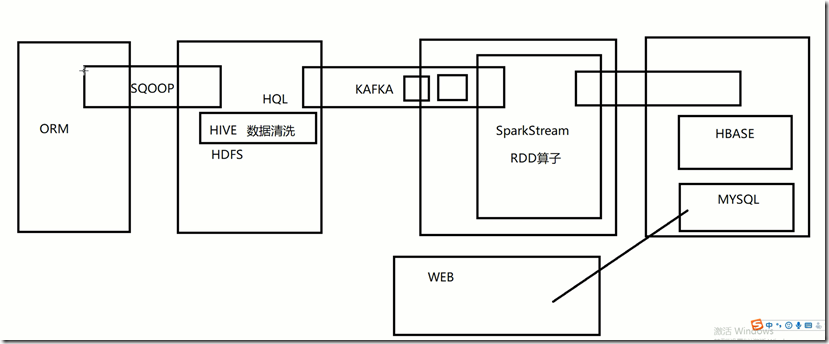

通过这种实现大数据应用:+echars实现大数据应用

存储系统:数据块分割

SecondaryNameNode:文件资源管理器! ——保持节点当中的数据分配均衡!

hive:基础的大数据应用。