第一章 绪论

1.1 引言

机器学习致力于研究如何通过计算的手段,利用经验(计算机系统中通常以数据的形式存在)来改善系统自身的性能。

机器学习研究的主要内容是关于在计算机上从数据中产生模型的算法,即学习算法(learning algorithm)。

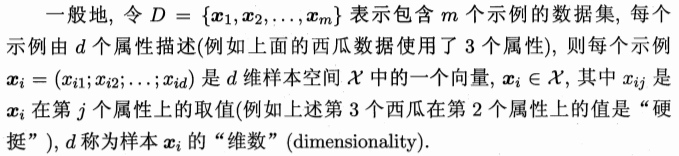

1.2 基本术语

数据集(data set)

示例(instance) / 样本(sample):也叫作特征向量(feature vector)

属性(attribute) / 特征(feature)

属性值(attribute value)

属性空间(attribute space) / 样本空间(sample space):属性张成的空间。

training data

训练样本(training sample)

训练集(training set):训练样本组成的集合

hypothesis

ground-truth:指潜在规律自身

prediction

标记(label)

样例(example):拥有了label信息的示例称为example.

一般地,用 (xi , yi) 表示第 i 个样例。其中 yi ∈ Y 是 xi 的label,Y是所有标记的集合,亦称为标记空间(label space)或输出空间。

若我们想要预测的是离散值,则此类学习任务称为分类(classification);

若我们想要预测的是连续值,则此类学习任务称为回归(regression)。

对只涉及两个类别的二分类(binary classification)任务,通常称其中一个类为正类(positive class),另一个类为反类 / 负类(negative class);

涉及多个类别时,则称为多分类(multi-class classification)任务。

测试样本(testing sample)

聚类(clustering)

簇(cluster)

学习任务大致可以分为两大类:监督学习(supervised learning)和无监督学习(unsupervised learning),分类和回归是前者的代表,聚类是后者的代表。

学得模型适用于新样本的能力,称为泛化(generalization)能力。具有强泛化能力的模型能很好地适用于整个样本空间。

通常假设样本空间中全体样本服从一个未知分布(distribution)D,我们获得的每个样本都是独立的从这个分布上采样获得的,及独立同分布(independent and identically distributed,简称 i.i.d.)。

一般而言,训练样本越多,我们得到的关于D的信息越多,这样就越有可能通过学习获得具有强泛化能力的模型。

1.3 假设空间

归纳(induction)和演绎(deduction)是科学推理的两大基本手段。

前者是从特殊到一般的泛化过程,即从具体的事实归结出一般性规律;后者是从一般到特殊的特化过程,即从基础原理推演出具体状况。

可以把学习过程看作一个在所有假设组成的空间中进行搜索的过程,搜索目标是找到与训练集匹配的假设。假设一旦确定,假设空间极其规模大小就确定了。

现实问题中我们常面临很大的假设空间,但学习过程是基于有限样本训练集进行的,因此可能有多个假设与训练集一致,即存在一个与训练集一致的假设集合,称之为版本空间(version space)。

1.4 归纳偏好

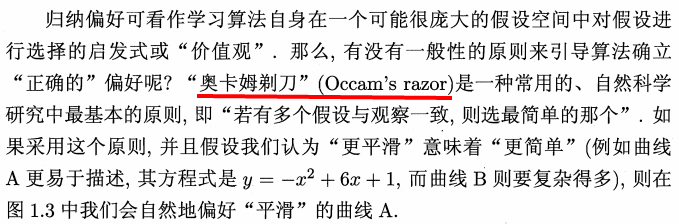

机器学习算法在学习过程中对某种类型假设的偏好称为归纳偏好(inductive bias),或简称为偏好。

事实上,归纳偏好对应了学习算法本身所做出的关于“什么样的模型更好”的假设。在具体的现实问题中,这个假设是否成立,即算法的归纳偏好是否与问题本身匹配,大多数时候直接决定了算法能否取得好的性能。

对于一个学习算法Ea,若它在某些问题上比学习算法Eb好,则必然存在另一些问题,在哪里Eb比Ea好。这个结论对任何算法均成立。

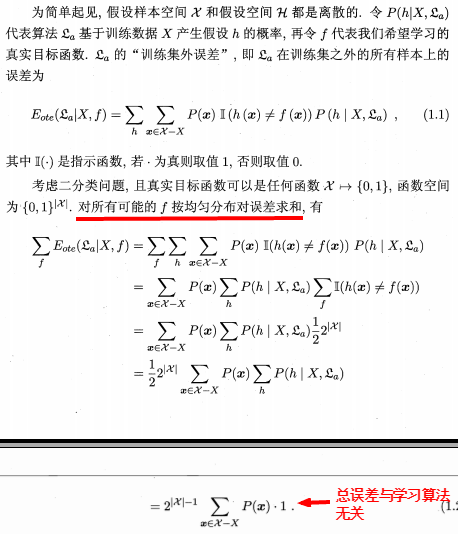

No Free Lunch Theorem (NFL定理,没有免费午餐定理)

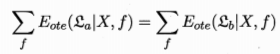

即对于任意两个学习算法Ea和Eb我们都有:

这就是没有免费午餐定理(No Free Lunch Theorem,简称NFL定理)。

NFL定理有一个重要前提:所有“问题”出现的机会相同、或所有问题等同重要。但实际情形并不是这样,很多时候我们只关注自己正在试图

解决的问题。

1.5 发展历程

略

1.6 应用现状

略

1.7 阅读材料