json与pickle模块

1、什么是序列化&反序列化

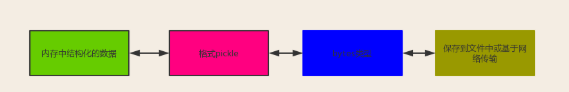

内存中的数据类型---->序列化---->特定的格式(json格式或者pickle格式)

内存中的数据类型<----反序列化<----特定的格式(json格式或者pickle格式)

土办法:

{'aaa':111}--->序列化str({'aaa':111})----->"{'aaa':111}"

{'aaa':111}<---反序列化eval("{'aaa':111}")<-----"{'aaa':111}"

2、为何要序列化

序列化得到结果=>特定的格式的内容有两种用途

1 可用于存储=》用于存档

2 传输给其他平台使用=》跨平台数据交互

# python java

# 列表 特定的格式 数组

强调:

针对用途1的特定一格式:可是一种专用的格式=》pickle只有python可以识别

针对用途2的特定一格式:应该是一种通用、能够被所有语言识别的格式=》json(通用)

3、如何序列化与反序列化

示范1

import json

# 序列化json.dumps

json_res=json.dumps([1,'aaa',True,False])

print(json_res,type(json_res)) # "[1, "aaa", true, false]",这个true不是python中判断的那个true,仅仅只是输出结果而已

一定要双引号""

# 反序列化jsonloads

l=json.loads(json_res)

print(l,type(l))

示范2:

import json

序列化的结果写入文件的复杂方法

json_res=json.dumps([1,'aaa',True,False])

print(json_res,type(json_res)) # "[1, "aaa", true, false]"

with open('test.json',mode='wt',encoding='utf-8') as f:

f.write(json_res)

将序列化的结果写入文件的简单方法dump

with open('test.json',mode='wt',encoding='utf-8') as f:

json.dump([1,'aaa',True,False], f)

从文件读取json格式的字符串进行反序列化操作的复杂方法

with open('test.json',mode='rt',encoding='utf-8') as f:

json_res=f.read()

l=json.loads(json_res)

print(l,type(l))

从文件读取json格式的字符串进行反序列化操作的简单方法

with open('test.json',mode='rt',encoding='utf-8') as f:

l=json.load(f)

print(l,type(l))

json验证: json格式兼容的是所有语言通用的数据类型,不能识别某一语言的所独有的类型

json.dumps({1,2,3,4,5})

# json强调:一定要搞清楚json格式,不要与python混淆

l=json.loads('[1, "aaa", true, false]') #字符串一定要用""

l=json.loads("[1,1.3,true,'aaa', true, false]")

print(l[0])

# 了解

l = json.loads(b'[1, "aaa", true, false]')

print(l, type(l))

with open('test.json',mode='rb') as f:

l=json.load(f)

res=json.dumps({'name':'哈哈哈'})

print(res,type(res))

res=json.loads('{"name": "u54c8u54c8u54c8"}')

print(res,type(res))

4、猴子补丁ujson

1 什么是猴子补丁?

猴子补丁的核心就是用自己的代码替换所用模块的源代码

2 猴子补丁的功能(一切皆对象)

拥有在模块运行时替换的功能, 例如: 一个函数对象赋值给另外一个函数对象(把函数原本的执行的功能给替换了)

3 monkey patch的应用场景

如果我们的程序中已经基于json模块编写了大量代码了,发现有一个模块ujson比它性能更高,但用法一样,我们肯定不会想所有的代码都换成ujson.dumps或者ujson.loads,那我们可能会想到这么做

# 在入口处打猴子补丁

import json

import ujson

def monkey_patch_json():

json.__name__ = 'ujson'

json.dumps = ujson.dumps

json.loads = ujson.loads

monkey_patch_json() # 在入口文件出运行

import ujson as json # 不行!!!!!因为这么做的需要每个文件都重新导入一下,维护成本依然很高

# 后续代码中的应用,自动沿用第一次导入的信息

json.dumps()

json.dumps()

json.dumps()

json.dumps()

json.dumps()

json.dumps()

json.dumps()

json.dumps()

json.loads()

json.loads()

json.loads()

json.loads()

json.loads()

json.loads()

json.loads()

json.loads()

json.loads()

json.loads()

json.loads()

pickle模块

import pickle

res = pickle.dumps({1, 2, 3, 4, 5})

print(res, type(res)) #输出类型是byte,b'x80x04x95......

s = pickle.loads(res)

print(s, type(s))

Pickle的问题和所有其他编程语言特有的序列化问题一样,就是它只能用于Python,并且可能不同版本的Python彼此都不兼容,因此,只能用Pickle保存那些不重要的数据,不能成功地反序列化也没关系

# coding:utf-8

import pickle

with open('a.pkl',mode='wb') as f:

# 一:在python3中执行的序列化操作如何兼容python2

# python2不支持protocol>2,默认python3中protocol=4

# 所以在python3中dump操作应该指定protocol=2

pickle.dump('你好啊',f,protocol=2)

with open('a.pkl', mode='rb') as f:

# 二:python2中反序列化才能正常使用

res=pickle.load(f)

print(res)

configparser模块

import configparser

config = configparser.ConfigParser()

config.read('test.ini')

1、获取sections

print(config.sections())

2、获取某一section下的所有options,查看标题section1下所有key=value的key

print(config.options('section1'))

3、查看标题section1下所有key=value的(key,value)格式

print(config.items('section1'))

4、查看标题section1下user的值=>字符串格式

res = config.get('section1', 'user')

print(res, type(res))

5、查看标题section1下age的值=>整数格式

res = config.getint('section1', 'age')

print(res, type(res))

6、查看标题section1下is_admin的值=>布尔值格式

res = config.getboolean('section1', 'is_admin')

print(res, type(res))

7、查看标题section1下salary的值=>浮点型格式

res = config.getfloat('section1', 'salary')

print(res, type(res))

改写

import configparser

config=configparser.ConfigParser()

config.read('a.cfg',encoding='utf-8')

#删除整个标题section2

config.remove_section('section2')

#删除标题section1下的某个k1和k2

config.remove_option('section1','k1')

config.remove_option('section1','k2')

#判断是否存在某个标题

print(config.has_section('section1'))

#判断标题section1下是否有user

print(config.has_option('section1',''))

#添加一个标题

config.add_section('egon')

#在标题egon下添加name=egon,age=18的配置

config.set('egon','name','egon')

config.set('egon','age',18) #报错,必须是字符串

#最后将修改的内容写入文件,完成最终的修改

config.write(open('a.cfg','w'))

import configparser

config = configparser.ConfigParser()

config["DEFAULT"] = {'ServerAliveInterval': '45',

'Compression': 'yes',

'CompressionLevel': '9'}

config['bitbucket.org'] = {}

config['bitbucket.org']['User'] = 'hg'

config['topsecret.server.com'] = {}

topsecret = config['topsecret.server.com']

topsecret['Host Port'] = '50022' # mutates the parser

topsecret['ForwardX11'] = 'no' # same here

config['DEFAULT']['ForwardX11'] = 'yes'

with open('example.ini', 'w') as configfile:

config.write(configfile)v

hashlib模块

1、什么叫hash?

hash是一种算法(3.x里代替了md5模块和sha模块,主要提供 SHA1, SHA224, SHA256, SHA384, SHA512 ,MD5 算法),该算法接受传入的内容,经过运算得到一串hash值

2、hash值的特点是:

2.1 只要传入的内容一样,得到的hash值必然一样=====>要用明文传输密码文件完整性校验

2.2 不能由hash值返解成内容=======》把密码做成hash值,不应该在网络传输明文密码

2.3 只要使用的hash算法不变,无论校验的内容有多大,得到的hash值长度是固定的

3、如何用

应用场景:

# 用途1:特点II用于密码密文传输与验证

# 用途2:特点I、III用于文件完整性校验

import hashlib

m=hashlib.md5()

m.update('hello'.encode('utf-8'))

m.update('world'.encode('utf-8'))

res=m.hexdigest() # 'helloworld'

print(res)

m1=hashlib.md5('he'.encode('utf-8'))

m1.update('llo'.encode('utf-8'))

m1.update('w'.encode('utf-8'))

m1.update('orld'.encode('utf-8'))

res=m1.hexdigest() # 'helloworld'

print(res)

模拟撞库

cryptograph='aee949757a2e698417463d47acac93df'

import hashlib

# 制作密码字段

passwds=[

'alex3714',

'alex1313',

'alex94139413',

'alex123456',

'123456alex',

'a123lex',

]

dic={}

for p in passwds:

res=hashlib.md5(p.encode('utf-8'))

dic[p]=res.hexdigest()

# 模拟撞库得到密码

for k,v in dic.items():

if v == cryptograph:

print('撞库成功,明文密码是:%s' %k)

break

# 提升撞库的成本=>密码加盐

import hashlib

m=hashlib.md5()

m.update('天王'.encode('utf-8'))

m.update('alex3714'.encode('utf-8'))

m.update('盖地虎'.encode('utf-8'))

print(m.hexdigest())

python 还有一个 hmac 模块,它内部对我们创建 key 和 内容 进行进一步的处理然后再加密:

import hmac

h1=hmac.new('hello'.encode('utf-8'),digestmod='md5')

h1.update('world'.encode('utf-8'))

print(h1.hexdigest())

复制代码

#要想保证hmac最终结果一致,必须保证:

#1:hmac.new括号内指定的初始key一样

#2:无论update多少次,校验的内容累加到一起是一样的内容

# 操作一

import hmac

h1=hmac.new('hello'.encode('utf-8'),digestmod='md5')

h1.update('world'.encode('utf-8'))

print(h1.hexdigest()) # 0e2564b7e100f034341ea477c23f283b

# 操作二

import hmac

h2=hmac.new('hello'.encode('utf-8'),digestmod='md5')

h2.update('w'.encode('utf-8'))

h2.update('orld'.encode('utf-8'))

print(h1.hexdigest()) # 0e2564b7e100f034341ea477c23f283b

subprocess模块

#为了执行系统的命令存在的

# 等同于上面,但是上面的优势在于,一个数据流可以和另外一个数据流交互,可以通过爬虫得到结果然后交给grepimport subprocess

obj=subprocess.Popen('echo 123 ; ls / ; ls /root',shell=True,

stdout=subprocess.PIPE, # stdout是标准正确输出

stderr=subprocess.PIPE, # stderr错误结果输出

)

print(obj)

res=obj.stdout.read()

print(res.decode('utf-8'))

# print(res.stdout.read().decode('gbk')) #subprocess使用当前系统默认编码,得到结果为bytes类型,在windows下需要用gbk解码

err_res=obj.stderr.read()

print(err_res.decode('utf-8'))