郑重声明:原文参见标题,如有侵权,请联系作者,将会撤销发布!

Neural Networks, (2020): 88-100

Abstract

以快速流的形式生成大量数据的应用正变得越来越普遍,因此有必要以在线方式学习。这些条件通常会施加内存和处理时间限制,并且它们通常会变成不断变化的环境,其中的变化可能会影响输入数据的分布。这种变化会导致在这些流数据上训练的预测模型变得过时并且不能适当地适应新的分布。特别是在这些非平稳场景中,迫切需要新算法能够尽快适应这些变化,同时保持良好的性能分数。不幸的是,大多数现成的分类模型如果在不断变化的环境中使用,并且无法正确扩展,则需要重新训练。脉冲神经网络已成为模拟大脑行为和学习潜力的最成功方法之一,并利用它们来承担实际的在线学习任务。此外,脉冲神经网络的一些特定风格可以克服在发生漂移后重新训练的必要性。这项工作旨在通过作为一个全面的概述来合并这两个领域,推动进一步发展,将脉冲神经网络纳入在线学习场景,并成为非专家的友好切入点。

Keywords: Online learning, spiking neural networks

1. Introduction

由于从几乎任何来源收集数据并进行分析以实现基于数据的洞察力,从而实现成本和时间减少、新产品开发、优化产品或智能决策的可行性,大数据一词在过去十年中获得了进步的动力,其中包括利润。在这些大数据场景中,一些特性可能会起到相关作用:存储整个数据集不可行,传统算法无法处理高速产生的数据,学习过程中可能会发生数据分布的变化。越来越多的应用基于这些持续可用的训练数据(流学习),并应用于实际场景,例如手机、传感器网络、工业过程控制和智能用户界面等。其中一些应用会产生越来越普遍的非平稳数据流,并且生成数据的过程可能会随着时间的推移而发生变化,从而导致要建模的模式发生变化(概念漂移)。这导致在这些流数据上训练的预测模型变得过时并且不能适当地适应新的分布。特别是在线学习(OL)场景中,每个时刻只向学习算法提供一个样本,迫切需要新算法尽可能快地适应这些变化,同时保持良好的性能分数。在过去几年中,存在概念漂移的OL一直是一个非常热门的话题,并且因其众多公开的挑战而在社区中仍然存在积极辩论。数据挖掘社区更喜欢将存在概念漂移的OL称为数据流挖掘。

许多基于机器学习(ML)技术的流学习算法已经开发出来。不幸的是,大多数现成的模型如果在不断发展的环境中使用,则需要重新训练,并且由于其学习算法而无法正确扩展。人工神经网络(ANN)在过去几年中已被用于处理这些快速发展的信息流。从本质上讲,它们是一种受生物学启发的范式,它模仿大脑获取和处理感官信息的过程。他们在生物学上最合理的神经元模型之一是所谓的脉冲神经网络(SNN)的关键组成部分,这是一种广受欢迎的知名模型,能够捕捉在真实生物神经元中观察到的信息动态,并且将多个信息维度(例如时间、空间、频率、相位以及处理大量数据)表示和集成到单个模型中。SNN背后的理论目前大多被接受来描述现实的类脑信息处理,这另外简化了它们在超快速和可靠的硬件平台上的实现。

如今被视为第三代人工神经网络,SNN的出现是由于需要更好地了解哺乳动物大脑的信息处理技能,为此社区致力于开发更复杂的生物联结系统。一些SNN在OL研究界尤其出名,因为它们具有持续增量学习的能力,这说明它们对非平稳和不断发展的环境具有持续的适应性,以及它们作为漂移检测器的能力。此外,他们还展示了捕获流数据中时间变量之间的时间关联的能力。

从上面公开的所有基本原理来看,两个领域的合并激发了进一步发展,将SNN用于OL场景,重点是那些需要概念漂移检测和适应的场景。这项工作旨在为这两个领域的非专家提供合适的文献切入点,以及未来在该方向上投资的研究工作的催化材料;它的组织方式如下:第2节和第3节分别介绍了OL场景和SNN的挑战和未来工作,第4节深入研究了这两个领域的融合。最后,第5节得出与本研究相关的结论。

2. Online Learning

在流学习中,数据可能以数据块(批学习)或在线方式到达,即一次一个样本(OL)。在批处理学习中,提供了一组完全可访问的样本(批处理),并且允许学习算法在构建/更新模型之前扫描批处理。然而,在OL中,每个时刻只向学习算法提供一个样本,每次新样本到达时都会增量更新。与传统的批学习设置相比,OL环境强加了不同的计算约束:

- 每个样本在到达时只处理一次,模型必须能够在收到样本后立即按顺序处理样本,而不会危及存储空间和处理时间的限制;

- 每个样本的处理时间必须小且恒定,不能超过新样本到达的速度;

- 该算法应仅使用预先分配的有限内存量;

- 每次扫描数据流时都必须有一个有效的模型; 和

- 学习算法必须生成一个模型,该模型与在批学习场景中构建的模型等效。

在批学习中,学习算法的评估过程由用于训练和测试的样本集决定。在这方面为OL提出的问题是如何构建一段时间内的准确性图。最常用的方案之一是先测试后训练,其中每个样本在用于训练之前先对模型进行测试,然后可以增量更新准确率。该方案的优点是可以在内存受限且没有用于测试的保留集时应用,从而充分利用可用数据集。接下来,我们介绍存在概念漂移的OL问题,这可能是OL中最具挑战性的方面,是过去十年中非常热门的主题研究。

2.1. Concept Drift

2.2. Applications

2.3. Available Open Software/Frameworks

2.4. Recent Challenges and Future Trends

3. Spiking Neural Networks (SNNs)

仿生系统的计算能力引起了研究界越来越多的关注(Kasabov, 2019)。尽管对大脑中涉及的信息处理缺乏共识,但生物过程已成为最近计算模型的参考。ANN在结构和功能方面被开发为生物神经网络的简化版本。SNN已成为新一代神经网络,它是一种通过利用脉冲、通过神经连接性和可塑性结合空间和时间概念的更符合生物现实的方法。它们处理精确的时序脉冲,在准确性和计算能力方面改进了传统ANN,由于其简单的IF性质,它们可能更适合硬件实现(参见第3.3节)。SNN的硬件实现有几个权衡:没有传统模型中的乘法,可以使用移位和加法实现脉冲处理,互连仅传输一位而不是实数。稀疏异步通信也可以轻松实现。然而,应该指出的是,当在通用计算机平台中实现SNN时,这种潜在的优势还没有体现出来。为了与一些统计方法(例如多元线性回归、k-最近邻、支持向量机等)和第二代ANN(例如多层感知器、卷积神经网络等)进行比较,对SNN有一个概览,我们展示了表1。

我们想强调模型解释的重要性。通过构建模型可视化或提取控制SNN模型的规则集,我们能够解释模型学习背后的内部机制。与其他ANN很难深入了解网络并弄清楚它究竟学到了什么或如何学习相比,一些SNN让我们能够了解它们的学习过程(Soltic & Kasabov, 2010)。

在完成本小节之前,先介绍SNN的一些问题。它们高度依赖于大量参数的优化,它们对不同类型的时空数据表现出未知的行为,并且它们缺乏关于最优信息编码方案和神经元模型的坚实共识。尽管有这些限制,但它们是ML中最有前途的技术之一。现在将范围放在SNN上(参见图3),提供对这个连接主义模型系列的总体概述,展示它们的原理、当前应用以及未来趋势和挑战(Kasabov, 2018)。

3.1. Biological Inspiration

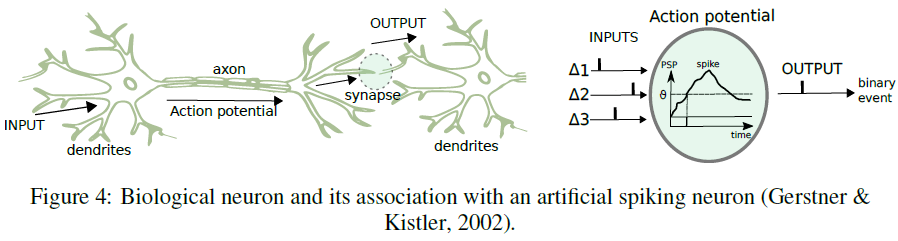

受大脑启发的神经网络在大脑处理信息的方式方面表现出相似性,它们与使用脉冲的神经元单元的计算有着内在的联系。脉冲的利用汇集了时变突触后电位(PSP)、发放阈值(υ)和脉冲延迟(Δ)的定义,如图4所示。他们试图在网络中模拟神经元之间执行的过程(突触)。

3.2. Data and Information Representation as Spikes

在将输入数据呈现给SNN之前,必须将其编码为脉冲序列以应用神经元模型。这个编码部分旨在生成表示输入刺激的脉冲模式,它仍然是神经科学中的一个悬而未决的问题(这种脉冲时空模式中包含的信息是什么?神经元用来传输这些信息的代码是什么?其他神经元如何解码信号?,等),但传统上已经表明,大多数相关信息都包含在神经元的平均发放率中。在文献中,我们可以找到两种主要的编码方案:时间编码和基于发放率的编码(见图5)。当编码窗口内的模式提供无法从脉冲计数获得的有关刺激的信息时,第一个用于后一个。基于发放率的编码方案基于时间间隔(例如频率)内的脉冲特性,在时序编码方案中,信息在脉冲时间被编码。

基于发放率的编码方案("作为脉冲计数的发放率"、"作为脉冲密度的发放率"和"作为群体活动的发放率")对应于平均发放率的三个不同概念(分别是随时间的平均值,或多次重复实验的平均值,或一组神经元的平均值)。时序编码方案基于脉冲时间:"初次脉冲时间"(当初次脉冲时间的代码包含有关新刺激的所有信息时),"相位"(当我们可以应用"time-to-first-spike"编码方案,其中参考信号不是单个事件,而是一个周期信号)和"相关性和同步"(我们使用来自其他神经元的脉冲作为脉冲代码的参考信号)。

3.3. Spiking Neuron Models

3.4. Learning Methods and Algorithms in SNN

3.5. Applications

3.6. Available Hardware and Software/Frameworks

3.7. Recent Challenges and Future Trends

4. SNNs in Online Learning Scenarios

数据流可能会表现出类别标签之间的时间依赖性,只要当前样本标签yt受先前样本标签(yt-1, yt-2, ...)的影响,就会出现这种情况。时间依赖性有助于确定输入特征随时间的变化如何相互关联。SNN利用脉冲信息表示来构建脉冲时间学习规则,该规则已显示出捕获流数据中时间变量之间的时间关联能力。此外,STDP和Hebbian学习是SNN模型中生物学合理的局部学习规则;在OL中使用一些SNN(例如eSNN)可以实现非常快的实时性并降低学习过程的计算复杂性,因为它的局部性非常适合并行实现。在适应漂移方面,大多数现成的分类模型如果在不断变化的环境中使用,并且无法正确扩展,则需要重新训练。一些SNN可以克服这个缺点,例如eSNN的进化特性(基于相似神经元的合并过程)使得随着数据可用而积累知识成为可能,而无需使用过去的样本存储和重新训练模型。最后,它们作为概念漂移检测器也表现出非常有竞争力。

4.1. Existing SNN Approaches for Online Learning: Drawbacks and Trade-offs

4.2. Topics of Future Interest

5. Conclusions