http://www.ruanyifeng.com/blog/2012/02/ranking_algorithm_hacker_news.html

http://www.ruanyifeng.com/blog/2012/03/ranking_algorithm_reddit.html

http://www.ruanyifeng.com/blog/2012/03/ranking_algorithm_stack_overflow.html

http://www.ruanyifeng.com/blog/2012/03/ranking_algorithm_newton_s_law_of_cooling.html

http://www.ruanyifeng.com/blog/2012/03/ranking_algorithm_wilson_score_interval.html

http://www.ruanyifeng.com/blog/2012/03/ranking_algorithm_bayesian_average.html

本文内容

- Delicious 和 Hacker News

- Stack Overflow

- 牛顿冷却定律

- 威尔逊区间

- 贝叶斯平均

互联网的出现,意味着"信息大爆炸"。用户担心的,不再是信息太少,而是信息太多。如何从大量信息之中,快速有效地找出最重要的内容,成了互联网的一大核心问题。

各种各样的排名算法,是目前过滤信息的主要手段之一。对信息进行排名,意味着将信息按照重要性依次排列,并且及时进行更新。排列的依据,可以基于信息本身的特征,也可以基于用户的投票,即让用户决定,什么样的信息可以排在第一位。

下面,我将整理和分析一些基于用户投票的排名算法。

Delicious 和 Hacker News

Delicious

该算法是最直接、最简单的算法,它按单位时间内用户的投票数进行排名。得票最多的 item 排在第一位。旧版 Delicious,有一个“热门书签排行榜”,就是这样统计出来的。如图 1 所示:

图 1

每过 60 分钟,就统计一次。按照“60分钟内被收藏的次数”进行排名。

该算法优点是,简单、易部署、内容更新相当快;但缺点主要有两个,1)排名变化不够平滑,前一个小时还排名靠前的item,第二个小时就一落千丈,2)缺乏自动淘汰旧 item 的机制,即某些热门内容可能会长期占据排行榜前列。

Hacker News

Hacker News 是一个网络社区,可以张贴链接,或者讨论某个主题。如图 2 所示:

图 2

每个帖子前面有一个“向上的小三角”,如果你觉得这个帖子很好,就点击,投上一票。根据得票数,系统自动统计出热门文章排行榜。

但是,并非得票最多的文章就应该排在第一位,还要考虑时间因素,新文章应该比旧文章更容易得到好的排名。

Hacker News 使用 Paul Graham 开发的 Arc 语言编写,源码可以从 arclanguage.org 下载。算法如图 3 所示:

图 3

该算法的数学公式为:

其中,

- P 表示帖子得票数,“减去1”表示忽略发帖人的投票。

- T 表示距离发帖的时间(单位为小时),“加上 2”表示防止对于最新的帖子,导致分母过小(之所以选择 2,可能是因为从原始文章出现在其他网站,到转贴至 Hacker News,平均需要两个小时)。

- G 表示“重力因子(gravityth power)”,即将帖子排名往下拉的力量,默认值为 1.8,后文会详细讨论这个值。

从这个公式来看,决定帖子的排名有三个因素:

- 票数 P。在其他条件不变的情况下,得票越多,排名越高。

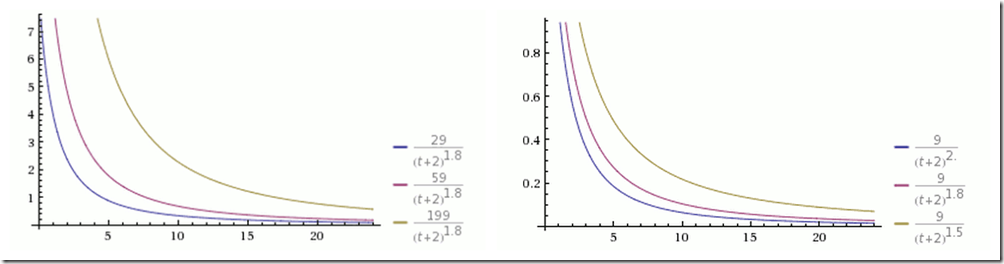

图 4

从图 4 左边看,同时发布三个帖子,颜色依次为黄色、紫色和蓝色,得票分别为 200、60 和 30,那么减1后分别为 199、59 和 29。在任一时间点上,都是黄色在最上方,蓝色曲线在最下方。

如果你不想让“高票帖子”与“低票帖子”的差距过大,可以在得票数上加一个小于 1 的指数,如 ![]() 。

。

- 距离发帖的时间 T。在其他条件不变的情况下,越是新发表的帖子,排名越高。或者说,一个帖子的排名,会随着时间而不断下降。因此,从图 4 看到,经过 24 小时后,所有帖子的得分基本上都小于 1,这意味着它们都将跌到排行榜的末尾,保证了排名前列的都将是较新的内容。

- 重力因子 G。它的数值大小决定了排名随时间下降的速度。从图 4 右边看到,三个曲线的其他参数都一样,G 的值分别为 1.5、1.8 和 2.0。G 值越大,曲线越陡峭,排名下降得越快,意味着排行榜的更新速度越快。

知道了算法的构成,就可以调整参数的值,以适用你自己的应用程序。

参考文献

[1] How Hacker News ranking algorithm works

[2] How to Build a Popularity Algorithm You can be Proud of

上面 Hacker News 排名算法只能投赞成票,可用户当然也需要投反对票。或者说,除了好评以外,还可以给差评。

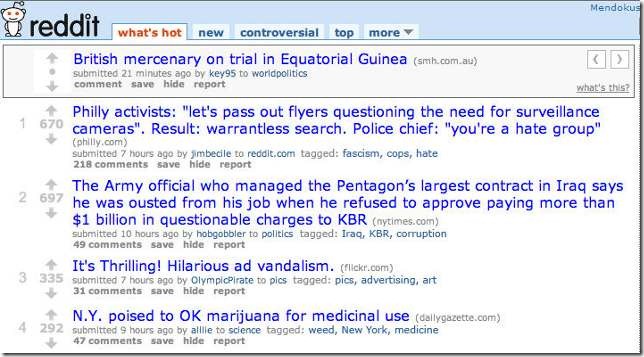

Reddit 是美国最大的网上社区,每个帖子前面都有“向上”和“向下”箭头,分别表示“赞成”和“反对”。用户点击进行投票,Reddit根据投票结果,计算出最新的“热点文章排行榜”。如图 6 所示。

图 5

算法

如何将赞成票和反对票结合起来,计算出一段时间内最受欢迎的文章?如果文章 A 有 100 张赞成票、5 张反对票;文章 B 有 1000 张赞成票、950 张反对票,谁应该排在前面呢?

Reddit 程序是开源的,使用 Python 语言编写。排名算法如图 6:

图 6 Reddit 算法

该算法考虑了 4 个因素,包括帖子新旧程度、投票赞成与反对的差、投票倾向和帖子受肯定(否定)程度:

1)帖子新旧程度 t

其中,t 单位为秒,用 Unix 时间戳计算。不难看出,一旦帖子发表,t 就是固定值,不会随时间改变,而且帖子越新,t 值越大。至于,2005 年 12 月 8 日应该是 Reddit 成立的时间。

2)赞成票与反对票的差 x

3)投票倾向 y

其中,y 是一个符号变量,表示对文章的总体看法。如果赞成票居多,y 就是 +1;如果反对票居多,y 就是 -1;如果赞成票和反对票相等,y 就是 0。

4)帖子的受肯定(否定)的程度 z

其中,z 表示赞成票与反对票之间差额的绝对值。如果对某个帖子的评价,越是一边倒,z 就越大。如果赞成票等于反对票,z 就等于 1。

结合以上四个因素,Reddit 计算公式如下:

其中,

需要注意的是,这里用的是以10为底的对数,意味着z=10可以得到1分,z=100可以得到2分。也就是说,前10个投票人与后90个投票人(乃至再后面900个投票人)的权重是一样的,即如果一个帖子特别受到欢迎,那么越到后面投赞成票,对得分越不会产生影响。

当赞成票等于反对票,z=1,因此这个部分等于0,也就是不产生得分。

![clip_image002[5] clip_image002[5]](https://images0.cnblogs.com/blog/321721/201307/24001553-d3130c252b004549937a8529d86c48c3.gif) 表示,其中,

表示,其中, - t 越大,得分越高,即新帖子的得分会高于老帖子。它起到自动将老帖子的排名往下拉的作用。

- 分母 45000 秒,等于 12.5 个小时,即后一天的帖子比前一天的帖子多得 2 分。结合前一部分,可以得到结论,如果前一天的帖子在第二天还想保持原先的排名,在这一天里面,它的 z 值必须增加 100 倍(净赞成票增加 100 倍)。

- y 的作用是产生加分或减分。当赞成票超过反对票时,这一部分为正,起到加分作用;当赞成票少于反对票时,这一部分为负,起到减分作用;当两者相等,这一部分为 0。这就保证了得到大量净赞成票的文章,会排在前列;赞成票与反对票接近或相等的文章,会排在后面;得到净反对票的文章,会排在最后(因为得分是负值)。

特点

这个算法的一个问题是,对于那些有争议的文章(赞成票和反对票非常接近),它们不可能排到前列。假定同一时间有两个帖子发表,文章A有 1 张赞成票(发帖人投的)、0 张反对票;文章 B 有1000 张赞成票、1000 张反对票,那么 A 的排名会高于 B,这显然不合理。因此,Reddit 排名,基本上由发帖时间决定,超级受欢迎的文章会排在最前面,一般性受欢迎的文章、有争议的文章都不会很靠前。这决定了 Reddit 是一个符合大众口味的社区,不是一个很激进、可以展示少数派想法的地方。

参考资料

[1] How Reddit ranking algorithms work

Stack Overflow

上面 Reddit 算法,用户可以投赞成票,也可以投反对票。即,除了时间外,只需要考虑两个因素。

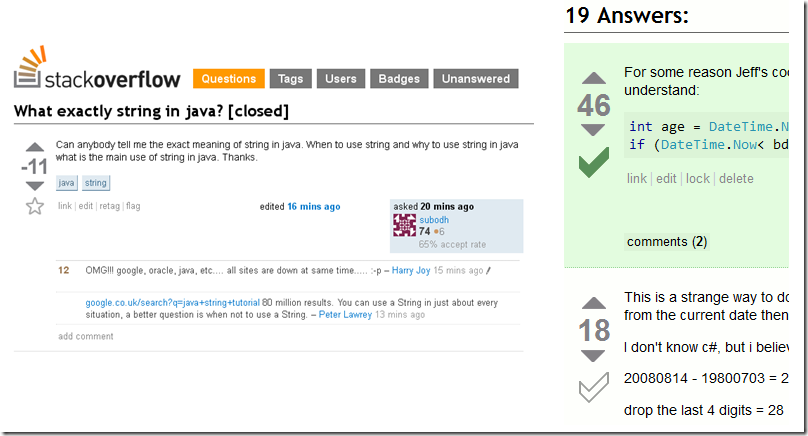

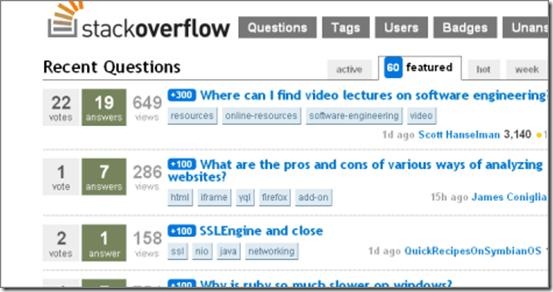

但是,对于一些特定的网站,必须考虑更多的因素,如世界排名第一的程序员问答社区 Stack Overflow,就是这样。你在上面提出各种关于编程的问题,然后等待别人回答。访问者可以对你的问题进行投票(赞成或反对),以表示这个问题是否有价值。一旦有人回答了你的问题,那么,其他人也可以对这个回答投票(赞成或反对),以表明对这个回答的态度。

图 7 Stack Overflow 网站(左:对问题的投票;右:对问题回答的投票)

排名算法的作用是,找出某段时间内的热点问题,即哪些问题最被关注、得到了最多的讨论。

在Stack Overflow 页面上,每个问题前面有三个数字,分别表示问题的得分、回答数,以及该问题的浏览次数。以这些变量为基础,就可以设计算法了。

图 8

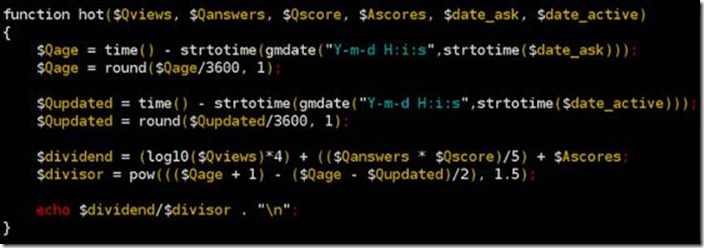

创始人之一 Jeff Atwood,几年前,公开了该算法的计算公式。

用 php 语言如图 ,就是下面这样:

图 9

其中,

1)问题的浏览次数Qviews

某个问题的浏览次数越多,代表越受关注,得分也就越高。使用以10为底的对数,是当访问量越来越大,它对得分的影响将不断变小。

2)问题得分Qanswers和回答的数量Qscore

其中,

- Qscore = 赞成票-反对票。如果某个问题越受到好评,排名自然应该越靠前;

- Qanswers 表示回答的数量,代表有多少人参与这个问题。这个值越大,得分将成倍放大。这里需要注意的是,如果无人回答,Qanswers 就等于0,这时Qscore 再高也没用,意味着再好的问题,也必须有人回答,否则进不了热点问题排行榜。

3)回答得分 Ascores

一般来说,“回答”比“问题”更有意义。得分越高,代表回答的质量越高。

但是我感觉,简单加总的设计还不够全面。这里有两个问题。首先,一个正确的回答胜过一百个无用的回答,但是,简单加总会导致,1 个得分为 100 的回答与 100 个得分为 1 的回答,总得分相同。其次,由于得分会出现负值,因此那些特别差的回答,会拉低正确回答的得分。

4)距离问题发表的时间Qage和距离最后一个回答的时间 Qupdated

其中,Qage 和 Qupdated 单位是秒。如果一个问题的存在时间越久,或者距离上一次回答的时间越久,Qage 和 Qupdated 的值就相应增大。

也就是说,随着时间流逝,这两个值都会越变越大,导致分母增大,因此总得分会越来越小。

Stack Overflow 热点问题的排名,与参与度(Qviews 和 Qanswers)和质量(Qscore 和 Ascores)成正比,与时间(Qage 和 Qupdated)成反比。

牛顿冷却定律

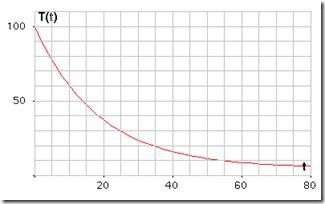

这是一个更一般的数学模型。我们可以把"热文排名"想象成一个"自然冷却"的过程:

1)任一时刻,网站中所有的文章,都有一个“当前温度”,温度最高的文章就排在第一位。

2)如果一个用户对某篇文章投了赞成票,该文章的温度就上升一度。

3)随着时间流逝,所有文章的温度都逐渐“冷却”。

这样假设的意义在于,我们可以照搬物理学的冷却定律,使用现成的公式,建立“温度”与“时间”之间的函数关系,构建一个“指数式衰减(Exponential decay)”的过程。

图 10

牛顿早在 17 世纪就提出了温度冷却的数学公式,被后人称作“牛顿冷却定律(Newton's Law of Cooling)”。我们就用这个定律构建排名算法。

用一句话概括“牛顿冷却定律”:物体的冷却速度,跟其当前温度与室温之间的温差成正比。

写成微分方程如下:

其中,

- T(t) 是温度T关于时间 t 的函数,则温度变化(冷却)的速率就是温度函数的导数 T'(t)。

- H 代表室温,T(t)-H 是当前温度与室温之间的温差。由于当前温度高于室温,所以这是一个正值。

- 常数 α(α>0) 表示室温与降温速率之间的比例关系。前面的负号表示降温。不同的物质有不同的 α 值。

为了计算当前温度,需要求出T(t) 函数表达式,进行如下计算:

第一步,变换方程,再在等式两边取积分。

第二步,求出这个积分的解(c 为常数项)。

第三步,假设在时刻 t0,该物体的温度是 T(t0),简写为 T0。代入上面的方程,得到

第四步,将第三步的 C 代入第二步的方程。

假定室温 H 为 0 度,即所有物体最终都会"冷寂",方程就可以简化为

也就是:

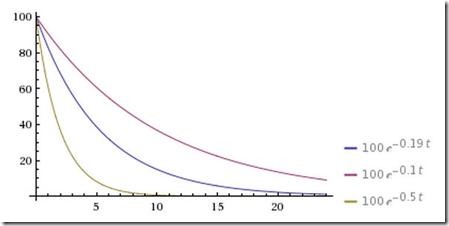

将这个公式套用在“排名算法”,就相当于(假定本期没有增加净赞成票)

其中,"冷却系数"是一个你自己决定的值。如果假定一篇新文章的初始分数是100分,24小时之后"冷却"为1分,那么可以计算得到"冷却系数"约等于0.192。如果你想放慢"热文排名"的更新率,"冷却系数"就取一个较小的值,否则就取一个较大的值。

图 11

参考文献

[1] Rank Hotness With Newton's Law of Cooling

迄今为止,这个系列都在讨论,如何给出"某个时段"的排名,比如"过去24小时最热门的文章"。但是,很多场合需要的是"所有时段"的排名,比如"最受用户好评的产品"。这时,时间因素就不需要考虑了。这个系列的最后两篇,就研究不考虑时间因素的情况下,如何给出排名。

威尔逊区间

一种常见的错误算法是:

得分 = 赞成票 - 反对票

假定有两个项目,项目 A 是 60 张赞成票,40 张反对票,项目 B 是 550 张赞成票,450 张反对票。请问,谁应该排在前面?按照上面的公式,B 会排在前面,因为它的得分(550 - 450 = 100)高于A(60 - 40 = 20)。但是实际上,B的好评率只有 55%(550 / 1000),而A为 60%(60 / 100),所以正确的结果应该是 A 排在前面。Urban Dictionary 就是这种错误算法的实例,如图 12 左边。

图 12 左:Urban Dictionary;右:Amazon

另一种常见的错误算法是:

得分 = 赞成票 / 总票数

如果"总票数"很大,那么这种算法是有效的。否则,就会出错。假定 A 有 2 张赞成票、0 张反对票;B 有 100 张赞成票、1 张反对票。这种算法会使得 A 排在 B 前面。这显然是错误的。Amazon 就是这种错误算法的实例,如图 12 右边。

那么,正确的算法是什么呢?

我们先做如下设定:

1)每个用户的投票都是独立事件。

2)用户只有两个选择,要么投赞成票,要么投反对票。

3)如果投票总人数为 n,其中赞成票为 k,那么赞成票的比例 p 就等于 k/n。

如果你了解概率,这统计分布,叫“二项分布(binomial distribution)”。这很重要,下面将用到。

我们的思路是,p 越大,就代表这个项目的好评比例越高,越应该排在前面。但 p 的可信性,取决于有多少人投票,如果样本太小,p 就不可信。好在我们已经知道,p 是二项分布中某个事件的发生概率,因此我们可以计算出p的置信区间。所谓“置信区间”,就是说,以某个概率而言,p 会落在的那个区间。比如,某个产品的好评率是 80%,但是这个值不一定可信。根据统计学,我们只能说,有 95% 的把握可以断定,好评率在 75%~85% 之间,即置信区间是 [75%, 85%]。

这样一来,排名算法就比较清晰了:

- 第一步,计算每个项目的“好评率”(即赞成票的比例)。

- 第二步,计算每个“好评率”的置信区间(以95%的概率)。

- 第三步,根据置信区间的下限值,进行排名。这个值越大,排名就越高。

这样做的原理是,置信区间的宽窄与样本的数量有关。比如,A 有 8 张赞成票,2 张反对票;B 有 80 张赞成票,20 张反对票。这两个项目的赞成票比例都是 80%,但是 B 的置信区间(假定 [75%, 85%])会比 A 的置信区间(假定 [70%, 90%])窄得多,因此,B 的置信区间的下限值(75%)会比 A(70%)大,所以 B 应该排在 A 前面。

置信区间的实质,就是进行可信度的修正,弥补样本量过小的影响。如果样本多,就说明比较可信,不需要很大的修正,所以置信区间会比较窄,下限值会比较大;如果样本少,就说明不一定可信,必须进行较大的修正,所以置信区间会比较宽,下限值会比较小。

二项分布的置信区间有多种计算公式,最常见的”正态区间(Normal approximation interval)",但它只适用于样本较多的情况(np > 5 且 n(1 − p) > 5),对于小样本,它的准确性很差。

1927年,美国数学家 Edwin Bidwell Wilson 提出了一个修正公式,被称为"威尔逊区间(Wilson score interval)",很好地解决了小样本的准确性问题。

在上面的公式中,![]() 表示样本的"赞成票比例",n 表示样本的大小,

表示样本的"赞成票比例",n 表示样本的大小,![]() 表示对应某个置信水平的 z 统计量,这是一个常数,可以通过查表或统计软件包得到。一般情况下,在 95% 的置信水平下,z统计量的值为 1.96。威尔逊置信区间的均值为:

表示对应某个置信水平的 z 统计量,这是一个常数,可以通过查表或统计软件包得到。一般情况下,在 95% 的置信水平下,z统计量的值为 1.96。威尔逊置信区间的均值为:

它的下限值为:

可以看到,当 n 的值足够大时,这个下限值会趋向 ![]() 。如果 n 非常小(投票人很少),这个下限值会大大小于

。如果 n 非常小(投票人很少),这个下限值会大大小于 ![]() 。实际上,起到了降低"赞成票比例"的作用,使得该项目的得分变小、排名下降。

。实际上,起到了降低"赞成票比例"的作用,使得该项目的得分变小、排名下降。

Reddit 的评论排名,目前就使用这个算法。

图 13

参考文献

[1] How Not To Sort By Average Rating

贝叶斯平均

“威尔逊区间”解决了投票人数过少、导致结果不可信的问题。

举例来说,如果只有 2 个人投票,“威尔逊区间”的下限值会将赞成票的比例大幅拉低。这样做固然保证了排名的可信性,但也带来了另一个问题:排行榜前列总是那些票数最多的项目,新项目或者冷门的项目,很难有出头机会,排名可能会长期靠后。

以 IMDB 为例,它是世界最大的电影数据库,观众可以对每部电影投票,最低为 1 分,最高为 10 分。系统根据投票结果,计算出每部电影的平均得分。然后,再根据平均得分,排出最受欢迎的前250名的电影。

这里就有一个问题:热门电影与冷门电影的平均得分,是否真的可比?举例来说,一部好莱坞大片有 10000 个观众投票,一部小成本的文艺片只有 100 个观众投票。这两者的投票结果,怎么比较?如果使用“威尔逊区间”,后者的得分将被大幅拉低,这样处理是否公平,能不能反映它们真正的质量?

一个合理的思路是,如果要比较两部电影的好坏,至少应该请同样多的观众观看和评分。既然文艺片的观众人数偏少,那么应该设法为它增加一些观众。

在排名页面的底部,IMDB 给出了它的计算方法。

其中,

- WR,加权得分(weighted rating)。

- R,该电影的用户投票的平均得分(Rating)。

- v,该电影的投票人数(votes)。

- m,排名前250名的电影的最低投票数(现在为3000)。

- C, 所有电影的平均得分(现在为6.9)。

仔细研究这个公式,你会发现,IMDB 为每部电影增加了 3000 张选票,并且这些选票的评分都为 6.9。这样做的原因是,假设所有电影都至少有 3000 张选票,那么就都具备了进入前250名的评选条件;然后假设这 3000 张选票的评分是所有电影的平均得分(即假设这部电影具有平均水准);最后,用现有的观众投票进行修正,长期来看,v/(v+m)这部分的权重将越来越大,得分将慢慢接近真实情况。

这样做拉近了不同电影之间投票人数的差异,使得投票人数较少的电影也有可能排名前列。

把这个公式写成更一般的形式:

其中,

- C,投票人数扩展的规模,是一个自行设定的常数,与整个网站的总体用户人数有关,可以等于每个项目的平均投票数。

- n,该项目的现有投票人数。

- x,该项目的每张选票的值。

- m,总体平均分,即整个网站所有选票的算术平均值。

这种算法被称为"贝叶斯平均"(Bayesian average)。因为某种程度上,它借鉴了"贝叶斯推断"(Bayesian inference)的思想:既然不知道投票结果,那就先估计一个值,然后不断用新的信息修正,使得它越来越接近正确的值。

在这个公式中,m(总体平均分)是"先验概率",每一次新的投票都是一个调整因子,使总体平均分不断向该项目的真实投票结果靠近。投票人数越多,该项目的"贝叶斯平均"就越接近算术平均,对排名的影响就越小。

因此,这种方法可以给一些投票人数较少的项目,以相对公平的排名。

"贝叶斯平均"也有缺点,主要问题是它假设用户的投票是正态分布。比如,电影A有10个观众评分,5个为五星,5个为一星;电影B也有 10 个观众评分,都给了三星。这两部电影的平均得分(无论是算术平均,还是贝叶斯平均)都是三星,但是电影A可能比电影B更值得看。

解决这个问题的思路是,假定每个用户的投票都是独立事件,每次投票只有n个选项可以选择,那么这就服从"多项分布"(Multinomial distribution),就可以结合贝叶斯定理,估计该分布的期望值。由于这涉及复杂的统计学知识,这里就不深入了,感兴趣的朋友可以继续阅读William Morgan的 How to rank products based on user input。

![clip_image002[7] clip_image002[7]](https://images0.cnblogs.com/blog/321721/201307/24001605-f762aafe9aa54074a7e096efd058de0e.gif)

![clip_image002[13] clip_image002[13]](https://images0.cnblogs.com/blog/321721/201307/24001606-ef38bdeda13b4f85b8c320edbfe9bbb9.gif)

![clip_image002[15] clip_image002[15]](https://images0.cnblogs.com/blog/321721/201307/24001606-f2605db5dc5f48b8a5a718f145438804.gif)