作业要求来源:https://edu.cnblogs.com/campus/gzcc/GZCC-16SE1/homework/2822

1. 下载一长篇中文小说。

2. 从文件读取待分析文本。

3. 安装并使用jieba进行中文分词。

pip install jieba

import jieba

jieba.lcut(text)

4. 更新词库,加入所分析对象的专业词汇。

jieba.add_word('天罡北斗阵') #逐个添加

jieba.load_userdict(word_dict) #词库文本文件

参考词库下载地址:https://pinyin.sogou.com/dict/

转换代码:scel_to_text

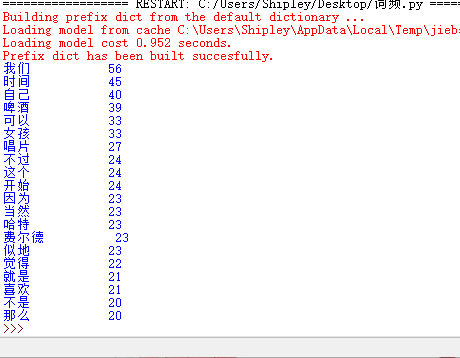

import jieba

txt = open('且听风吟.txt',"r",encoding='utf-8').read()

ex = {'一边','什么','一个','为什么','一种','怎么','没有','这样'}

ls = []

words = jieba.lcut(txt)

counts = {}

for word in words:

ls.append(word)

if len(word) == 1:

continue

else:

counts[word] = counts.get(word,0)+1

for word in ex:

del(counts[word])

items = list(counts.items())

items.sort(key = lambda x:x[1], reverse = True)

for i in range(20):

word , count = items[i]

print ("{:<10}{:>5}".format(word,count))

5. 生成词频统计

6. 排序

7. 排除语法型词汇,代词、冠词、连词等停用词。

stops

tokens=[token for token in wordsls if token not in stops]

结果:

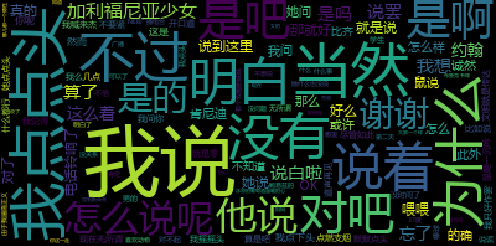

使用wordcloud库绘制一个词云

#coding:utf-8

import jieba

from wordcloud import WordCloud

import matplotlib.pyplot as plt

text =open("且听风吟.txt",'r').read()

wordlist = jieba.cut(text,cut_all=True)

wl_split = "/".join(wordlist)

mywc = WordCloud().generate(text)

plt.imshow(mywc)

plt.axis("off")

plt.show()

8. 输出词频最大TOP20,把结果存放到文件里

9. 生成词云。

结果: