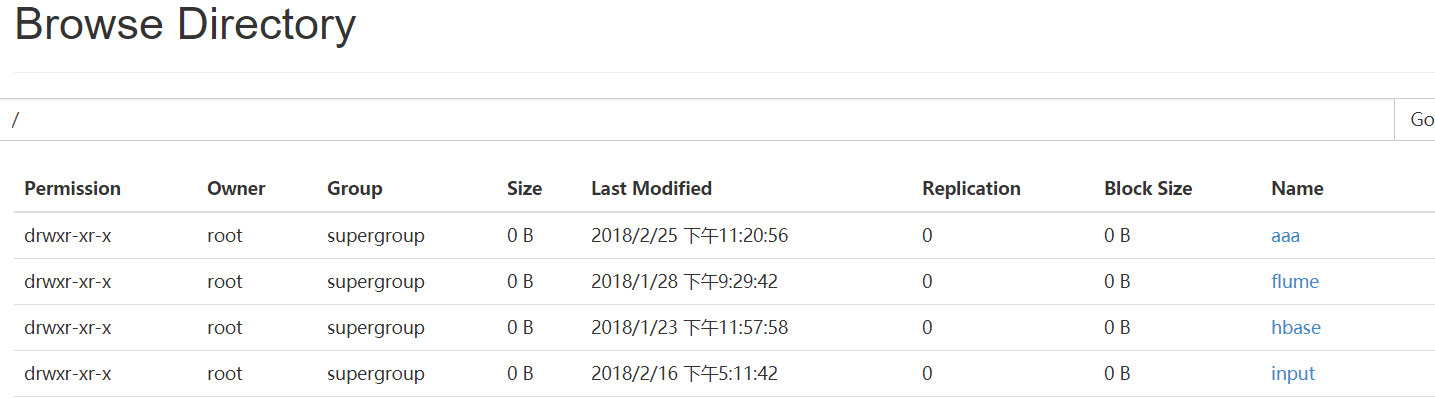

一.Web Console:端口50070

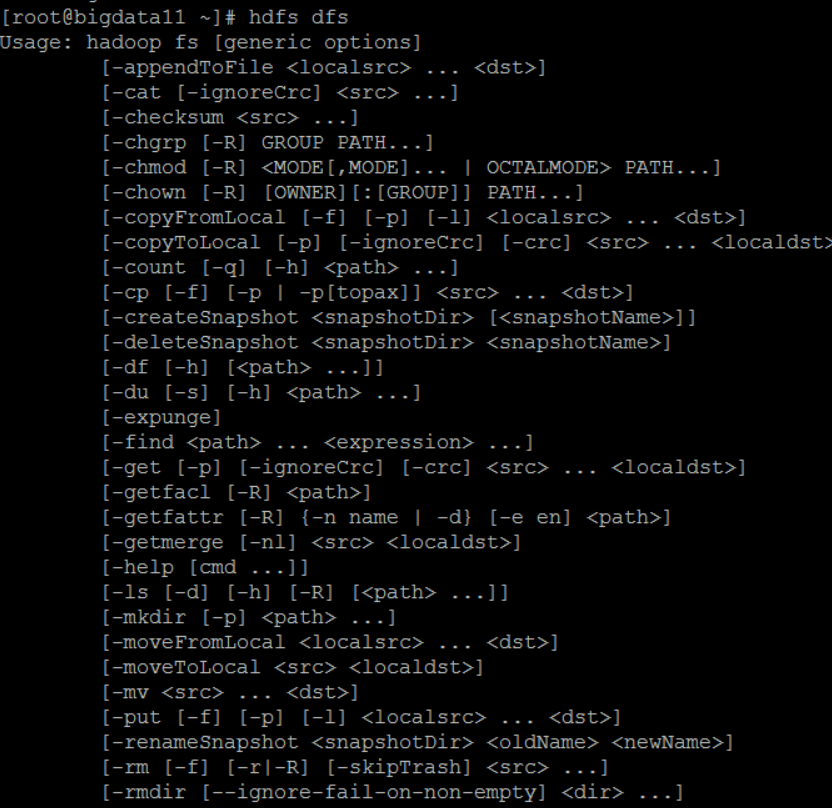

二.HDFS的命令行操作

(一)普通操作命令

HDFS 操作命令帮助信息: hdfs dfs + Enter键

常见命令

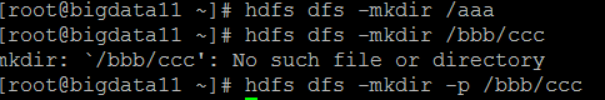

1. -mkdir

- 在HDFS上创建目录:hdfs dfs -mkdir /aaa

- 如果父目录不存在,使用 -p 命令先创建父目录:

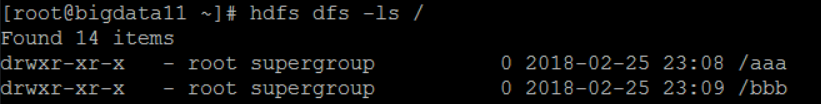

2. -ls /

查看hdfs文件系统根目录下的目录和文件:

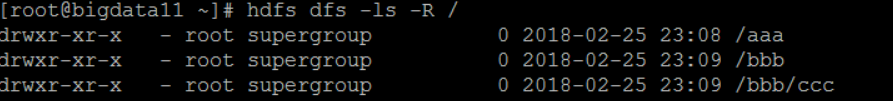

3.-ls -R /

查看所有目录和文件:

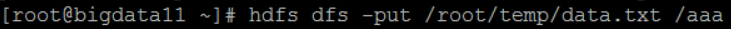

4.-put

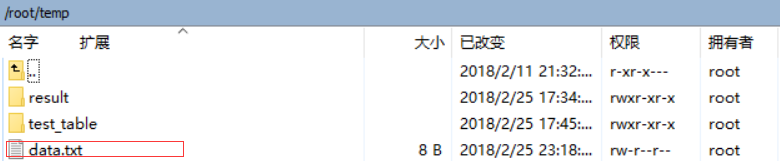

上传数据:将本地Linux文件data.txt上传到HDFS的aaa目录下

-copyFromLocal 上传数据,类似-put

-moveFromLocal 上传数据,类似-put,相当于ctrl+x

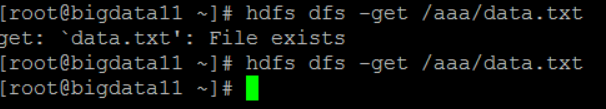

5.-get 下载数据(刚才上传数据时已经有data.txt,所以要把Linux目录下的data.txt先删除)

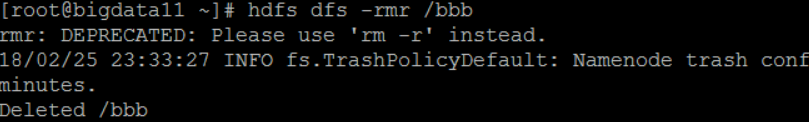

6.-rm: 删除目录

-rmr: 删除目录,包括子目录

hdfs dfs -rmr /bbb

7. -getmerge:把某个目录下的文件,合并后再下载

8.-cp:拷贝 hdfs dfs -cp /input/data.txt /input/data2.txt

9.-mv:移动 hdfs dfs -cp /input/data.txt /aaa/a.txt

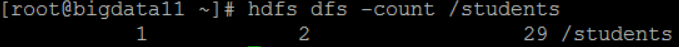

10.-count 统计hdfs对应路径下的目录个数,文件个数,文件总计大小:hdfs dfs -count /students

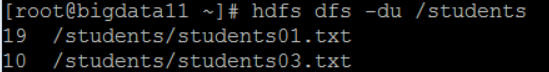

11.-du 显示hdfs对应路径下每个文件夹和目录的大小 hdfs dfs -du /students

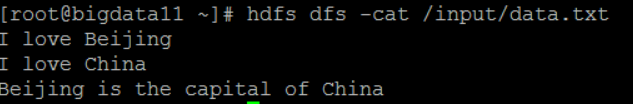

12.-cat 查看文本的内容 hdfs dfs -cat /input/data.txt

13.balancer:平衡操作 如果管理员发现某些DataNode上保存数据过多,某些过少,就可以采取此操作

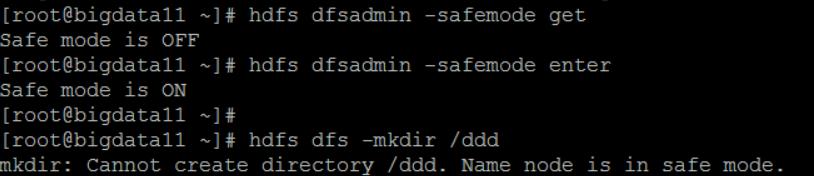

(二)管理命令:hdfs dfsadmin

举例:

1.-report 打印hdfs的报告 hdfs dfsadmin -report

2.-safemode:安全模式(安全模式下对hdfs只能进行只读操作)

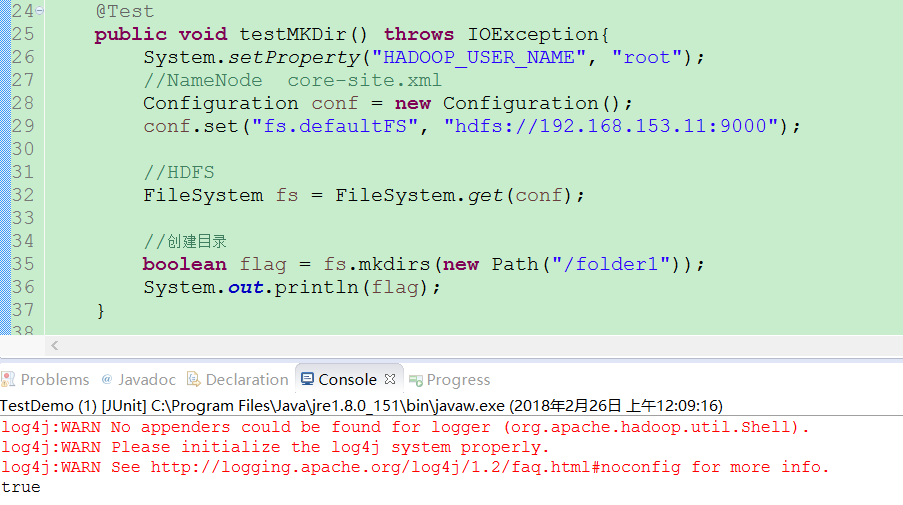

三.JavaAPI

通过HDFS提供的JavaAPI,我们可以完成以下的功能:

(一)在HDFS上创建目录

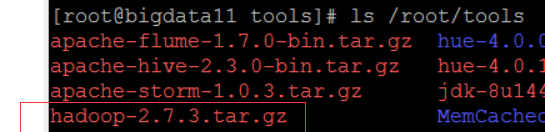

(二)写入数据(上传文件)

import java.io.FileInputStream; import java.io.IOException; import java.io.InputStream; import java.io.OutputStream; import org.apache.hadoop.conf.Configuration; import org.apache.hadoop.fs.FileSystem; import org.apache.hadoop.fs.Path; import org.junit.Test; import com.jcraft.jsch.Buffer; public class TestUpload { @Test public void testUpload() throws IOException{ System.setProperty("HADOOP_USER_NAME", "root"); //NameNode core.site.xml Configuration conf = new Configuration(); conf.set("fs.defaultFS", "hdfs://192.168.153.11:9000"); //构造一个输入流 <---HDFS FileSystem fs = FileSystem.get(conf); InputStream in = new FileInputStream("D:\temp\hadoop-2.7.3.tar.gz"); //构造一个输出流------> HDFS OutputStream out = fs.create(new Path("/tools/hadoop-2.7.3.tar.gz")); byte[] buffer = new byte[1024]; int len = 0; while ((len=in.read(buffer)) > 0) { out.write(buffer, 0, len); } out.flush(); in.close(); out.close(); } }

(三)通过 FileSystem API 读取数据(下载文件)

(四)查看目录及文件信息

(五)查找某个文件在HDFS集群的位置

(六)删除数据

(七)获取HDFS集群上所有数据节点信息