电脑修好了,但之前落下的几天博客确实没啥补的劲头,今天先写一份报告吧。

实验内容和要求

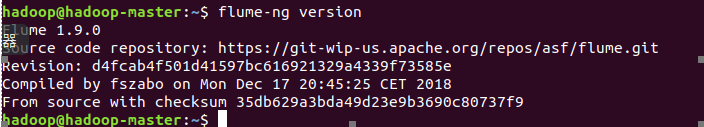

安装 Flume

安装成功。

使用 Avro 数据源测试 Flume

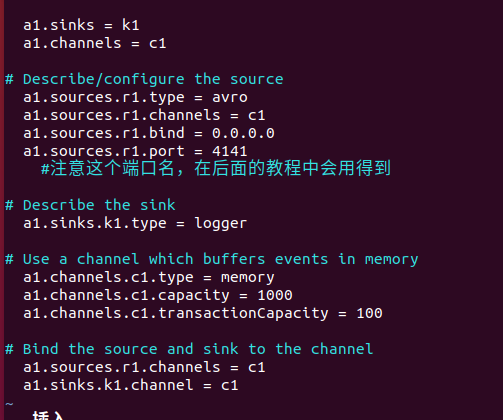

配置文件

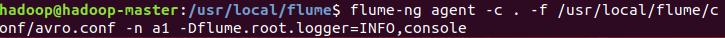

启动flume agent a1

创建指定的日志文件

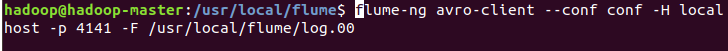

客户端传输

传输完成

使用 netcat 数据源测试 Flume

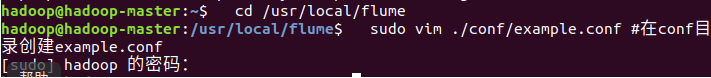

创建example.conf

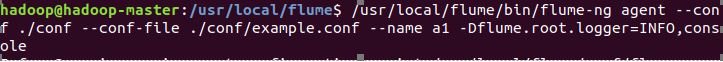

启动flume

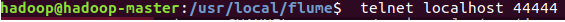

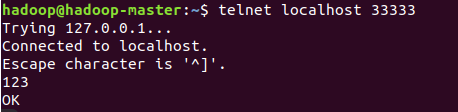

启动Telnet

Hellowworld

使用 Flume 作为 Spark Streaming 数据源

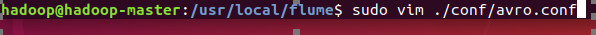

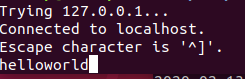

配置文件

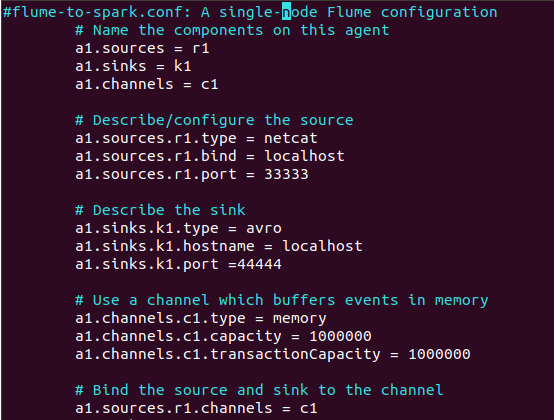

拷贝依赖包

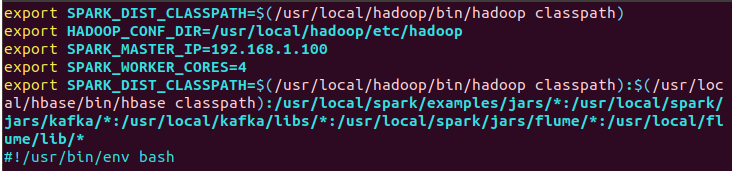

修改spark-env.sh添加环境变量

编写python程序

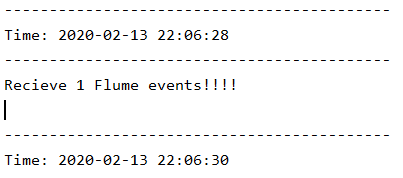

import sys from pyspark import SparkContext from pyspark.streaming import StreamingContext from pyspark.streaming.flume import FlumeUtils import pyspark if __name__ == "__main__": if len(sys.argv) != 3: print("Usage: flume_wordcount.py <hostname> <port>", file=sys.stderr) exit(-1) sc = SparkContext(appName="FlumeEventCount") ssc = StreamingContext(sc, 2) hostname = sys.argv[1] port = int(sys.argv[2]) stream = FlumeUtils.createStream(ssc, hostname, port, pyspark.StorageLevel.MEMORY_AND_DISK_SER_2) stream.count().map(lambda cnt: "Recieve " + str(cnt) + " Flume events!!!!").pprint() ssc.start() ssc.awaitTermination()

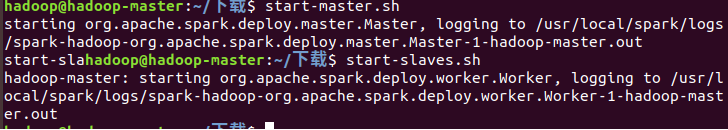

启动spark

运行python

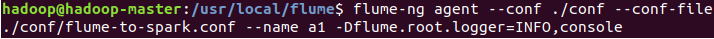

运行flume

启动Telnet

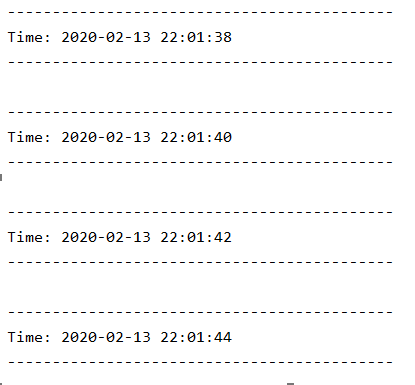

接收成功