博客部分公式有格式问题,请前往语雀: https://www.yuque.com/leesamoyed/bvsayi/hrobcr

一、最小二乘法(矩阵表达;几何意义):

1.线性拟合是用线去拟合样本点:

假设:

其中: ,

有:

事实上要拟合的曲线:

其中:

2.最小二乘估计:

最小二乘法定义:

其中:

得到:

得到:

得到:

所以:

注意:

第一个几何解释:距离和。

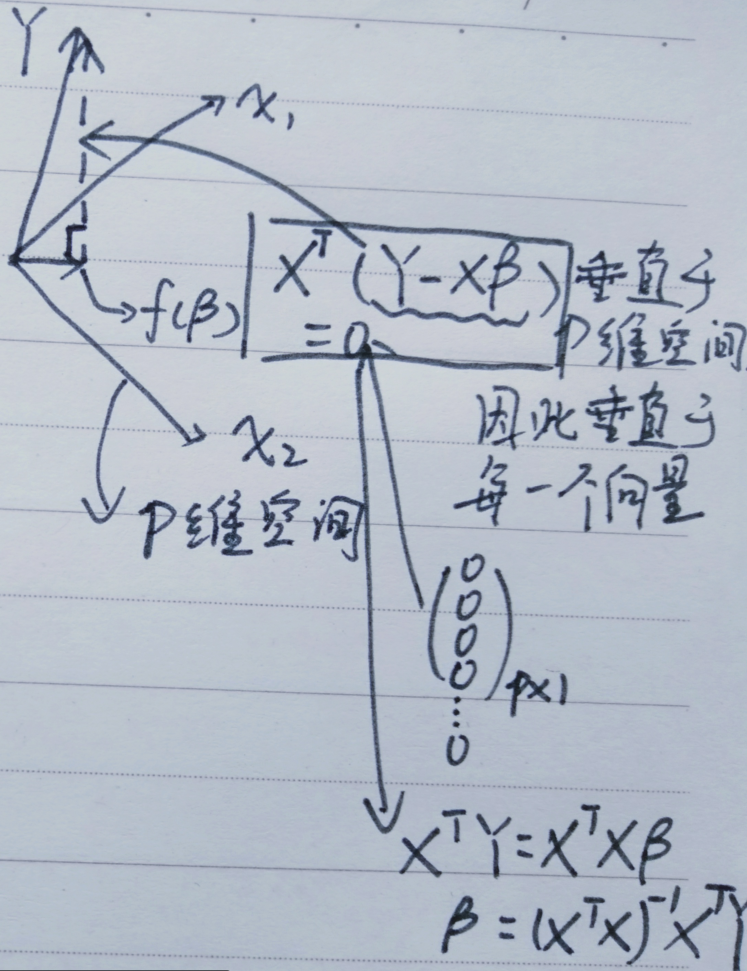

另一个几何解释:对于要拟合的直线我们从另一个角度看:

既然是投影就会垂直于

显而易见的是,结果和我们之前推导的结果是一样的,所以从这个角度就很好推证。

这个就是把误差看成每个维度。

二、最小二乘法-概率角度:

概率视角:

假设:

其中:

有:

最小二乘估计:

假设存在噪声:

和最小二乘估计的

三、正则化-岭回归-频率角度:

Loss Function:

过拟合

正则化是对对目标函数的约束

正则化框架:

L1(一范式)Lasso,

L2(二范式):Ridge(岭回归),

L2对应的函数:

四、正则化-岭回归-贝叶斯角度:

频率角度:

贝叶斯角度:

先验:

后验:

这里

这里省略了

和

Regularized

线性回归:

①线性 ②全局性 ③数据未加工