hive是一个数据仓库工具,建立在hadoop之上,它的存在是为了让大数据的查询和分析更加的方便。hive提供简单的sql查询功能,并最终转换为mapreduce任务执行。

一、环境

- JDK1.8+官方推荐新版JDK,否则可能存在不同版本不兼容问题

- hadoop采用2.0+版本,否则hive2.0+将不支持hadoop1.0+

- Linux环境和window皆可作为生产环境,但是macos的话一般作为开发环境

本文采用centos7系统,JDk1.8,和hadoop2.9

JDK安装参考:https://www.cnblogs.com/lay2017/p/7442217.html

hadoop单节点安装参考:https://www.cnblogs.com/lay2017/p/9912381.html

hdfs单节点安装配置:https://www.cnblogs.com/lay2017/p/9919905.html

以上,我们构建了JDK,hadoop以及配置了hadoop中的hdfs。hive将基于jdk和hadoop环境,将数据存储在hdfs中。

同时,为了简单,我们只进行单节点安装配置,并只配置了hdfs,没有mapreduce和yarn的配置。

以及,元数据存储我们也不使用独立的mysql或者derby,直接采用默认的内置数据库derby,使用内置数据库只会允许有一个connection,所以如果是生产环境通常是会使用独立的数据库mysql。

这样,我们就构建了hive的基本环境,接下来我们进行hive的安装配置

二、hive安装配置

我们先建立一个Hive目录,然后进入该目录

mkdirs /usr/local/hadoop/hive

cd /usr/local/hadoop/hive

本文采用1.2.2版本的hive,下载该tar包,这里要等待一段时间

wget http://mirrors.hust.edu.cn/apache/hive/hive-1.2.2/apache-hive-1.2.2-bin.tar.gz

然后解压

tar apache-hive-1.2.2-bin.tar.gz

你可以看到解压后的文件

接下来我们需要给hive配置环境变量

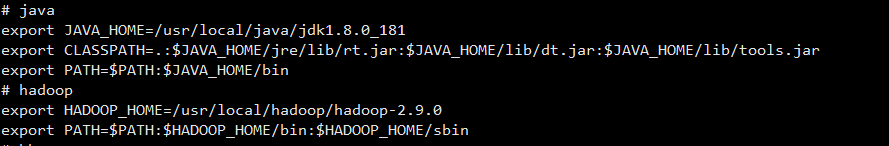

当然,请确保你之前安装的hadoop和jdk是可用的配置

使用命令,使得配置生效

source /etc/profile

我们进入hive目录

cd /usr/local/hadoop/hive/apache-hive-1.2.2-bin

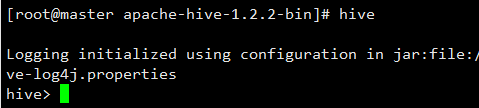

进入hive shell看看(请记得要先启动hdfs:start-dfs.sh)

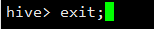

这样就说明我们已经配置成功hive了,退出hive

我们看到该目录下创建了metastore

这就意味着在apache-hive-1.2.2-bin目录下存放着你的元数据,而下次你也得在这个目录去启动hive,如果在其他位置启动Hive,你会找不到这些表而觉得奇怪。

以上,我们就简单安装配置了hive,并成功启动hive shell同时自动创建了元数据数据库(metastore_db);