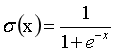

Sigmoid函数

大于5(或小于-5)的部分其梯度接近0,会导致在误差反向传播过程中导数处于该区域的误差很难甚至无法传递到前层,进而导致整个网络无法进行训练。

sigmoid型激活函数值域的均值并非为 0而是全为正,这样的结果实际上并不符合我们对神经网络内数值的期望(均值)应为 0的设想。

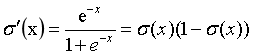

Tanh

关于原点对称,但仍存在梯度饱和问题

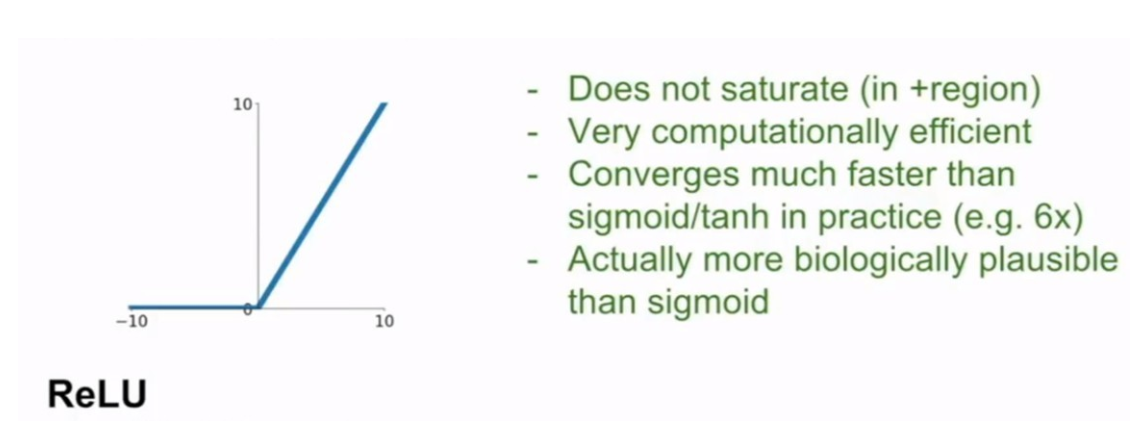

ReLU修正线性单元

ReLU(x)=max{0,x}

计算简单,消除了梯度饱和效应,有助于随机梯度下降法收敛,由于小于零时梯度全为0,所以存在“死区”现象。

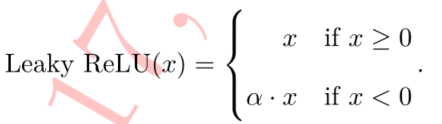

Leaky ReLU

其中a为0.01或0.001数量级的较小正数,解决了ReLU死区现象,但该函数在实际使用中的性能并不十分稳定。

参数化ReLU

参数化ReLU直接将a也作为网络中可学习的变量融入模型的训练过程。

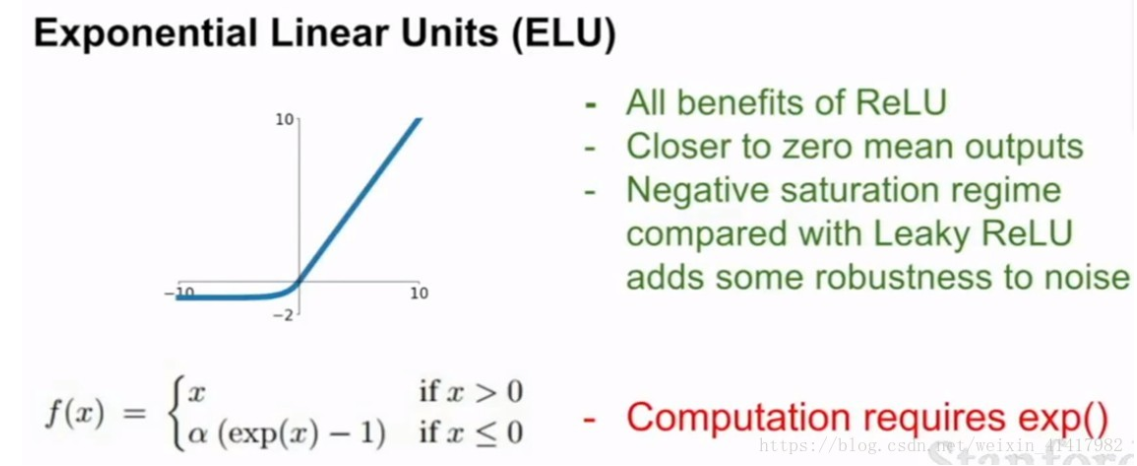

指数化线性单元ELU