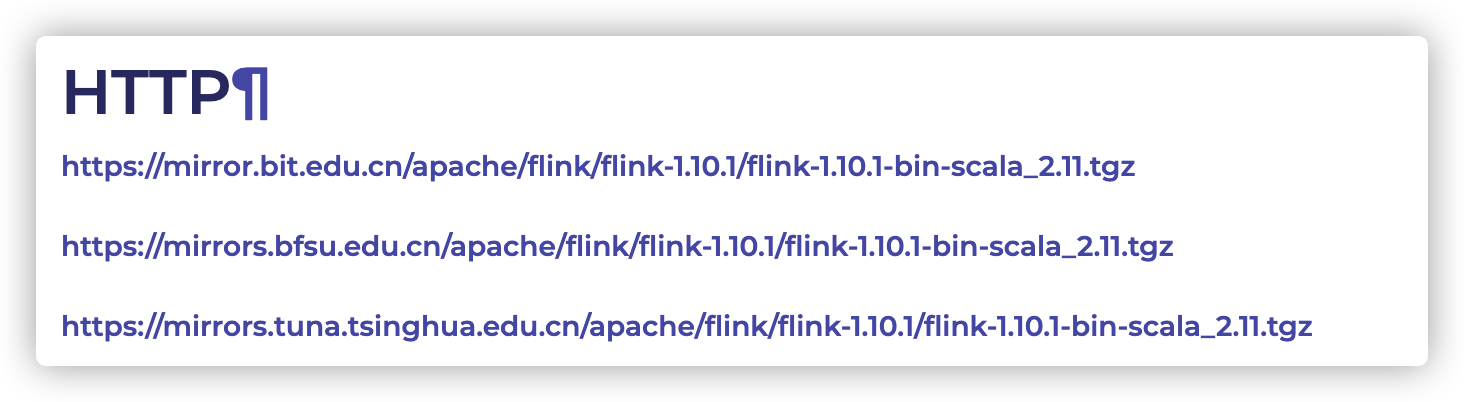

1.官网下载jar包:

https://www.apache.org/dyn/closer.lua/flink/flink-1.10.1/flink-1.10.1-bin-scala_2.11.tgz

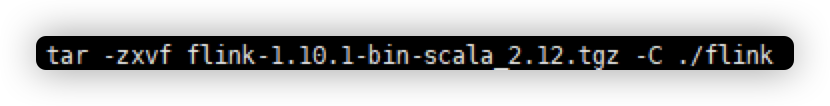

2.上传jar包并且解压:

3.进入/flink-1.10.1/conf/flink-conf.yaml

配置修改以下参数:

1)jobmanager.rpc.address: 此处添加master节点的localhost

其余参数根据自己机器自行配置,我粘贴一下默认值和说明

2)jobmanager.heap.size:1024m --每一个jobmanage可用的内存

3) taskmanager.memory.process.size: 1728m --每一个taskmanager可用的内存

4)taskmanager.numberOfTaskSlots:4 --每个机器所能用的CPUs

5)io.tmp.dirs:/tmp --用于存放运算过程中的临时目录

4.进入/flink-1.10.1/conf/slaves

1)添加自己集群的slaves 例如:

192.168.1.102

192.168.1.103

192.168.1.104

5.写一个分发脚本将flink分发到各个节点。

======================================================================================

脚本:

#!/bin/bash

if[ $# -lt 1 ]

then

echo Not Enough Arguement!

exit;

fi

#2.遍历集群所有机器

for host in 此粗写你的节点例如(hadoop102 Hadoop103 Hadoop104)

do

echo ========================= $host ================================

#3.遍历所有目录,挨个发送

for file in $@

do

#4 判断文件是否存在

if [ -e $file ]

then

#5.获取父目录

pdir=$(cd -P ${dirname $file}; pwd)

fname=${basename $file}

ssh $host "mkdir -p $pdir"

rsync -av $spdir/$fname $host:$pdir

else

echo $file does not exists!

fi

done

done

======================================================================================

6.在master上面输入启动命令开启集群:

bin/start-cluster.sh

7.访问ui界面:localhost:8081

8.关闭集群:

stop-cluster.sh