1.规划好哪些服务运行在那个服务器上

需要配置的配置文件

2. 修改配置文件,设置服务运行机器节点

首先在 hadoop-senior 的这台主机上 进行 解压 hadoop2.5 按照伪分布式的配置文件来进行配置

使用命令 :tar -zxvf hadoop-2.5.0.tar.gz -C /opt/app/ (解压 hadoop 2.5)

然后进入 cd /opt/app/hadoop-2.5.0/etc

将里面一开始的配置文件重命令 mv hadoop backup-hadoop

然后将一开始伪分布式中的配置文件复制过来 使用命令 cp -r /opt/moudles/hadoop-2.5.0/etc/hadoop ./

(如果在Windows下 想使用方便,可以在C:WindowsSystem32driversetc目录下 修改hosts文件 配置 虚拟机的主机IP)

开始配置

使用notepad 进行配置hadoop 的配置文件

hadoop.env export JAVA_HOME=/opt/modules/jdk1.7.0_67 (默认已经配置好了,不用更改)

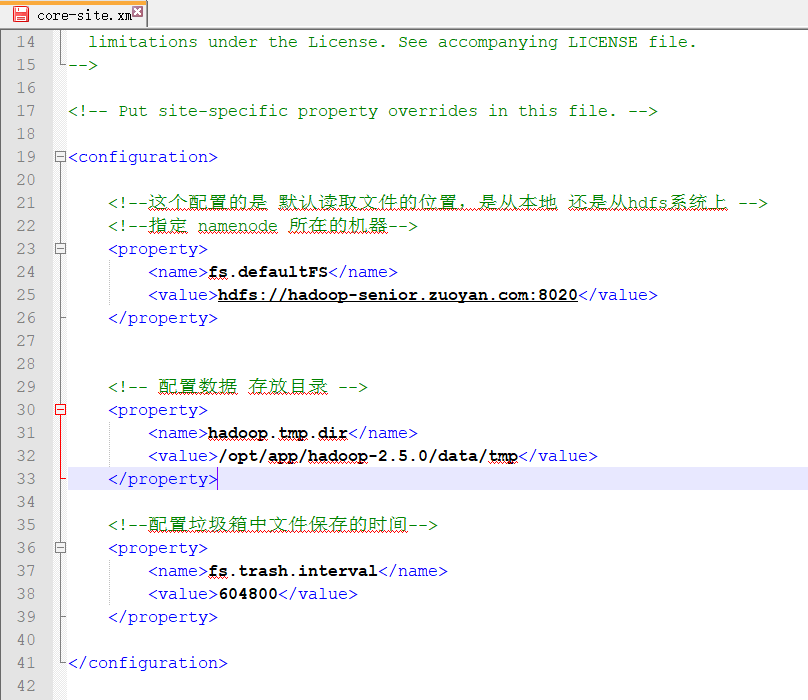

core-site.xml 文件中的内容配置

<configuration>

<!--这个配置的是 默认读取文件的位置,是从本地 还是从hdfs系统上 -->

<!--指定 namenode 所在的机器-->

<property>

<name>fs.defaultFS</name>

<value>hdfs://hadoop-senior.zuoyan.com:8020</value>

</property>

<!-- 配置数据 存放目录 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/app/hadoop-2.5.0/data/tmp</value>

</property>

<!--配置垃圾箱中文件保存的时间-->

<property>

<name>fs.trash.interval</name>

<value>604800</value>

</property>

</configuration>

因为没有数据存放的目录 所以需要配置一下 hadoop.tmp.dir 的目录

命令 : mkdir -p /opt/app/hadoop-2.5.0/data/tmp

配置hdfs

首先配置hdfs-site.xml 文件

因为是分布式 所以不需要配置副本数 去掉 dfs.replication

配置SecondaryNameNode 所在的节点 dfs.namenode.secondary.http-address hadoop-senior03.zuoyan.com

<configuration>

<!--配置secondary namenode 所在的主机-->

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>hadoop-senior03.zuoyan.com:50090</value>

</property>

</configuration>

配置slaves 也就是配制 DataNode NodeManager

配置的内容为

hadoop-senior.zuoyan.com hadoop-senior02.zuoyan.com hadoop-senior03.zuoyan.com

配置yarn

首先配置 yarn.env 配置yarn的环境变量 (我这里已经配置好了,就不用更改了)

配置yarn-site.xml 这个文件

这个配置文件只需要 将 resourcesmanager 所在的主机节点更改成第二台主机就可以了

剩下的配置文件不用修改,配置文件内容如下

<configuration>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<!--配置resourcemanager 所在的主机名 -->

<property>

<name>yarn.resourcemanager.hostname</name>

<value>hadoop-senior02.zuoyan.com</value>

</property>

<!--启用历史服务器的日志聚集功能-->

<property>

<name>yarn.log-aggregation-enable</name>

<value>true</value>

</property>

<!--设置日志在文件系统上的存放时间-->

<property>

<name>yarn.log-aggregation.retain-seconds</name>

<value>640800</value>

</property>

<!--配置NodeManager Resource-->

<property>

<name>yarn.nodemanager.resource.memory-mb</name>

<value>4096</value>

</property>

<property>

<name>yarn.nodemanager.resource.cpu-vcores</name>

<value>4</value>

</property>

</configuration>

配置 mapred-site.xml

配置 JobHistoryServer 的配置文件 资源设计的时候 就把他放在了第一台主机上,所以 保持默认配置文件即可,修改一下主机名就行

配置文件的内容如下

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<!--配置历史记录服务器所在地址-->

<property>

<name>mapreduce.jobhistory.address</name>

<value>hadoop-senior.zuoyan.com:10020</value>

</property>

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>hadoop-senior.zuoyan.com:19888</value>

</property>

</configuration>

到此,配置文件就配置完成了!下一步就是分发到各个机器上去

(还有一个小点就是 删除 在 /opt/app/hadoop-2.5.0/share 下的 doc文件夹,这个文件是文档,我们一般,不用,而且还占用磁盘空间 大概占用的磁盘空间是1.5G )

好了,这篇随笔就到这里了,下一篇继续!