REDIS高可用两种方式

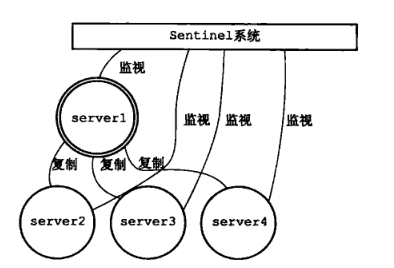

Sentinel(哨兵模式)

使用一个或者多个哨兵(Sentinel)实例组成的系统,对redis节点进行监控,在主节点出现故障的情况下,能将从节点中的一个升级为主节点,进行故障转义,保证系统的可用性。

架构图

主从节点感知

首先主节点的信息是配置在哨兵(Sentinel)的配置文件中

哨兵节点会和配置的主节点建立起两条连接命令连接和订阅连接

哨兵会通过命令连接每10s发送一次INFO命令,通过INFO命令,主节点会返回自己的run_id和自己的从节点信息

哨兵会对这些从节点也建立两条连接命令连接和订阅连接

哨兵通过命令连接向从节点发送INFO命令,获取到他的一些信息

a. run_id

b. role

c. 从服务器的复制偏移量 offset等

因为哨兵对与集群中的其他节点(主从节点)当前都有两条连接,命令连接和订阅连接

a. 通过命令连接向服务器的_sentinel:hello频道发送一条消息,内容包括自己的ip端口、run_id、配置纪元(后续投票的时候会用到)等

b. 通过订阅连接对服务器的_sentinel:hello频道做了监听,所以所有的向该频道发送的哨兵的消息都能被接受到

c. 解析监听到的消息,进行分析提取,就可以知道还有那些别的哨兵服务节点也在监听这些主从节点了,更新结构体将这些哨兵节点记录下来

d. 向观察到的其他的哨兵节点建立命令连接----没有订阅连接

故障迁移

- 主观下线

哨兵(Sentinel)节点会每秒一次的频率向建立了命令连接的实例发送PING命令,如果在down-after-milliseconds毫秒内没有做出有效响应包括 (PONG/LOADING/MASTERDOWN)以外的响应,哨兵就会将该实例在本结构体中的状态标记为SRI_S_DOWN主观下线 - 客观下线

当一个哨兵节点发现主节点处于主观下线状态是,会向其他的哨兵节点发出询问,该节点是不是已经主观下线了。如果超过配置参数quorum个节点认为是主观下线时,该哨 兵节点就会将自己维护的结构体中该主节点标记为SRI_O_DOWN客观下线 - leader选举

在认为主节点客观下线的情况下,哨兵节点节点间会发起一次选举,命令还是上面的命令SENTINEL is-master-down-by-addr<current_epoch> <run_id>,只 是run_id这次会将自己的run_id带进去,希望接受者将自己设置为主节点。如果超过半数以上的节点返回将该节点标记为leader的情况下,会有该leader对故障进行迁移 - 故障迁移

在从节点中挑选出新的主节点

a. 通讯正常

b. 优先级排序

c. 优先级相同是选择offset最大的

将该节点设置成新的主节点 SLAVEOF no one,并确保在后续的INGO命令时,该节点返回状态为master

将其他的从节点设置成从新的主节点复制, SLAVEOF命令

将旧的主节点变成新的主节点的从节点

优点

高可用,在主节点故障时能实现故障的转移

缺点

在哨兵模式中,仍然只有一个Master节点。当并发写请求较大时,哨兵模式并不能缓解写压力

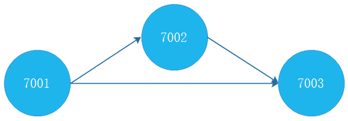

Redis-cluster(集群模式)

(1)由多个Redis服务器组成的分布式网络服务集群;

(2)集群之中有多个Master主节点,每一个主节点都可读可写;

(3)节点之间会互相通信,两两相连;

(4)Redis集群无中心节点。

架构图

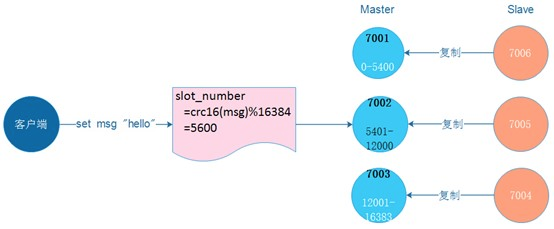

集群分片策略

Redis-cluster分片策略,是用来解决key存储位置的。

集群将整个数据库分为16384个槽位slot,所有key-value数据都存储在这些slot中的某一个上。一个slot槽位可以存放多个数据,key的槽位计算公式为:slot_number=crc16(key)%16384,其中crc16为16位的循环冗余校验和函数。

集群中的每个主节点都可以处理0个至16383个槽,当16384个槽都有某个节点在负责处理时,集群进入上线状态,并开始处理客户端发送的数据命令请求。

集群redirect转向

由于Redis集群无中心节点,请求会随机发给任意主节点;

主节点只会处理自己负责槽位的命令请求,其它槽位的命令请求,该主节点会返回客户端一个转向错误;

客户端根据错误中包含的地址和端口重新向正确的负责的主节点发起命令请求。

故障转移

Redis集群的主节点内置了类似Redis Sentinel的节点故障检测和自动故障转移功能,当集群中的某个主节点下线时,集群中的其他在线主节点会注意到这一点,并对已下线的主节点进行故障转移。

优点

- 高可用,在主节点故障时能实现故障的转移

- 支持多个主节点写

- 在Redis-Cluster集群中,可以给每一个主节点添加从节点,主节点和从节点直接遵循主从模型的特性。

当用户需要处理更多读请求的时候,添加从节点可以扩展系统的读性能。

缺点

- 服务器部署较复杂,查询性能低下

REDIS-CLUSTER安装

服务器规划

| IP | 主从节点 | 端口号 |

|---|---|---|

| 10.159.42.37 | 主 | 7001 |

| 10.159.42.37 | 主 | 7002 |

| 10.159.42.37 | 主 | 7004 |

| 10.159.44.248 | 从 | 7001 |

| 10.159.44.248 | 从 | 7002 |

| 10.159.44.248 | 从 | 7003 |

下载安装包

下载Redis5.0.5

进入Redis中文网的下载页面 http://www.redis.cn/download.html

上传压缩包到linux系统

tcl

#不安装的的话,redis 在make test是会失败

wget http://downloads.sourceforge.net/tcl/tcl8.6.1-src.tar.gz

tar -xzvf tcl8.6.1-src.tar.gz

cd /usr/local/tcl8.6.1/unix/

./configure

make && make install

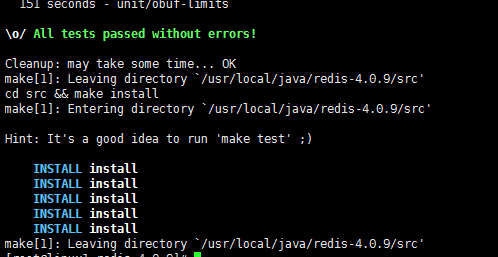

redis

cd /user/local/java

rz + 选择本地Redis路径上传

tar -zxvf redis-4.0.9.tar.gz

cd redis-4.0.9/

make && make test && make install

redis配置启动

这里同上一篇文章中的第四部是一样的,不过是多增加了几个配置和目录而已,一下步骤按一台机器为例,其他机器只需要更改7001端口号即可,别的不需要更改

(1)redis utils目录下,有个redis_init_script脚本

(2)将redis_init_script脚本拷贝到linux的/etc/init.d目录中,将redis_init_script重命名为redis_7001,7001是我们希望这个redis实例监听的端口号

(3)修改redis_7001脚本的第6行的REDISPORT,设置为相同的端口号(默认就是7001)

(4)创建两个目录:

/etc/redis(存放redis的配置文件)

/var/redis/7001(存放redis的持久化文件)

(5)修改redis配置文件(默认在根目录下,redis.conf),拷贝到/etc/redis目录中,修改名称为7001.conf

(6)修改redis.conf中的部分配置

port 7001

cluster-enabled yes

cluster-config-file /etc/redis-cluster/node-7001.conf

cluster-node-timeout 15000

daemonize yes

pidfile /var/run/redis_7001.pid

dir /var/redis/7001

logfile /var/log/redis/7001.log

bind 192.168.32.128(这里需要改成自己虚拟机的ip即可)

appendonly yes

(7)创建上面配置中的目录

mkdir -p /etc/redis-cluster

mkdir -p /var/log/redis

(8)启动redis执行

cd /etc/init.d

chmod 777 redis_7001

./redis_7001 start

(9)确认redis进程是否启动,ps -ef | grep redis

重复上面的步骤,分别做出6份配置文件:

7001.conf,7002.conf,7003.conf,7004.conf,7005.conf,7006.conf

redis_7001,redis_7002,redis_7003,redis_7004,redis_7005,redis_7006

分别重启后先检查下redis状态是不是6个服务都全部启动。

安装ruby

由于redis创建集群需要用到ruby指令,所以需要在任意一台服务器上安装ruby2.0版本以上,我这里安装的2.4.1这里安装集群需要Ruby命令,因此我们需要安装下Ruby,在集群机器中随便找一台执行即可。

安装ruby

yum install ruby //安装ruby

yum install rubygems //安装rubygems,最新版本会自动安装

安装Redis的Ruby接口程序

- 安装RVM

rootgpg2 --keyserver hkp://pool.sks-keyservers.net --recv-keys 409B6B1796C275462A1703113804BB82D39DC0E3 7D2BAF1CF37B13E2069D6956105BD0E739499BDB

curl -L get.rvm.io | bash -s stable

find / -name rvm.sh

source /etc/profile.d/rvm.sh

rvm requirements

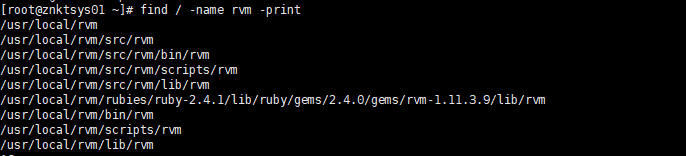

find / -name rvm -print

#使刚安装的rvm立即生效

source /usr/local/rvm/scripts/rvm

#查看rvm库中ruby版本

rvm list known

#安装一个ruby版本

rvm install 2.4.1

#使用一个ruby版本

rvm use 2.4.1

#设置默认版本

rvm use 2.4.1 --default

#卸载一个已知版本

rvm remove 版本号

#查看ruby版本

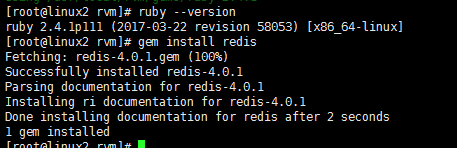

ruby --version

到此为止ruby的新版本就安装完毕了,下面让我继续执行安装redis 执行命令

gem install redis

创建集群

cp /usr/local/redis-cluster/redis-5.0.5/src/redis-trib.rb /usr/local/bin/

[root@localhost redis-5.0.5]# redis-cli --cluster create 192.168.199.129:7001 192.168.199.129:7002 192.168.199.129:7003 192.168.199.129:7004 192.168.199.129:7005 192.168.199.129:7006 --cluster-replicas 1

>>> Performing hash slots allocation on 6 nodes... Master[0] -> Slots 0 - 5460 Master[1] -> Slots 5461 - 10922 Master[2] -> Slots 10923 - 16383 Adding replica 192.168.199.129:7005 to 192.168.199.129:7001 Adding replica 192.168.199.129:7006 to 192.168.199.129:7002 Adding replica 192.168.199.129:7004 to 192.168.199.129:7003 >>> Trying to optimize slaves allocation for anti-affinity [WARNING] Some slaves are in the same host as their master M: 8fb61e78eded04e2bcbdb3c10111554a9f83f61c 192.168.199.129:7001 slots:[0-5460] (5461 slots) master M: d50604c2258508e58a202ba4a3e799ec4da46fda 192.168.199.129:7002 slots:[5461-10922] (5462 slots) master M: f51478b896fea44f3106ba9afb74dfc2e70210e2 192.168.199.129:7003 slots:[10923-16383] (5461 slots) master S: 345541a4596823a1780f6b93239dee3718639618 192.168.199.129:7004 replicates d50604c2258508e58a202ba4a3e799ec4da46fda S: 5274285b3f0c3bb29ceb32129c90b028a961e54a 192.168.199.129:7005 replicates f51478b896fea44f3106ba9afb74dfc2e70210e2 S: c46325e656f022f4e28bd957d75863f81892ef13 192.168.199.129:7006 replicates 8fb61e78eded04e2bcbdb3c10111554a9f83f61c Can I set the above configuration? (type 'yes' to accept): yes

>>> Nodes configuration updated >>> Assign a different config epoch to each node >>> Sending CLUSTER MEET messages to join the cluster Waiting for the cluster to join ..... >>> Performing Cluster Check (using node 192.168.199.129:7001) M: 8fb61e78eded04e2bcbdb3c10111554a9f83f61c 192.168.199.129:7001 slots:[0-5460] (5461 slots) master 1 additional replica(s) S: 5274285b3f0c3bb29ceb32129c90b028a961e54a 192.168.199.129:7005 slots: (0 slots) slave replicates f51478b896fea44f3106ba9afb74dfc2e70210e2 S: c46325e656f022f4e28bd957d75863f81892ef13 192.168.199.129:7006 slots: (0 slots) slave replicates 8fb61e78eded04e2bcbdb3c10111554a9f83f61c M: f51478b896fea44f3106ba9afb74dfc2e70210e2 192.168.199.129:7003 slots:[10923-16383] (5461 slots) master 1 additional replica(s) M: d50604c2258508e58a202ba4a3e799ec4da46fda 192.168.199.129:7002 slots:[5461-10922] (5462 slots) master 1 additional replica(s) S: 345541a4596823a1780f6b93239dee3718639618 192.168.199.129:7004 slots: (0 slots) slave replicates d50604c2258508e58a202ba4a3e799ec4da46fda [OK] All nodes agree about slots configuration. >>> Check for open slots... >>> Check slots coverage... [OK] All 16384 slots covered.

检查集群信息

redis-cli --cluster check 192.168.199.129:7001 --cluster-search-multiple-owners -a redispassword

192.168.199.129:7001 (8fb61e78...) -> 0 keys | 5461 slots | 1 slaves. 192.168.199.129:7003 (f51478b8...) -> 0 keys | 5461 slots | 1 slaves. 192.168.199.129:7002 (d50604c2...) -> 0 keys | 5462 slots | 1 slaves. [OK] 0 keys in 3 masters. 0.00 keys per slot on average. >>> Performing Cluster Check (using node 192.168.199.129:7001) M: 8fb61e78eded04e2bcbdb3c10111554a9f83f61c 192.168.199.129:7001 slots:[0-5460] (5461 slots) master 1 additional replica(s) S: 5274285b3f0c3bb29ceb32129c90b028a961e54a 192.168.199.129:7005 slots: (0 slots) slave replicates f51478b896fea44f3106ba9afb74dfc2e70210e2 S: c46325e656f022f4e28bd957d75863f81892ef13 192.168.199.129:7006 slots: (0 slots) slave replicates 8fb61e78eded04e2bcbdb3c10111554a9f83f61c M: f51478b896fea44f3106ba9afb74dfc2e70210e2 192.168.199.129:7003 slots:[10923-16383] (5461 slots) master 1 additional replica(s) M: d50604c2258508e58a202ba4a3e799ec4da46fda 192.168.199.129:7002 slots:[5461-10922] (5462 slots) master 1 additional replica(s) S: 345541a4596823a1780f6b93239dee3718639618 192.168.199.129:7004 slots: (0 slots) slave replicates d50604c2258508e58a202ba4a3e799ec4da46fda [OK] All nodes agree about slots configuration. >>> Check for open slots... >>> Check slots coverage... [OK] All 16384 slots covered.

修复集群

redis-cli --cluster fix 192.168.163.132:7001 --cluster-search-multiple-owners -a redispassword

192.168.163.132:6380 (815da844...) -> 0 keys | 5462 slots | 1 slaves.

192.168.163.132:6381 (56005b94...) -> 0 keys | 5461 slots | 1 slaves.

192.168.163.132:6379 (117457ea...) -> 2 keys | 5461 slots | 1 slaves.

[OK] 2 keys in 3 masters.

0.00 keys per slot on average.

>>> Performing Cluster Check (using node 192.168.163.132:6384)

S: f6a6957421b80409106cb36be3c7ba41f3b603ff 192.168.163.132:6384

slots: (0 slots) slave

replicates 117457eab5071954faab5e81c3170600d5192270

S: 0c21b6cee354594a23f4d5abf0d01b48bdc96d55 192.168.163.132:6383

slots: (0 slots) slave

replicates 56005b9413cbf225783906307a2631109e753f8f

M: 815da8448f5d5a304df0353ca10d8f9b77016b28 192.168.163.132:6380

slots:[5461-10922] (5462 slots) master

1 additional replica(s)

M: 56005b9413cbf225783906307a2631109e753f8f 192.168.163.132:6381

slots:[10923-16383] (5461 slots) master

1 additional replica(s)

S: 3a1d04983ab6c4ae853f9602dd922d4ebadc4dbf 192.168.163.132:6382

slots: (0 slots) slave

replicates 815da8448f5d5a304df0353ca10d8f9b77016b28

M: 117457eab5071954faab5e81c3170600d5192270 192.168.163.132:6379

slots:[0-5460] (5461 slots) master

1 additional replica(s)

[OK] All nodes agree about slots configuration.

>>> Check for open slots...

>>> Check slots coverage...

[OK] All 16384 slots covered.

>>> Check for multiple slot owners...