1.windows下载并安装Anaconda集成环境

URL:https://www.continuum.io/downloads

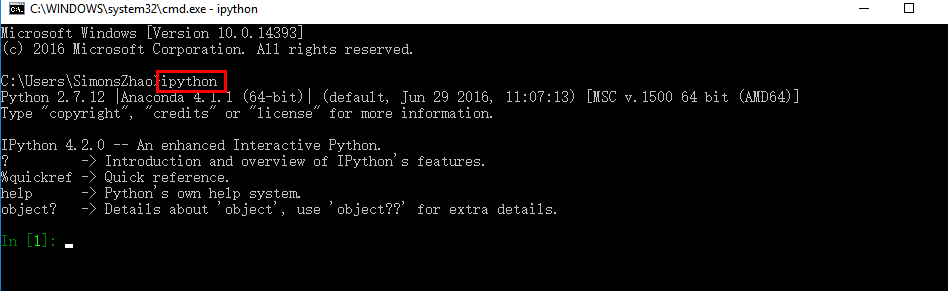

2.在控制台中测试ipython是否启动正常

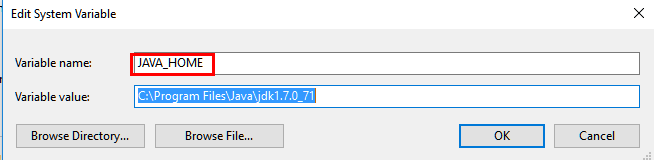

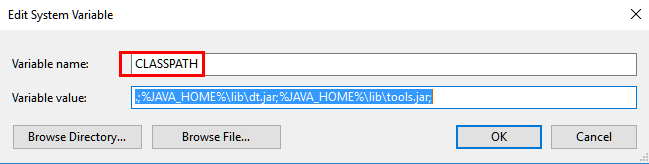

3.安装JDK

3.1环境变量配置:

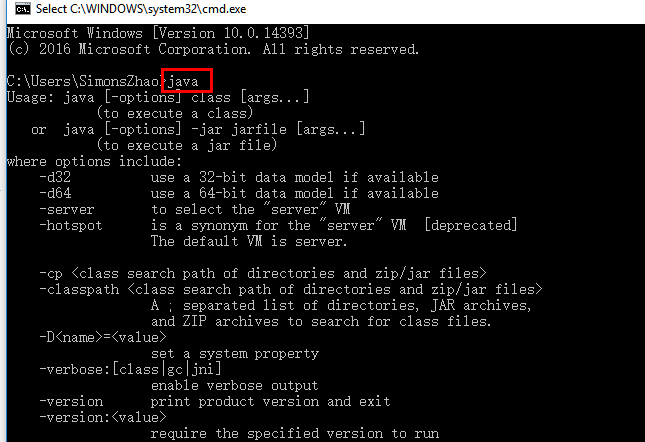

3.2测试:

4.安装Spark并配置环境变量

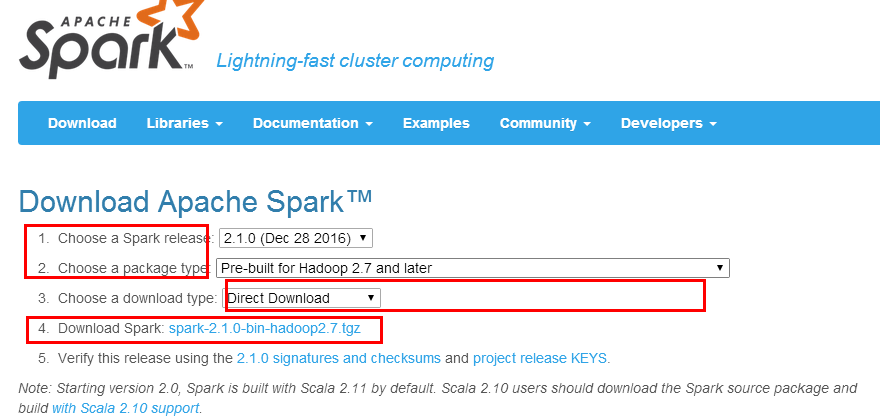

4.1 URL: http://spark.apache.org/downloads.html

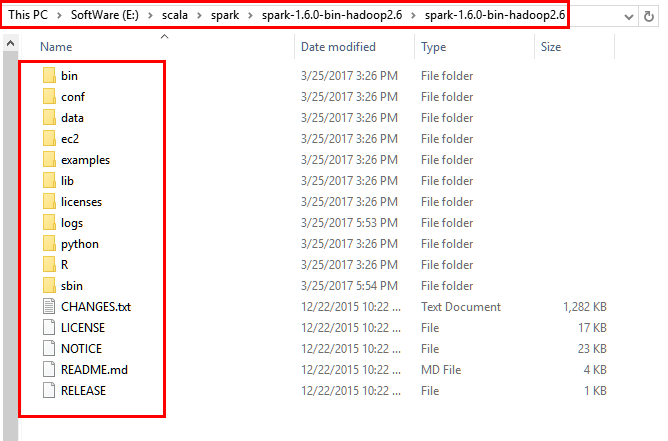

4.2解压到本地磁盘的对应目录

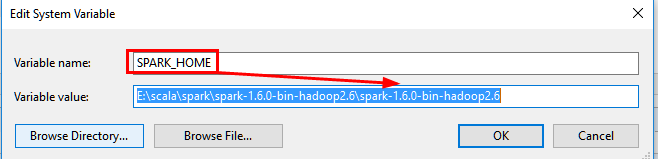

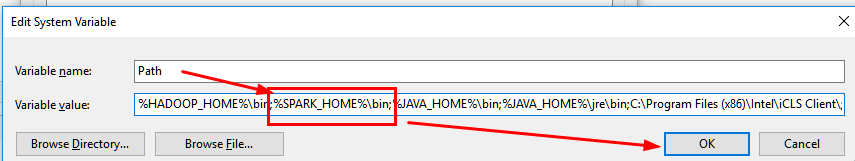

4.3配置环境变量

5.Pyspark配置

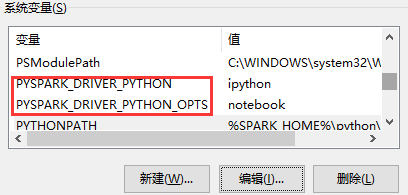

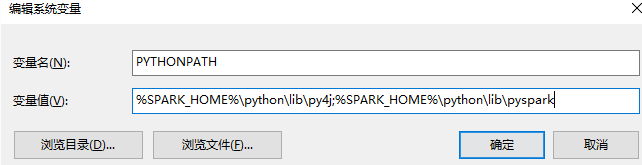

5.1配置如下系统变量

5.2修改sparkconf下的spark-env文件

在文件末尾加入如下三行

export PYSPARK_PYTHON=/E:/ProgramCJ/Anaconda2

export PYSPARK_DRIVER_PYTHON=/E:/ProgramCJ/Anaconda2

export PYSPARK_SUBMIT_ARGS='--master local[*]'

6.测试Pyspark是否安装成功

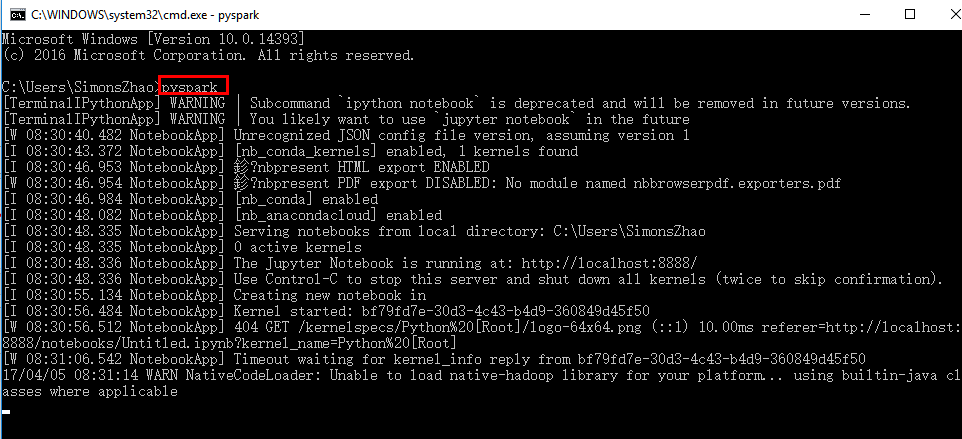

6.1命令行中输入pyspark测试

6.2 显示如下,并新建python root

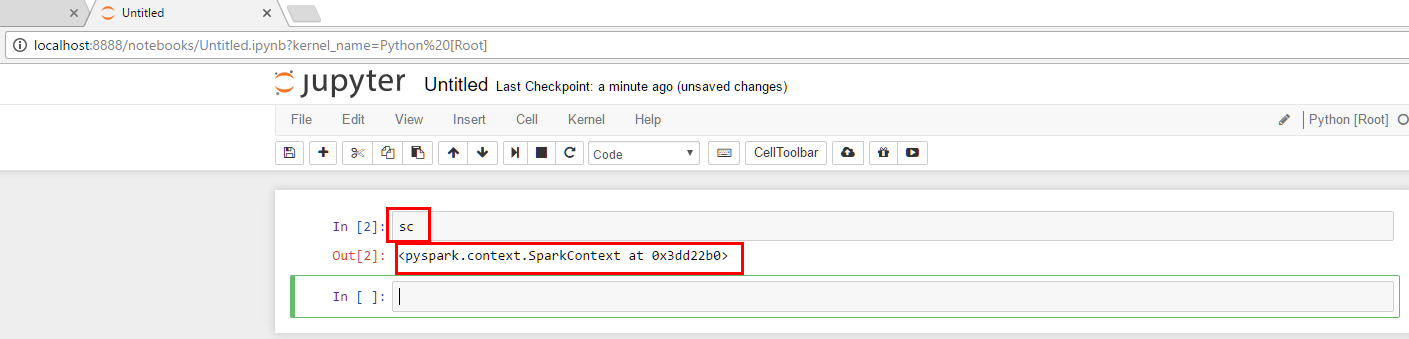

6.3测试sc的spark变量是否可用

注意:1.下载Spark请选择已经编译好的版本,如果选择源码版本,请使用maven或sbt进行编译即可,方法为进入Spark安装目录,使用> sbt package 进行编译

2.拷贝 E:sparkpythonpyspark 到 D:anacondaLibsite-packages 目录下