1. 过度拟合

overfittingt是这样一种现象:一个假设在训练数据上能够获得比其他假设更好的拟合,但是在训练数据外的数据集上却不能很好的拟合数据。此时我们就叫这个假设出现了overfitting的现象。出现这种现象的主要原因是训练数据中存在噪音或者训练数据太少。而解决overfit的方法主要有两种:提前停止树的增长或者对已经生成的树按照一定的规则进行后剪枝。

百度中关于overfitting的标准定义:给定一个假设空间H,一个假设h属于H,如果存在其他的假设h’属于H,使得在训练样例上h的错误率比h’小,但在整个实例分布上h’比h的错误率小,那么就说假设h过度拟合训练数据。

2. 交叉验证

交叉验证(Cross validation),有时亦称循环估计, 是一种统计学上将数据样本切割成较小子集的实用方法。于是可以先在一个子集上做分析, 而其它子集则用来做后续对此分析的确认及验证。 一开始的子集被称为训练集。而其它的子集则被称为验证集或测试集。交叉验证是一种评估统计分析、机器学习算法对独立于训练数据的数据集的泛化能力(generalize),

交叉验证一般要尽量满足:

1)训练集的比例要足够多,一般大于一半

2)训练集和测试集要均匀抽样

具体可参考:http://blog.csdn.net/xywlpo/article/details/6531128

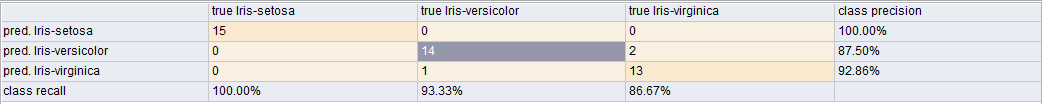

3. Recall和Precision的区别

查全率(Recall)是测量被正确提取的信息的比例,而查准率(Precision)用来测量提取出的信息中有多少是正确的。

计算公式如下(P是查准率,R是查全率):

查准率 = 提取出的正确信息条数 / 提取出的信息条数

查全率 = 提取出的正确信息条数 / 样本中的信息条数

如下所示: