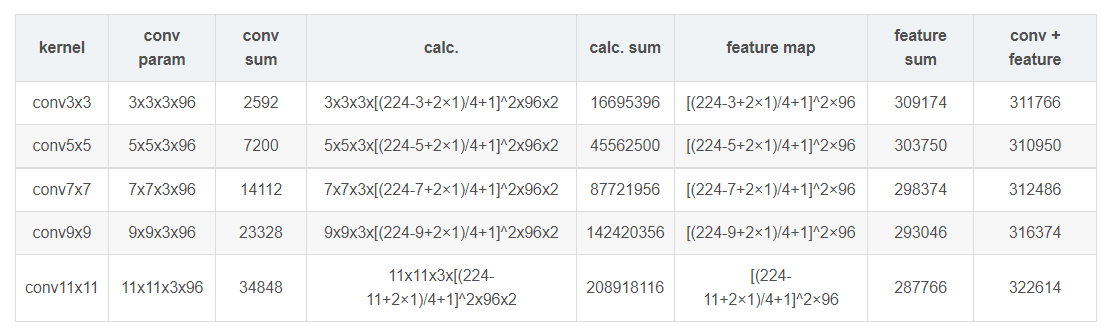

计算了同样conv3x3、conv5x5、conv7x7、conv9x9和conv11x11,在224x224x3的RGB图上(设置pad=1,stride=4,output_channel=96)做卷积,卷积层的参数规模和得到的feature map的大小:

看来大卷积核带来的参数量并不大(卷积核参数+卷积后的feature map参数,不同kernel大小这二者加和都是30万的参数量),即使考虑AlexNet中有两种形式的卷机组([conv-relu]-lrn-pool和[conv-relu]-[conv-relu]-[conv-relu]-pool)。实际增大的是计算量(上面我列出了计算量的公式,最后要乘以2,代表乘加操作)。为了尽可能证一致,我这里所有卷积核使用的stride均为4,可以看到,conv3x3、conv5x5、conv7x7、conv9x9、conv11x11的计算规模依次为:1600万,4500万,1.4亿、2亿,这种规模下的卷积,虽然参数量增长不大,但是计算量是恐怖的。