作业来源于:https://edu.cnblogs.com/campus/gzcc/GZCC-16SE2/homework/3319

1.用自己的话阐明Hadoop平台上HDFS和MapReduce的功能、工作原理和工作过程。

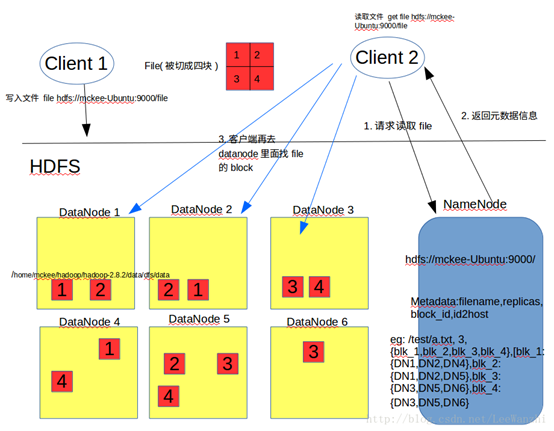

HDFS功能:

1.元数据

Metadata,维护文件和目录信息,分为内存元数据和元数据文件

NameNode主要存储元数据镜像文件Fsimage和日志文件Edits

Fsimage记录某一永久性检查点时整个HDFS的元信息

Edits所有对HDFS的写操作都会记录在此文件

2.检查点

定期对NameNode中的文件进行备份,NameNode启动时会将最新的Fsimage加载到内存中

由secondary namenode完成namenode备份,后者损坏后前者将fsimage拷贝到namenode工作目录,恢复其元数据

触发条件分为两次检查点间隔时间和两次检查点操作数两种

3.DataNode功能

存储管理用户的文件块数据,默认128M/block

定期汇报块信息给namenode

Mapreduce功能:

1)数据划分和计算任务调度,

2)数据/代码互定位,

3)系统优化,

4)出错检测和恢复

HDFS工作原理及流程:

Mapreduce工作原理及流程:

MapReduce的执行步骤:

1、Map任务处理

1.1 读取HDFS中的文件。每一行解析成一个<k,v>。每一个键值对调用一次map函数。

1.2 覆盖map(),接收1.1产生的<k,v>,进行处理,转换为新的<k,v>输出。

1.3 对1.2输出的<k,v>进行分区。默认分为一个区。

1.4 对不同分区中的数据进行排序(按照k)、分组。分组指的是相同key的value放到一个集合中。

2、Reduce任务处理

2.1 多个map任务的输出,按照不同的分区,通过网络copy到不同的reduce节点上。

2.2 对多个map的输出进行合并、排序。覆盖reduce函数,接收的是分组后的数据,实现自己的业务逻辑,处理后,产生新的<k,v>输出。

2.3 对reduce输出的<k,v>写到HDFS中。

2.HDFS上运行MapReduce

1)准备文本文件,放在本地/home/hadoop/wc

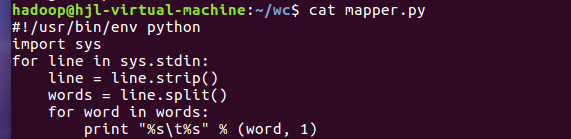

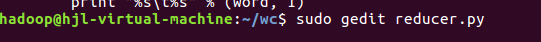

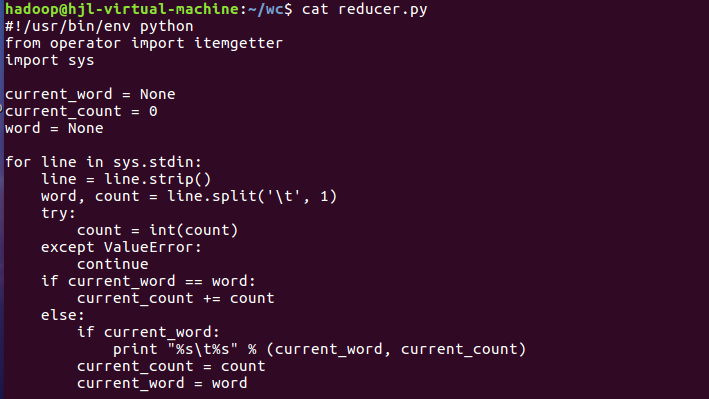

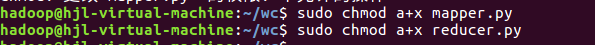

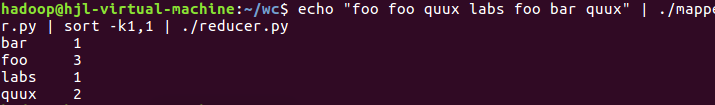

2)编写map函数和reduce函数,在本地运行测试通过

尝试运行:

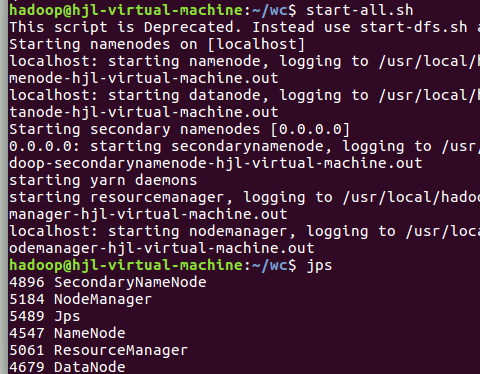

3)启动Hadoop:HDFS, JobTracker, TaskTracker

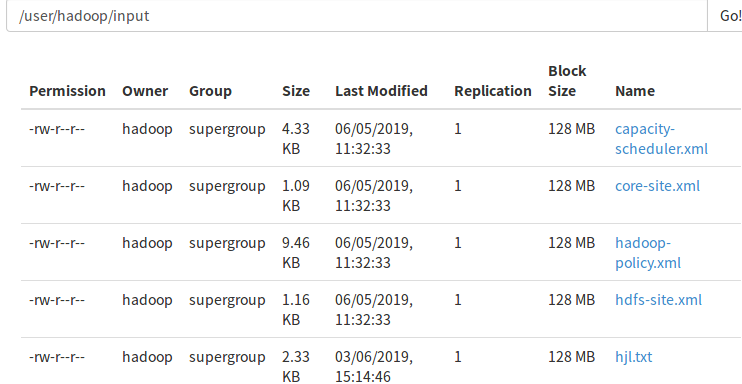

4)把文本文件上传到hdfs文件系统上 user/hadoop/input

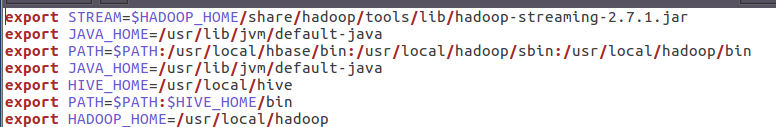

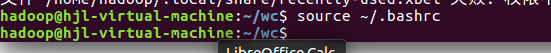

5)streaming的jar文件的路径写入环境变量,让环境变量生效

6)建立一个shell脚本文件:streaming接口运行的脚本,名称为run.sh

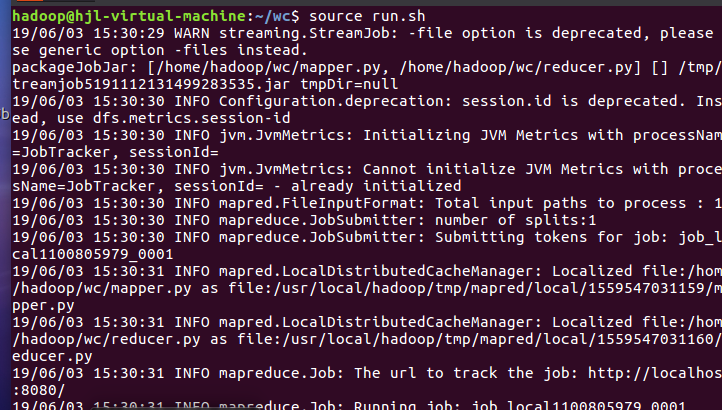

7)source run.sh来执行mapreduce

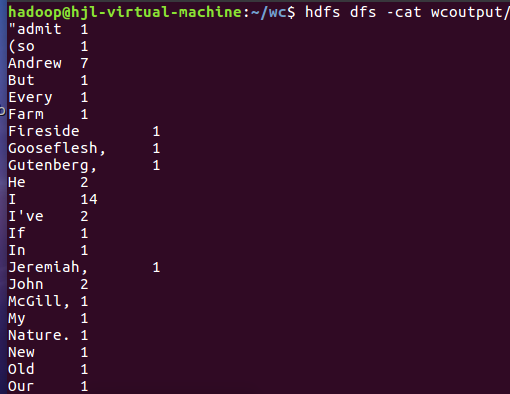

8)查看运行结果