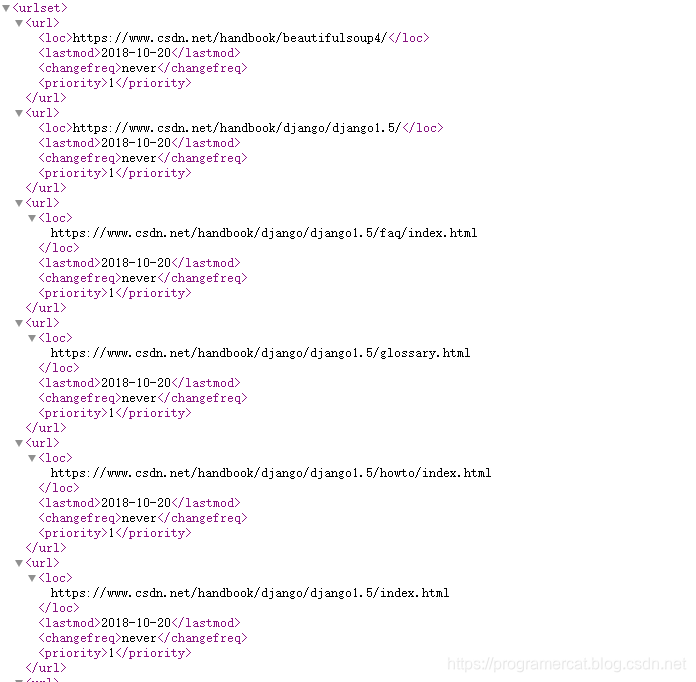

SitemapSiper 允许我们通过网站的 Sitemap 文件中的 URL 来爬取一个网站。Sitemap 文件包含整个网站的每个网址链接,其中包含了上次更新时间、更新频率以及网址的权重(重要程度)。常见的 Sitemap 文件格式有 TXT 、 XML 和 HTML 格式,大部分网站是以 XML 格式来显示的。下面我们来看一下 CSDN 网站的 Sitemap 文件格式。

我们来讲解一下上图中各个节点的意思:

- loc:完整的网址;

- lastmod:最后修改时间;

- changefreq:更新频率;

- priority:链接的权重。

下面我们来讲解一下 SitemapSiper 中常用的属性:

- sitemap_urls:包含待爬取 url 的 Sitemap 列表;

- sitemap_rules:元组列表,包含正则表达式和回调函数,格式是这样的 (regex,callback)。regex 可以是正则表达式,也可以是一个字符串。 callback 用于处理 url 的回调函数;

- sitemap_follow:指定需要跟进 Sitemap 的正则表达式列表;

- sitemap_alternate_link:当指定的 url 有可选的链接时是否跟进,默认不跟进。这里所谓的可选链接指的是备用网址,一般的格式如下:

<url>

<loc>http://aaa.com</loc>

<!--备用网址/可选链接-->

<xhtml:link rel="alternate" hreflang="en" href="http://aaa.com/en"/>

</url>

零、例子

下面我们通过爬取 CSDN 的 Sitemap 来看一下怎么使用 SitemapSiper 。

from scrapy.spiders import SitemapSpider

from ..items import CsdnItem

class csdnspider(SitemapSpider):

name = 'csdn_spider'

sitemap_urls = ['https://www.csdn.net/sitemap.xml']

sitemap_rules = [

('beautifulsoup4', 'parse')

]

def parse(self, response):

docs = response.css('.local-toc li')

for doc in docs:

item = CsdnItem()

item["title"] = doc.css(".reference::text").extract_first()

item["url"] = doc.css(".reference::attr(href)").extract_first()

yield item

import scrapy

class CsdnItem(scrapy.Item):

title = scrapy.Field()

url = scrapy.Field()