使用正则表达式的几个步骤:

1、用import re 导入正则表达式模块;

2、用re.compile()函数创建一个Regex对象;

3、用Regex对象的search()或findall()方法,传入想要查找的字符串,返回一个Match对象;

4、调用Match对象的group()方法,返回匹配到的字符串。

在交互式环境中简单尝试一下,查询字符串中的固话:

1 import re 2 text = '小明家的固话是0755-123456,而小丽家的固话时0789-654321,小王家的电话是123456789'#用于检测的字符串 3 4 ph_re = re.compile(r'd{4}?-d+') #创建Regex对象,匹配几种电话的方式,d表示0-9的数字,{4}表示前面的匹配4次,?表示可选,+表示出现1次或多次。 5 matchs1 = ph_re.findall(text) #findall()表示查找所有匹配项,返回一个字符串 6 matchs2 = ph_re.search(text)#search(),查找第一次匹配的文本,返回一个对象。 7 print(matchs1) 8 print(matchs2) 9 matchs2.group()

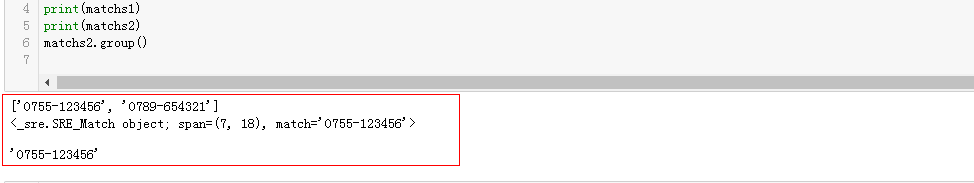

返回的结果,是这样的:

findall()方法返回的是一个字符串,可以直接打印出来。而search()方法返回的是一个对象,所以打印出来的是是如图的第二行。

调用group(),对象返回匹配的结果。

最后,小王的电话之所以没有匹配到,是因为'-'没有进行可选即在其后加上‘?’。

下面进行一个小的实验,获取某个网页中所有的http/https网址,并计算有多少个。

首先是获取HTML文件。这里要用到requests模块。

1 # -*- coding: utf-8 -*- 2 import requests 3 import re 4 5 6 def get_html(url): 7 res = requests.get(url) 8 res.encoding = 'utf-8' 9 html = res.text 10 return html

这里get_html函数返回的,其实就类似上面例子中的text,用来匹配的文本。

然后,创建正则表达式:

1 def get_addr(response): 2 addr_regex = re.compile(r'''( 3 (http://|https://)? #http/https 4 (www)? 5 (.[a-z1-9A-Z]+) 6 (.com|.cn) 7 )''',re.VERBOSE)#匹配网址, 8 matchs = [] 9 for groups in addr_regex.findall(response): 10 matchs.append(groups[0]) 11 if len(matchs) == 0: 12 print('没有网址') 13 return matchs

这里向re.compile(),传入变量re.VERBOSE,作为第二个参数,可以将正则表达式放在多行,并进行注释,如上。

返回一个matchs列表对象。

再来个启动函数。

1 def start(): 2 url = 'http://news.163.com/18/0127/18/D966K4CO0001899N.html' 3 a = get_html(url) 4 b = get_addr(a) 5 print(' '.join(b)) 6 print(str(len(b))) 7 print('ok') 8 if __name__ == '__main__': 9 start()

这里传入的url是我随意找的一个新闻链接。

然后调用get_html()和get_addr(),就得到了想要的东西。str(len(b)),为统计的数量。

测试的结果是类似这样的:

这里似乎获取一些URL,没什么卵用。。。但是,如果结合前面的查询新闻列表的方式,获取批量url,

而创建的正则是xxx.jpg,然后调用os模块,os.mkdir(folder)、os.chdir(folder),将获取到的匹配结果写入文件,放入某个文件夹。

那么就可以实现,从某些网站上批量获取jpg图片,然后存入某个文件夹的爬虫功能。实测,可行!