一:问题描述

Learning问题就是参数估计问题,也就是求模型参数λ,具体形式为 :λ_hat=argmax P(O|λ) 【通过最大化似然求得最优模型参数 λ;优化算法用EM,可类比GMM模型中求θ用的EM】

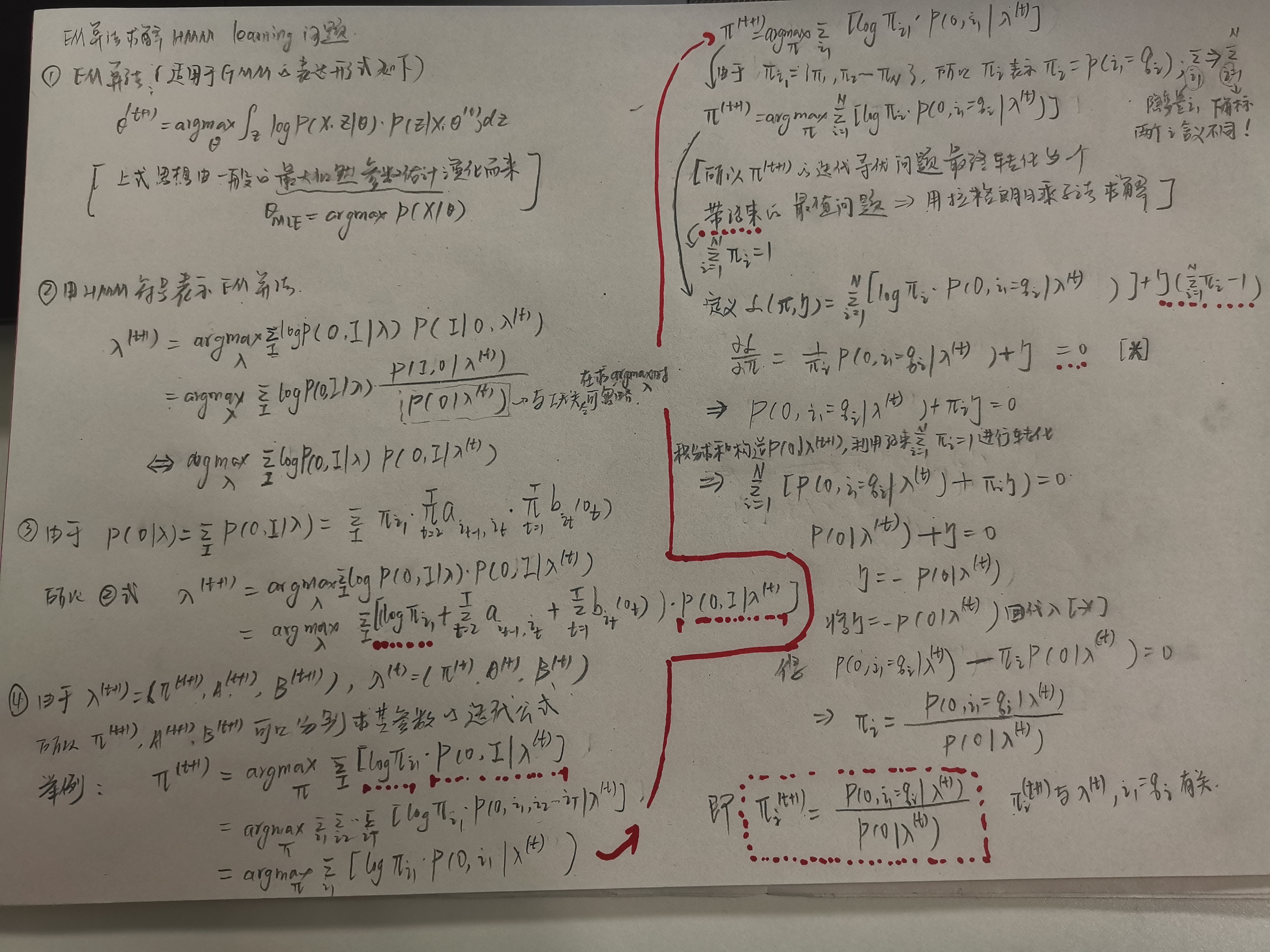

二、EM算法应用于HMM-learning模型的公式推导(具体可参考之前博客GMM:EM)

(来源:B站up主,shuhuai008,板书)

备注:

①最后求出![]() 后,需要再代回

后,需要再代回![]() ,最后得到t+1时刻的Π值。【拉格朗日乘子法也可以用于求数值解】

,最后得到t+1时刻的Π值。【拉格朗日乘子法也可以用于求数值解】

②将EM算法应用于HMM算法的求解,其实就是引入EM算法的公式,然后用HMM的参数套入EM算法。

通过条件概率公式进行化简,将参数迭代寻优的过程转化为带约束的求最值问题,然后按一般思路,用拉格朗日乘子法求解,得到Π(t+1),A(t+1),B(t+1)的迭代公式。

应用于HMM模型的EM算法公式推导

将HMM参数套用进EM算法,得到适用于解决HMM-learning问题的EM算法,经过一系列转化,转化为带约束的最值问题,再用拉格朗日乘子法求解出参数的迭代公式

公式推导中的关键小技巧:

①P(I|O,λ(t)) 转化为PP(I,O|λ(t)),便于后续步骤中利用条件概率和积分求和,将i2,i3,...iT化简掉

②注意P(O|λ)的公式在EM公式中的化用=> 将λ=(PI,A,B)三个参数解耦,各自独立迭代寻优。

④注意隐含约束:Σ1NΠi=1,用在两个地方。

第一个地方是将约束放进最值公式(拉格朗日乘子法);

另一个地方是在求解拉格朗日乘子![]() 的过程中,将P(O,i1=qi|λ(t))通过积分求和转化为P(O|λ)。

的过程中,将P(O,i1=qi|λ(t))通过积分求和转化为P(O|λ)。

参考资料:

1.https://www.bilibili.com/video/BV1MW41167Rf?p=5。作者:shuhuai008