一、简介

-

HBase – Hadoop Database,是一个高可靠性、高性能、面向列、可伸缩、实时读写的分布式数据库

-

利用Hadoop HDFS作为其文件存储系统,利用Hadoop MapReduce来处理HBase中的海量数据,利用Zookeeper作为其分布式协同服务

- 主要用来存储非结构化和半结构化的松散数据(列存 NoSQL 数据库)

二、数据模型

- ROW KEY

-

决定一行数据

-

– 按照字典顺序排序的。

-

– Row key只能存储64k的字节数据

-

- Column Family列族 & qualifier列

-

HBase表中的每个列都归属于某个列族,列族必须作为表模式(schema)定义的一部分预先给出。如 create ‘test’, ‘course’;

-

列名以列族作为前缀,每个“列族”都可以有多个列成员(column);如course:math, course:english, 新的列族成员(列)可以随后按需、动态加入;

-

权限控制、存储以及调优都是在列族层面进行的;

-

HBase把同一列族里面的数据存储在同一目录下,由几个文件保存。

-

- Timestamp时间戳

-

在HBase每个cell存储单元对同一份数据有多个版本,根据唯一的时间戳来区分每个版本之间的差异,不同版本的数据按照时间倒序排序,最新的数据版本排在最前面。

-

时间戳的类型是 64位整型。

-

时间戳可以由HBase(在数据写入时自动)赋值,此时时间戳是精确到毫秒的当前系统时间。

-

时间戳也可以由客户显式赋值,如果应用程序要避免数据版本冲突,就必须自己生成具有唯一性的时间戳

-

- Cell单元格

-

由行和列的坐标交叉决定;

-

单元格是有版本的;

-

单元格的内容是未解析的字节数组;

• 由 {row key, column( =<family> +<qualifier>), version} 唯一确定的单元。cell中的数据是没有类型的,全部是字节码形式存贮。

-

- HLog(WAL log)

-

HLog文件就是一个普通的Hadoop Sequence File,Sequence File 的Key是HLogKey对象,HLogKey中记录了写入数据的归属信息,除了table和region名字外,同时还包括 sequence number和timestamp,timestamp是”写入时间”,sequence number的起始值为0,或者是最近一次存入文件系统中sequence number。

-

HLog SequeceFile的Value是HBase的KeyValue对象,即对应HFile中的KeyValue。

-

-

Client

-

包含访问HBase的接口并维护cache来加快对HBase的访问

-

-

Zookeeper

-

保证任何时候,集群中只有一个master

-

存贮所有Region的寻址入口。

-

实时监控Region server的上线和下线信息。并实时通知Master

-

存储HBase的schema和table元数据

-

-

Master为Region server分配region

-

负责Region server的负载均衡

-

发现失效的Region server并重新分配其上的region

-

管理用户对table的增删改操作

-

-

RegionServer

-

Region server维护region,处理对这些region的IO请求

-

Region server负责切分在运行过程中变得过大的region

-

-

Region

-

HBase自动把表水平划分成多个区域(region),每个region会保存一个表里面某段连续的数据;每个表一开始只有一个region,随着数据不断插入表,region不断增大,当增大到一个阀值的时候,region就会等分会两个新的region(裂变);

-

当table中的行不断增多,就会有越来越多的region。这样一张完整的表被保存在多个Regionserver 上。

-

-

Memstore 与 storefile

-

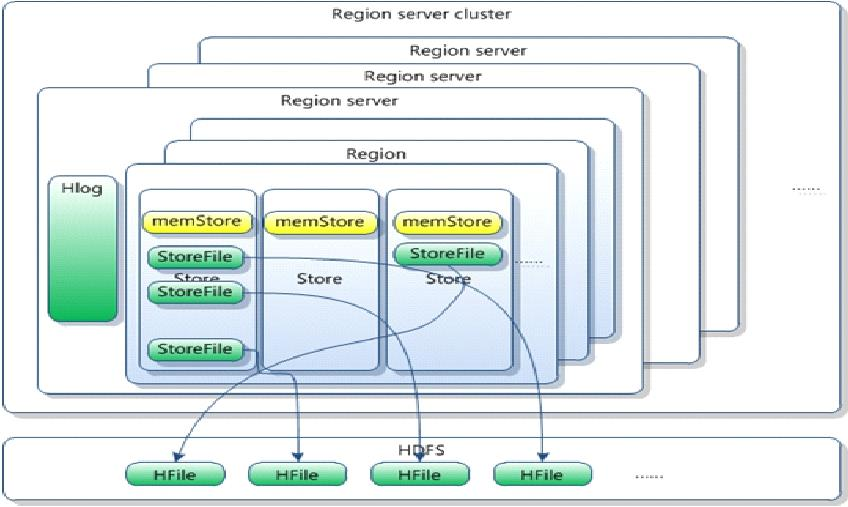

一个region由多个store组成,一个store对应一个CF(列族)

-

store包括位于内存中的memstore和位于磁盘的storefile写操作先写入memstore,当memstore中的数据达到某个阈值,hregionserver会启动flashcache进程写入storefile,每次写入形成单独的一个storefile

-

当storefile文件的数量增长到一定阈值后,系统会进行合并(minor、major compaction),在合并过程中会进行版本合并和删除工作(majar),形成更大的storefile

-

当一个region所有storefile的大小和数量超过一定阈值后,会把当前的region分割为两个,并由hmaster分配到相应的regionserver服务器,实现负载均衡

-

客户端检索数据,先在memstore找,找不到再找storefile

-

HRegion是HBase中分布式存储和负载均衡的最小单元。最小单元就表示不同的HRegion可以分布在不同的 HRegion server上。

HRegion由一个或者 多个Store组成,每个store保存一个columns family。

每个Strore又由一个memStore和0至多个StoreFile组成。如图:StoreFile以HFile格式保存在HDFS上。

三、HBase集群安装

前提:Hadoop集群要启动正常,Zookeeper集群启动正常

- 配置regionservers ,主机名

- 配置backup-masters

- 配置hbase-env.sh

- 配置JAVA_HOME

- 配置HBASE_MANAGERS_ZK=false

- 配置hbase-site.xml

- Hbase.rootdir

- Zookeeper集群主机

- 启用hbase集群:true

- 把hdfs-site.xml (or hadoop-site.xml) 拷贝到${HBASE_HOME}/conf下

- 启动hbase

hbase-site.xml示例

hbase-site.xml示例<configuration> <property> <name>hbase.rootdir</name> <value>hdfs://namenode.example.org:8020/hbase</value> </property> <property> <name>hbase.cluster.distributed</name> <value>true</value> </property> <property> <name>hbase.zookeeper.quorum</name> <value>node-a.example.com,node-b.example.com,node-c.example.com</value> </property> </configuration>

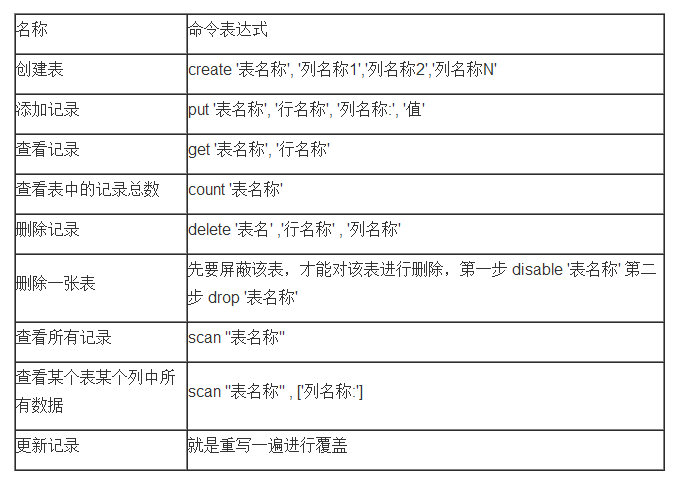

四、HBase Shell

- create 建立一个表 create 'scores','grade', 'course'

- list 查看当前HBase中具有哪些表

- describe 查看表的构造 describe 'scores'

五、Hbase表结构设计

根据新浪微博系统:请建立微博系统的表。

- 用户表不需要创建,假设用户已经存在,在DBMS中。

- 所有用户可以发微博

- 所有用户可以添加关注用户和取消关注用户

- 所有用户可以查看粉丝列表

- 用户首页,用户所关注的其他用户最新发布的微博列表。

用户表

| rowkey | cf1(关注列表) | cf2(粉丝列表) |

| uid | uid=uname | uid=uname |

微博表

| rowkey | cf1 |

| uid_LONG.MAX-time | content=微博内容 |

收微博表(主页用)

| rowkey | cf1 |

| uid | id=uid_LONG.MAX-time version=1000 |

六、protocal buffer

Protocol Buffers 是一种轻便高效的结构化数据存储格式,可以用于结构化数据串行化,或者说序列化。它很适合做数据存储或 RPC 数据交换格式。可用于通讯协议、数据存储等领域的语言无关、平台无关、可扩展的序列化结构数据格式。目前提供了 C++、Java、Python 三种语言的 API。

目的:每个cell都含有rowkey、列族、列、版本等,存的值都很短,大部分存储空间被浪费,把多列或多条数据合并成一个cell,节省storefile空间,提高存储空间使用率。

./configure –prefix=/usr/protobuffer

make&&make install

写好xx.proto文件,protoc --java_out=/app/ xx.proto

就生成了xx.java类,按照定义把属性封装好了,而且实现了序列化的方法。

七、MapReduce操作HBase

官网示例:http://hbase.apache.org/book.html#mapreduce.example

- 通过TableMapReduceUtil初始化job

- Mapclass需要实现TableMap

- reducerclass需要实现TableReducer

Configuration config = HBaseConfiguration.create(); Job job = new Job(config,"ExampleSummary"); job.setJarByClass(MySummaryJob.class); // class that contains mapper and reducer Scan scan = new Scan(); scan.setCaching(500); // 1 is the default in Scan, which will be bad for MapReduce jobs scan.setCacheBlocks(false); // don't set to true for MR jobs // set other scan attrs TableMapReduceUtil.initTableMapperJob( sourceTable, // input table scan, // Scan instance to control CF and attribute selection MyMapper.class, // mapper class Text.class, // mapper output key IntWritable.class, // mapper output value job); TableMapReduceUtil.initTableReducerJob( targetTable, // output table MyTableReducer.class, // reducer class job); job.setNumReduceTasks(1); // at least one, adjust as required boolean b = job.waitForCompletion(true); if (!b) { throw new IOException("error with job!"); }

public static class MyMapper extends TableMapper<Text, IntWritable> { public static final byte[] CF = "cf".getBytes(); public static final byte[] ATTR1 = "attr1".getBytes(); private final IntWritable ONE = new IntWritable(1); private Text text = new Text(); public void map(ImmutableBytesWritable row, Result value, Context context) throws IOException, InterruptedException { String val = new String(value.getValue(CF, ATTR1)); text.set(val); // we can only emit Writables... context.write(text, ONE); } }

public static class MyTableReducer extends TableReducer<Text, IntWritable, ImmutableBytesWritable> { public static final byte[] CF = "cf".getBytes(); public static final byte[] COUNT = "count".getBytes(); public void reduce(Text key, Iterable<IntWritable> values, Context context) throws IOException, InterruptedException { int i = 0; for (IntWritable val : values) { i += val.get(); } Put put = new Put(Bytes.toBytes(key.toString())); put.add(CF, COUNT, Bytes.toBytes(i)); context.write(null, put); } }

八、HBase调优