通过感知机和篇幅比较多的支持向量机的介绍后,是否对机器学习感觉到有点意思。今天,来点相比较支持向量机轻松的——$K$近邻法

$k$近邻法(k-nearest neighbor ,k-NN)是一种基本分类与回归方法。$k$近邻法假设给定一个训练数据集,其中的实例类别已定。分类时,对新的实例,根据其$k$个最近邻的训练实例的类别,通过多数表决等方式进行预测。因此,$k$近邻法不具有显示的学习过程。$k$近邻法实际上利用训练数据集对特征向量空间进行划分,并作为其分类的”模型“。$k$值的选择、距离度量以及分类决策规则是$k$近邻法的三个基本要素。

$k$近邻法:

输入:训练数据集

$$T={(x_1,y_1),(x_2,y_2),...,(x_N,y_N)}

其中,$x_i in mathcal{X} subseteq R^n$为实例的特征向量,$y_i in mathcal{Y} = {c_1,c_2,...,c_k}$为实例的类别,$i=1,2,...,N$;实例特征向量$x$;

输出:实例$x$所属的类$y$。

(1)根据给定的距离度量,在训练集$T$中找出与$x$最近邻的$k$个点,涵盖这$k$个点的$x$的领域记作$N_{k}(x)$;

(2)在$N_{k}(x)$中根据分类决策规则(如多数表决)决定$x$的类别$y$:

$$y = arg max_{c_j} sum_{x_i in N_{k}(x)} I(y_i = c_j), i=1,2,...,N; j=1,2,...,K$$

其中,$I$为指示函数,即当$y_i = c_j$时$I$为1,否则$I$为0。

$k$近邻法的特殊情况是$k=1$的情形,称为最近邻算法。对于输入的实例点(特征向量)$x$,最近邻法将训练数据集中与$x$最近邻点的类作为$x$的类。

$k$近邻模型

$k$近邻法使用的模型实际上对应于对特征空间的划分。模型由三个基本要素——距离度量、$k$值的选择和分类决策规则决定。

模型:

$k$近邻法中,当训练集、距离度量(如欧式距离)、$k$值以及分类决策规则(如多数表决)确定后,对于任何一个新的输入实例,它所属的类唯一地确定。

距离度量:

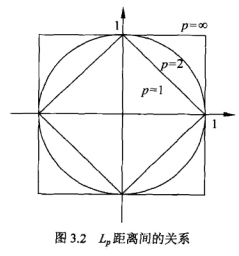

特征空间中两个实例点的距离是两个实例点相似度的反映。$k$近邻模型的特征空间一般是$n$维实数向量空间$R^n$。使用的距离是欧式距离,但也可以是其他距离,如更一般的$L_p$距离。

设特征空间$mathcal{X}$是$n$维实数向量空间$R^n, x_i,x_j in mathcal{X}, x_i = (x_i^{(1)},x_i^{(2)},...,x_i^{(n)})^{T}, x_j = (x_j^{(1)},x_j^{(2)},...,x_j^{(n)})^{T}, x_i,x_j$的$L_p$距离定义为:

$$L_p(x_i,x_j) = (sum_{l=1}^{n}|x_i^{(l)} - x_j^{(l)}|^{p})^{frac{1}{p}}$$

这里$p geq 1$,当$p=2$时,称为欧式距离,当$p=1$时,称为曼哈顿距离,当$p=infty$时,它是各个坐标距离的最大值,即:

$$L_{infty}(x_i,x_j) = max_{l}|x_i^{(l)} - x_j^{(l)}|$$

$k$值的选择:

$k$值的选择会对$k$近邻法的结果产生重大影响。

如果选择较小的$k$值,就相当于用较小的领域中的训练实例进行预测,“学习”的近似误差会减少,只有与输入实例较近的(相似的)训练实例才会对预测结果起作用。但缺点是“学习”的估计误差会增大,预测结果会对近邻的实例点非常敏感。如果近邻的实例点恰巧是噪声,预测就会出错。换句话说,$k$值的减少就意味着整体模型变得复杂,容易发生过拟合。

如果选择较大的$k$值,就相当于用较大领域中的训练实例进行预测。其优点是可以减少学习的估计误差。但缺点是学习的近似误差会增大。这时与输入实例较远的(不相似的)训练实例也会对预测起作用,使预测发生错误。$k$值的增大就意味着整体的模型变得简单。

如果$k=N$,那么无论输入实例是什么,都降低简单地预测它属于训练实例中最多的类。这时,模型过于简单,完全忽略训练实例中的大量有用信息,是不可取的。

在应用中,$k$值一般取一个比较小的数值,通常采用交叉验证法来选取最优的$k$值。

分类决策规则:

$k$近邻法中的分类决策规则往往是多数表决,即由输入实例的$k$个近邻的训练实例中的多数类决定输入实例的类。

$k$近邻法的实现:$kd$树

实现$k$近邻法时,主要考虑的问题时如何对训练数据进行快速$k$近邻搜索。这点在特征空间的维数大及训练数据容量大时尤其必要。

$k$近邻法最简单的实现方法时线性扫描。这时要计算输入实例与每一个训练实例的距离。当训练集很大时,计算非常耗时,这种方法是不可行的。

为了提高$k$近邻搜索的效率,可以考虑使用特殊的结构存储训练数据,以减少计算距离的次数。如:$kd$树方法。

kd树:

详细参考博客

构造kd树:

输入:$k$维空间数据集$T = {x_1,x_2,...,x_N}$,其中$x_i = (x_i^{(1)},x_i^{(2)},...,x_i^{(k)})^T, i=1,2,...,N$;

输出:$kd$树

(1)开始:构造根节点,根节点对应于包含$T$的$k$维空间的超矩形区域。

选择$x^{(1)}$为坐标轴,以$T$中所有实例的$x^{(1)}$坐标的中位数为切分点,将根节点对应的超矩形区域切分为两个子区域。切分由通过切分点并与坐标轴$x^{(1)}$垂直的超平面实现。由根节点生成深度为1的左、右子结点:左子结点对应坐标$x^{(1)}$小于切分点的子区域,右子结点对应于坐标$x^{(1)}$大于切分点的子区域。将落在切分超平面上的实例点保存在根节点。

(2)重复:对深度为$j$的结点,选择$x^{(l)}$为切分的坐标轴,$l=j(mod k) + 1$,$j(mod k)$是求余运算,以该结点的区域中所有实例的$x^{(l)}$坐标的中位数为切分点,将该结点对应的超矩形区域切分为两个子区域,切分由通过切分点并与坐标轴$x^{(l)}$垂直的超平面实现。由该结点生成深度为$j+1$的左、右子结点:左子结点对应坐标$x^{(l)}$小于切分点的子区域,右子结点对应坐标$x^{(l)}$大于切分点的子区域。

(3)直到两个子区域没有实例存在时停止,从而形成$kd$树的区域划分。

搜索kd树:(用$kd$树的最近邻搜索)

输入:已构造的$kd$树;目标点$x$;

输出:$x$的最近邻

(1)在$kd$树中找出包含目标点$x$的叶节点:从根节点出发,递归地向下访问$kd$树。若目标点$x$当前维的坐标小于切分点的坐标,则移动到左子结点,否则移动到右子结点。直到子结点为叶节点为止。

(2)以此叶节点为“当前最近点”。

(3)递归地向上回退,在每个结点进行以下操作:

(a)如果该结点保存的实例点比当前最近点距离目标点更近,则以该实例点位“当前最近点”。

(b)当前最近点一定存在于该结点一个子结点对应的区域。检查该子结点的父节点的另一子结点对应的区域是否有更近的点。具体地,检查另一子结点对应的区域是否以目标点为球心、以目标点与“当前最近点”间的距离为半径的超球体相交。如果相交,可能在另一个子结点对应的区域内存在距目标点更近的点,移动到另一个子结点。接着,递归地进行最近邻搜索。如果不相交,向上回退。

(4)当回退到根结点时,搜索结束。最后的“当前最近点”即为$x$的最近邻点。