一、sqoop作用?

sqoop是一个数据交换工具,最常用的两个工具是导入导出。

导入导出的参照物是hadoop,向hadoop导数据就是导入。

二、sqoop的版本?

sqoop目前有两个版本,1.4.X为sqoop1;1.99.X为sqoop2。两个版本不兼容。

三、使用sqoop列出mysql下的所有数据库

(my_python_env)[root@hadoop26 ~]# sqoop list-databases --connect jdbc:mysql://localhost:3306 --username root --password 123456 information_schema hive mysql test

四、Import工具的使用

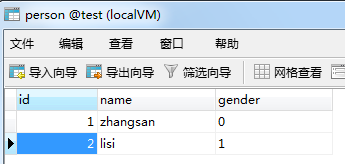

4.1将mysql中的某张表导入到hdfs上,现在test下有一张person表

4.2执行sqoop语句

sqoop import --connect jdbc:mysql://localhost:3306/test --username root --password 123456 -table person

4.3在hdfs用户的家目录下,产生了一个person文件夹

(my_python_env)[root@hadoop26 ~]# hadoop fs -ls Found 2 items drwx------ - root supergroup 0 2016-07-03 23:00 .Trash drwxr-xr-x - root supergroup 0 2016-07-21 22:30 person (my_python_env)[root@hadoop26 ~]# hadoop fs -ls person Found 3 items -rw-r--r-- 1 root supergroup 0 2016-07-21 22:30 person/_SUCCESS -rw-r--r-- 1 root supergroup 17 2016-07-21 22:30 person/part-m-00000 -rw-r--r-- 1 root supergroup 12 2016-07-21 22:30 person/part-m-00001 (my_python_env)[root@hadoop26 ~]# hadoop fs -cat person/part-* 1,zhangsan,false 2,lisi,true

4.4delete-target-dir参数

当再次执行sqoop语句的时候,会报错,因为person文件夹已经存在了,我们需要先删除这个文件夹再运行sqoop语句。

也可以使用sqoop提供的delete-target-dir参数

sqoop import --connect jdbc:mysql://localhost:3306/test --username root --password 123456 -table person --delete-target-dir

4.5append参数

如果目标文件夹在hdfs上已经存在,那么再次运行就会报错。可以使用--delete-target-dir来先删除目录。也可以使用append来往目录下追加数据。append和delete-target-dir是相互冲突的。

sqoop import --connect jdbc:mysql://localhost:3306/test --username root --password 123456 --table person --append

执行完成后,查看hdfs上的文件

(my_python_env)[root@hadoop26 ~]# hadoop fs -ls person Found 5 items -rw-r--r-- 1 root supergroup 0 2016-07-21 22:50 person/_SUCCESS -rw-r--r-- 1 root supergroup 17 2016-07-21 22:50 person/part-m-00000 -rw-r--r-- 1 root supergroup 12 2016-07-21 22:50 person/part-m-00001 -rw-r--r-- 1 root supergroup 17 2016-07-21 23:48 person/part-m-00002 -rw-r--r-- 1 root supergroup 12 2016-07-21 23:48 person/part-m-00003

4.6target-dir参数

上述的所有操作都是吧mysql中的数据写到一个默认的目录下,可以使用target-dir来指定hdfs的目录名

sqoop import --connect jdbc:mysql://localhost:3306/test --username root --password 123456 --table person --append --target-dir person-mysql

查看hdfs上的目录

(my_python_env)[root@hadoop26 ~]# hadoop fs -ls Found 4 items drwx------ - root supergroup 0 2016-07-03 23:00 .Trash drwxr-xr-x - root supergroup 0 2016-07-21 23:53 _sqoop drwxr-xr-x - root supergroup 0 2016-07-21 23:48 person drwxr-xr-x - root supergroup 0 2016-07-21 23:53 person-mysql

4.7map的个数

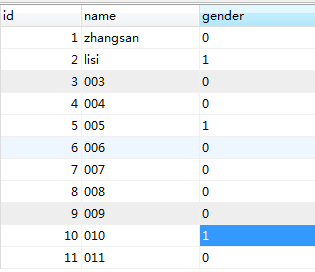

现在mysql表person中的数据增加到了11条

再次执行sqoop语句来导入

sqoop import --connect jdbc:mysql://localhost:3306/test --username root --password 123456 --delete-target-dir --table person --target-dir person-mysql

查看hdfs上的目录

(my_python_env)[root@hadoop26 ~]# hadoop fs -ls person-mysql Found 5 items -rw-r--r-- 1 root supergroup 0 2016-07-21 23:59 person-mysql/_SUCCESS -rw-r--r-- 1 root supergroup 41 2016-07-21 23:59 person-mysql/part-m-00000 -rw-r--r-- 1 root supergroup 35 2016-07-21 23:59 person-mysql/part-m-00001 -rw-r--r-- 1 root supergroup 24 2016-07-21 23:59 person-mysql/part-m-00002 -rw-r--r-- 1 root supergroup 37 2016-07-21 23:59 person-mysql/part-m-00003

从上面的结果可以发现,这个作业启动了4个map任务,所以sqoop默认配置就是4个map,用户也可以通过-m参数,自己指定map的数量

sqoop import --connect jdbc:mysql://localhost:3306/test --username root --password 123456 --delete-target-dir --table person --target-dir person-mysql -m 1

查看hdfs上的目录发现,这次只启动了一个map任务

(my_python_env)[root@hadoop26 ~]# hadoop fs -ls person-mysql Found 2 items -rw-r--r-- 1 root supergroup 0 2016-07-22 00:02 person-mysql/_SUCCESS -rw-r--r-- 1 root supergroup 137 2016-07-22 00:02 person-mysql/part-m-00000

4.8where参数

where参数可以进行一些简单的筛选

sqoop import --connect jdbc:mysql://localhost:3306/test --username root --password 123456 --delete-target-dir --table person --target-dir person-mysql -m 1 --where "gender=0"

(my_python_env)[root@hadoop26 ~]# hadoop fs -cat person-mysql/part* 1,zhangsan,false 3,003,false 4,004,false 6,006,false 7,007,false 8,008,false 9,009,false 11,011,false

4.9query参数

query参数就可以让用户随意写sql语句来查询了。query和table参数是互斥的。

sqoop import --connect jdbc:mysql://localhost:3306/test --username root --password 123456 --delete-target-dir --target-dir person-mysql -m 1 --query "select * from person where name='003' and gender=0 and $CONDITIONS"

(my_python_env)[root@hadoop26 ~]# hadoop fs -cat person-mysql/part-* 3,003,false

4.10压缩

如果想要使得导入到hdfs上的数据被压缩,就可以使用-z或者--compression-codec来进行压缩,-z压缩方式是gzip压缩,--compression-codec可以自定义压缩方式

sqoop import --connect jdbc:mysql://localhost:3306/test --username root --password 123456 --delete-target-dir --target-dir person-mysql -m 1 --table person -z

查看hdfs上的结果:

(my_python_env)[root@hadoop26 ~]# hadoop fs -ls person-mysql Found 2 items -rw-r--r-- 1 root supergroup 0 2016-07-22 00:38 person-mysql/_SUCCESS -rw-r--r-- 1 root supergroup 99 2016-07-22 00:38 person-mysql/part-m-00000.gz

使用Snappy方式压缩

sqoop import --connect jdbc:mysql://localhost:3306/test --username root --password 123456 --delete-target-dir --target-dir person-mysql -m 1 --table person --compression-codec org.apache.hadoop.io.compress.SnappyCodec

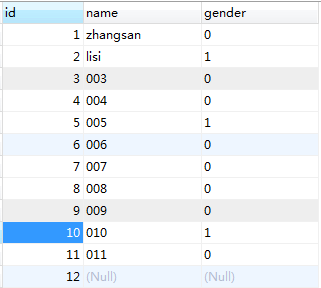

4.11空值处理

像如图id=12的记录是没有name和gender的,如果不加处理,导入到hdfs上是这样子的:

(my_python_env)[root@hadoop26 ~]# hadoop fs -cat person-mysql/part* 1,zhangsan,false 2,lisi,true 3,003,false 4,004,false 5,005,true 6,006,false 7,007,false 8,008,false 9,009,false 10,010,true 11,011,false 12,null,null

sqoop提供了--null-string来处理字符类型的空值,提供了--null-non-string来处理非字符类型的空值。

sqoop import --connect jdbc:mysql://localhost:3306/test --username root --password 123456 --delete-target-dir --target-dir person-mysql -m 1 --table person --null-string "" --null-non-string "false"

执行结果是:

(my_python_env)[root@hadoop26 ~]# hadoop fs -cat person-mysql/part* 1,zhangsan,false 2,lisi,true 3,003,false 4,004,false 5,005,true 6,006,false 7,007,false 8,008,false 9,009,false 10,010,true 11,011,false 12,,false

4.12增量传输

增量导入的一个场景就是昨天导入了一批数据,今天又增加了部分数据,现在要把这部分数据也导入到hdfs中。

sqoop import --connect jdbc:mysql://localhost:3306/test --username root --password 123456 --target-dir person-mysql -m 1 --table person --null-string "" --null-non-string "false" --check-column "id" --incremental append --last-value 5

执行结果是:

(my_python_env)[root@hadoop26 ~]# hadoop fs -cat person-mysql/part-m-00001 6,006,false 7,007,false 8,008,false 9,009,false 10,010,true 11,011,false 12,,false