使用命令:java -version 查看版本信息,这里要安装Java8(更新到8),安装方法见上一篇文章,jdk安装。

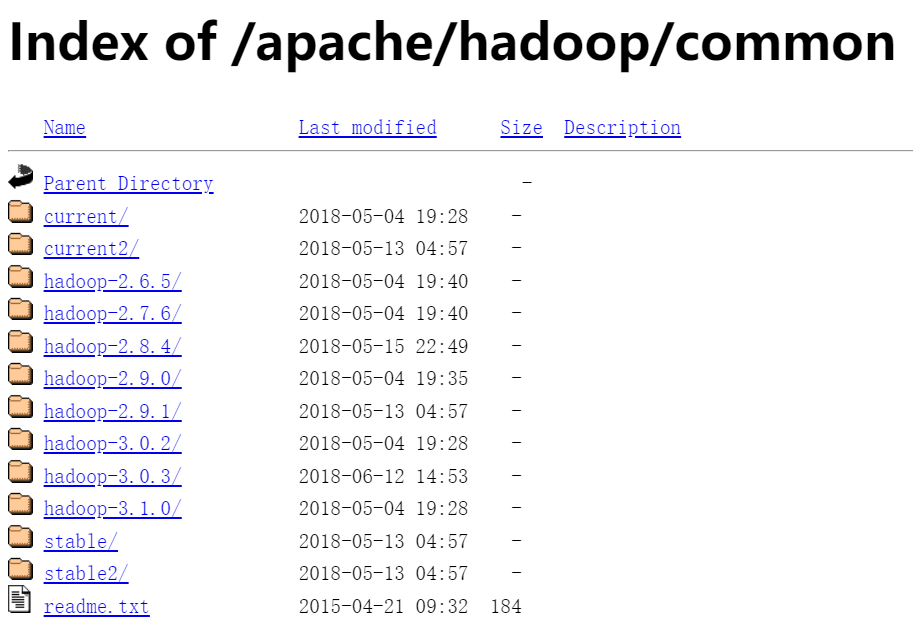

要安装hadoop自然要先下载安装包,关于版本的信息请点击:Hadoop版本信息 或者 官网版本信息 查看。下图是版本信息的展示:

这里我们安装Hadoop-2.6.4,进入Linux系统,解压到 /usr/local/hadoop:

cd /usr/local

mkdir hadoop

将文件解压到上面的目录

进入local/hadoop ,设置无密登陆:

ssh-keygen -t dsa -P '' -f ~/.ssh/id_dsa

cat ~/.ssh/id_dsa.pub >> ~/.ssh/authorized_keys

ssh localhost

进入vi /etc/hostname 编辑内容为 Master

进入 vi /etc/hosts 编辑:注释前两行,添加:192.168.80(这是你机器的IP,使用ifconfig查询) Master

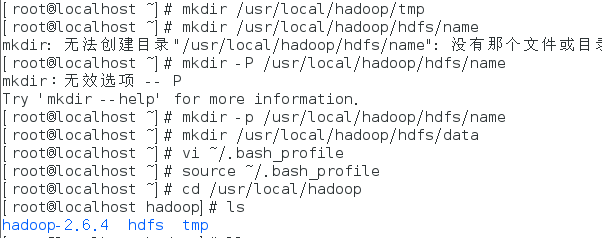

在hadoop文件下创建下面的文件:

在终端执行完之后,修改配置文件:

1、进入Hadoop的配置文件

cd /usr/local/hadoop/hadoop-2.6.4/etc/hadoop

2、vi hadoop-env.sh 添加 如下:

#export JAVA_HOME=${JAVA_HOME} 要注释的内容

export JAVA_HOME=/usr/local/jdk1.7.0_80

3、vi yarn-env.sh

export JAVA_HOME=/usr/local/jdk1.7.0_80 添加内容

4、vi core-site.xml,在<configuration>标签里添加:

1 <property> 2 <name>fs.defaultFS</name> 3 <value>hdfs://Master:9000</value> 4 </property> 5 <property> 6 <name>hadoop.tmp.dir</name> 7 <value>/usr/local/hadoop/tmp</value> 8 </property>

5、vi hdfs-site.xml ,在<configuration>标签里添加:

1 <property> 2 <name>dfs.namenode.name.dir</name> 3 <value>file:/usr/local/hadoop/hdfs/name</value> 4 </property>

6、cp mapred-site.xml.template mapred-site.xml改个名字,然后进入修改 ,在<configuration>标签里添加:

<name>mapreduce.framwork.name</name>

<value>yarn</value>

7、vi yarn-site.xml 进入添加配置:

1 <configuration> 2 3 <!-- Site specific YARN configuration properties --> 4 <property> 5 <name>yarn.nodemanager.aux-services</name> 6 <value>mapreduce_shuffle</value> 7 </property> 8 9 </configuration>

8、cd /usr/local/hadoop/hadoop-2.6.4/bin进入bin目录

9、./hdfs namenode -format 重置

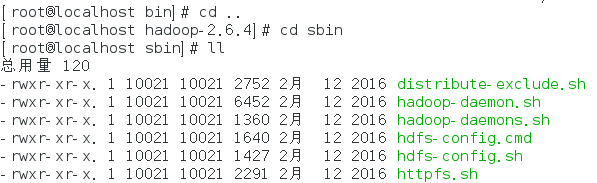

10、cd .. ; cd sbin

11、./start-all.sh 开启服务

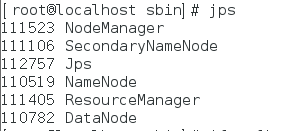

12、jps

此时安装完成。

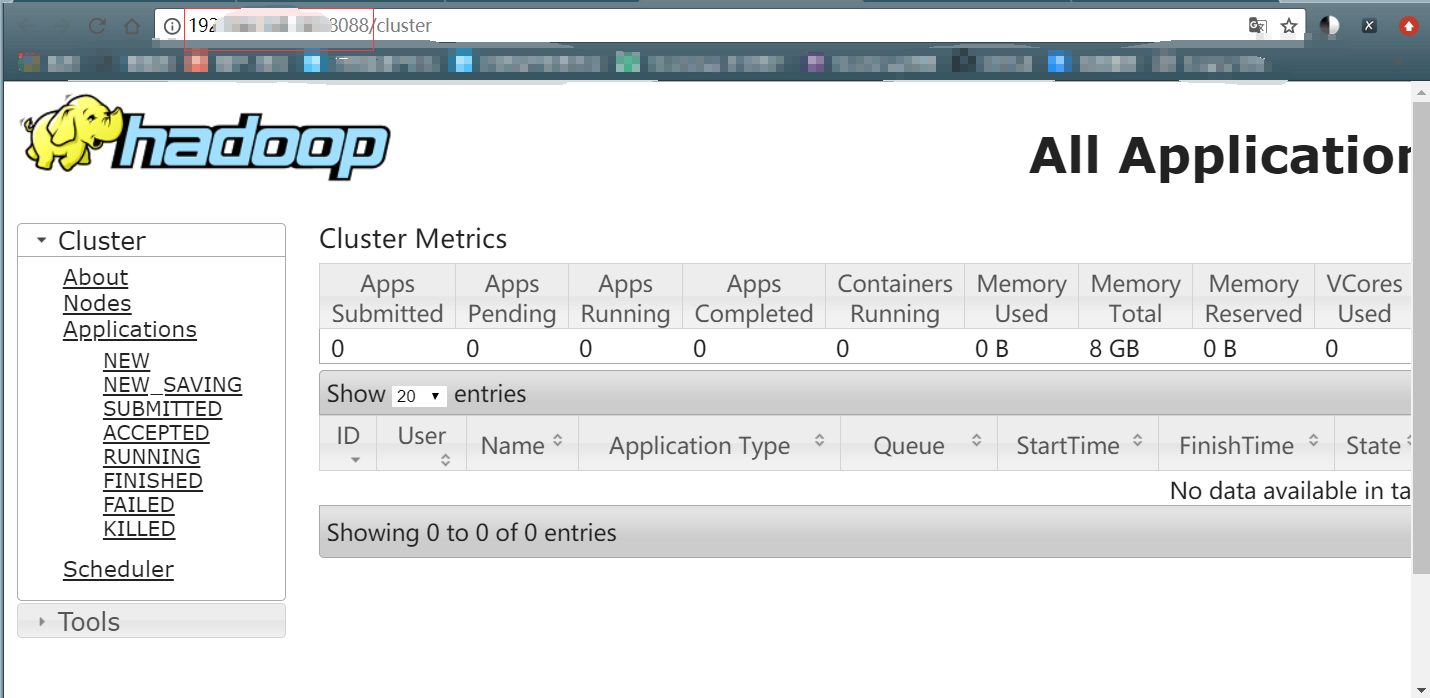

在你的Windows浏览器访问hadoop,如:196.6501.80:8088

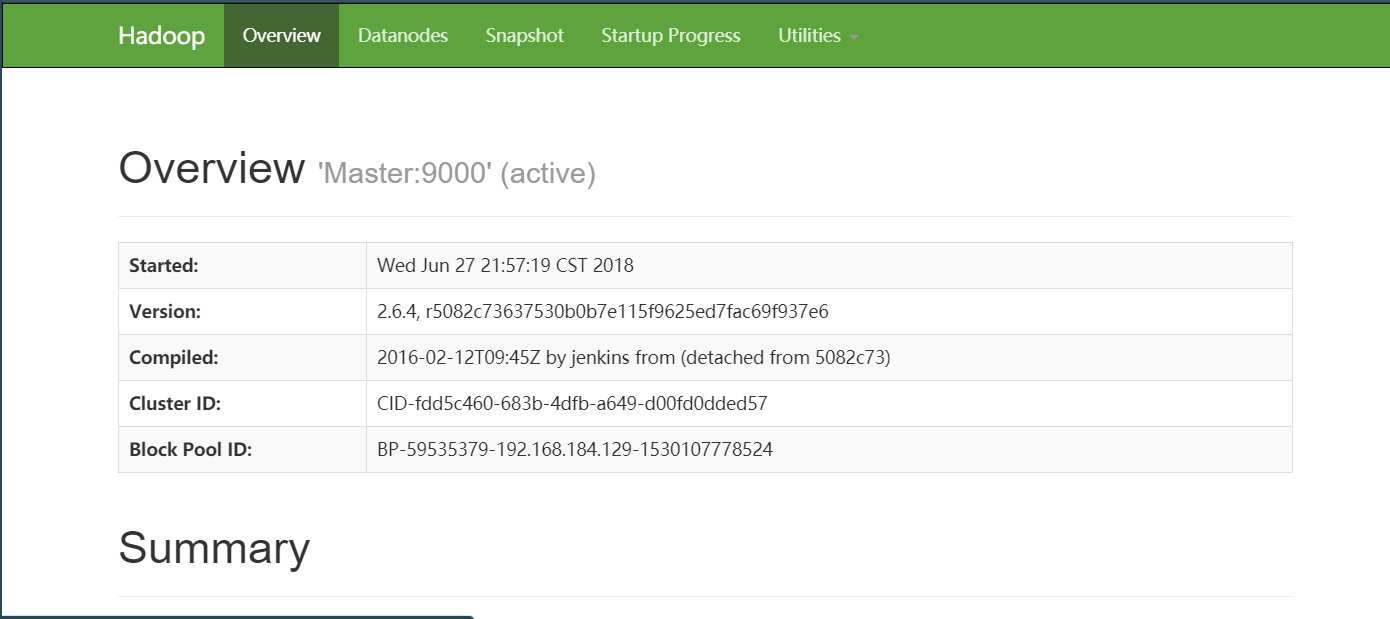

输入端口50070:

你输入IP访问时,会显示防火墙开启的问题,在终端执行下面的命令就可以得到上面的结果:

firewall-cmd --state

systemctl stop firewalld.service