背景介绍

最近实验室在搞基于微透镜阵列的光场相机,很时髦的玩意,可以先拍照然后对焦,可以说重新定义了摄影,但很可惜,国外已经研究的比较成熟了,基本理论,也就是光场技术,在1996年由斯坦福的Marc Levoy等人提出,采集光场的手段主要有两种,一种是通过微透镜阵列,这样不但能记录光线的强度信息,还能记录光线的角度信息,另外一种是通过相机阵列技术。前者已经由RenNG成功商业化成Lytro光场相机,后者嘛,还停留在实验室阶段→_→,不过由相机阵列引发出的合成口径成像技术,很是牛逼,号称能看清楚被遮挡物体的表面,于是呢,我就调研了一下多相机阵列的国内外研究的情况。下面的这些内容基本上是我写给老板的调研报告,为了便于大家理解,我放了很多图,但毕竟是综述类的报告,有点文绉绉的说教语气,木有办法,凑合着看呗~

我看相机阵列

多相机阵列(Camera Arrays)利用不同空间位置的多个相机来采集不同视角的照片。斯坦福大学的Bennett Wilburn等人[1]用廉价的相机搭建一个高性能的相机阵列(图1)。这个系统使用常规的MPEG视频压缩标准以及IEEE1394通信标准,使得100台CMOS相机协同工作,而所有相机所产生的数据仅需要4台普通的PC处理即可。

图 1 斯坦福大学搭建的高性能相机阵列

多相机阵列各子相机之间的距离不同,整个相机阵列就有不同的用途。当所有的子相机之间的距离比较小时,也就是相机紧挨着放在一起,这时整个相机阵列可以看作一个单中心投影相机(Single-Center-of-Projection Camera)。这时整个相机阵列可以用来产生超分辨率、高信噪比、高动态范围的照片。从图3中可以看到,通过对不同子相机采用不同的曝光时间,我们得到了比所有相机都采用相同曝光时间(图2)更加广的动态范围[1]。另外,当监控相机在夜晚工作时,由于光线不足,相机往往需要使用大光圈,然后大光圈带来的一个弊端是使图片的景深急剧减小,而相机阵列可以克服大光圈带来景深小的问题[2](图4-图6)。

| 图 2所有相机相同曝光时间 | 图 3所有相机设置不同曝光时间 |

| 图 4对焦点在近处 | 图 5对焦点在远处 | 图 6大景深的合成图像 |

当所有的子相机之间的距离都很大时,这时整个相机阵列可以看成是一个多中心投影相机(Multiple-Center-of-Projection Camera),整个相机阵列所产生的数据就叫做光场,通过这些数据,我们可以得到物体的多视角信息,为其3D重建提供重要信息。除此之外,可以利用图片中的多视角信息,构建全景照片[3,4],如图7所示。

图 7多视角全景图片

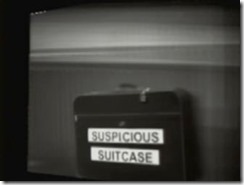

当所有的子相机之间的距离处于中等尺度时,这时整个相机阵列可以看作是一个拥有合成孔径(Synthetic Aperture)的相机:每个子相机作为一个子部分进行采样,多个相机的组合可以等效为一个具有更大光圈数的大孔径相机。这个相机能透过树枝或者人群看到其后面被遮挡物体的表面[5]。在火车站等人流密集的地方,这项技术可以用来跟踪定位可疑的犯罪分子[6]。图8是用普通的相机拍的照片,在这些树枝后面有一个雕像,在雕像后面后一些人,用普通相机无法透过树枝看到其后面的物体,而合成孔径的相机可以做到(图9)。在人群密集的场所,被跟踪的物体容易被遮挡,用合成孔径相机进行数字重对焦,能使前景的人群被严重的虚化,从而可以轻松透过人群监控其一举一动(图10-图11)。

| 图 8普通相机拍摄的照片 | 图 9合成口径相机拍摄 |

| 图 10被人群遮挡的对象 | 图 11合成口径相机成像结果 |

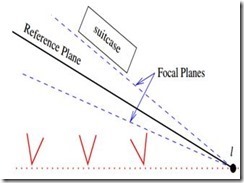

当被监控的物体所在的平面与相机阵列所在的平面不平行时,用合成孔径相机去监控物体,可能会导致计算量过大以及被监控物体不同部分不能同时清晰呈现的问题,幸运的是,Vaibhav Vaish等人[6]发现,当不同对焦平面交于一条直线的时候(图14),可以完美的解决这个问题(图12-图15)。Vaibhav Vaish等人[7]针对多视角的特点设计了多种重构图像的算法,分别基于对焦(Focus)特征、中值(Median)特征、立体(stereo)特征、熵(Entropy)特征、立体像素着色(Voxel Coloring)特征(图16-图22),周志良博士根据广场强度在遮拦物所对应的空间位置和投影方向上具有强相似性和小方差的特性[8],进一步提高了重构算法的性能(图23)。

| 图 12使用平面视差(plane parallax)技术不能同时使不在同一个焦平面上的物体清晰成像,图中对焦在左边 | 图 13使用平面视差(plane parallax)技术不能同时使不在同一个焦平面上的物体清晰成像,图中对焦在右边 |

| 图 14当所有对焦平面都交于一条直线且物体所在平面平行其中一个对焦平面使,物体表面可以清晰成像 | 图 15使用剪切变形分解(Shear-W arp F actorization)技术的成像结果 |

| 图 16被植物遮挡的物体 | 图 17移除植物后理想的被遮挡表面 |

| 图 18基于熵特征的重构 | 图 19基于对焦特性的重构 | 图 20基于中值特性的重构 |

| 图 21基于立体的重构 | 图 22基于立体像素的重构 | 图 23基于光场强度方差的重构 |

当然,当被遮挡物体被严重遮挡的时候,由于每个子相机采集的信息太少,所以最终得不到理想的被遮挡物体的表面,为了解决这个问题,结合现有的成熟的城市监控系统,Tao Yang等人[9]提出了一种新型的实时混合合成口径成像监控技术,它由两组相机阵列组成,一组从上而下监控,主要负责合成口径追踪,另外一组由一组横向排列的相机组成,主要负责合成口径成像(图24)。用这种方法,即使在物体被严重遮挡的情况下,仍然能依靠前一组的相机进行目标追踪。

图 24混合合成孔径成像系统

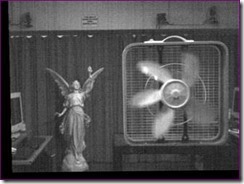

此外,整个相机阵列可以划分成多个子阵列,通过对不同子阵列设置不同的曝光时间,可以实现时间和空间上的孔径合成,从而用来解决低光环境下小光圈拍高速运动物体导致的模糊问题[1]。如图25所示,用小光圈长时间曝光的方法得到的图片虽然景深大,但是风扇的叶片由于长时间曝光而模糊了,如果通过缩短快门时间,叶片清晰的代价是整张图片曝光不足(图26),虽然可以通过调整对比度的方式来增强图片(图27),但是同时也产生噪点,另一方面,通过大光圈的方法拍摄(图28),又会使景深太小,导致背景物体不清晰,所以,如何确定光圈大小、曝光时间以及快门时间等参数是件很困难的事,幸运的是,采用相机阵列的混合型合成口径成像(Hybrid Synthetic Aperture Imaging),通过等效口径尺寸和曝光时间的控制,能够获得大景深且高速运动部分清晰的高信噪比图像(图29)。

| 图 25小光圈长时间曝光导致的运动模糊 | 图 26缩短曝光时间导致图片整体曝光不足 |

| 图 27提升对比度导致产生噪点 | 图 28大光圈拍摄导致景深小 |

图 29混合型合成口径成像结果,保证图片曝光正常的情况下,景深范围大,同时也减小高速运动物体产生的模糊

综上所述,相机阵列通过利用不同视角的信息,以及更加广阔的视场范围,使其在合成孔径成像技术的焦点选择以及景深调节上有着先天的优势,同时,其高可拓展性以及低成本的优势,非常适合景物的识别以及追踪,已成为隐藏目标的检测与追踪的重要手段。

写在最后

总体来说,多相机阵列技术,在国外,斯坦福大学做的工作比较多,很前沿的东西都是那边出来的。国内的话,西北工业大学,对,自己的母校,做的还是不错。作为博士生课题的话,还是很适合的,新方向,容易出文章。可惜我对它不是太感兴趣,所以跟老板商量了一下,换了一个方向,主要是偏向工程的,我感觉这样才能发挥出我的优势,嘿嘿,希望能给有志在此方向发展的朋友点启发哈,发论文了,求挂名,O(∩_∩)O哈哈~

[2] Haeberli, P., A multifocus method for controlling depth of field. 1994.

[8] 周志良, 光场成像技术研究. 2012, 中国科学技术大学.

![clip_image002_thumb[1] clip_image002_thumb[1]](http://images0.cnblogs.com/blog/636084/201405/221538035598480.jpg)

![clip_image014_thumb[1] clip_image014_thumb[1]](http://images0.cnblogs.com/blog/636084/201405/221538474025718.jpg)

![clip_image046_thumb[1] clip_image046_thumb[1]](http://images0.cnblogs.com/blog/636084/201405/221540499344085.jpg)

![clip_image056_thumb[1] clip_image056_thumb[1]](http://images0.cnblogs.com/blog/636084/201405/221541271847172.jpg)