Ubuntu 安装Spark出现的问题及解决

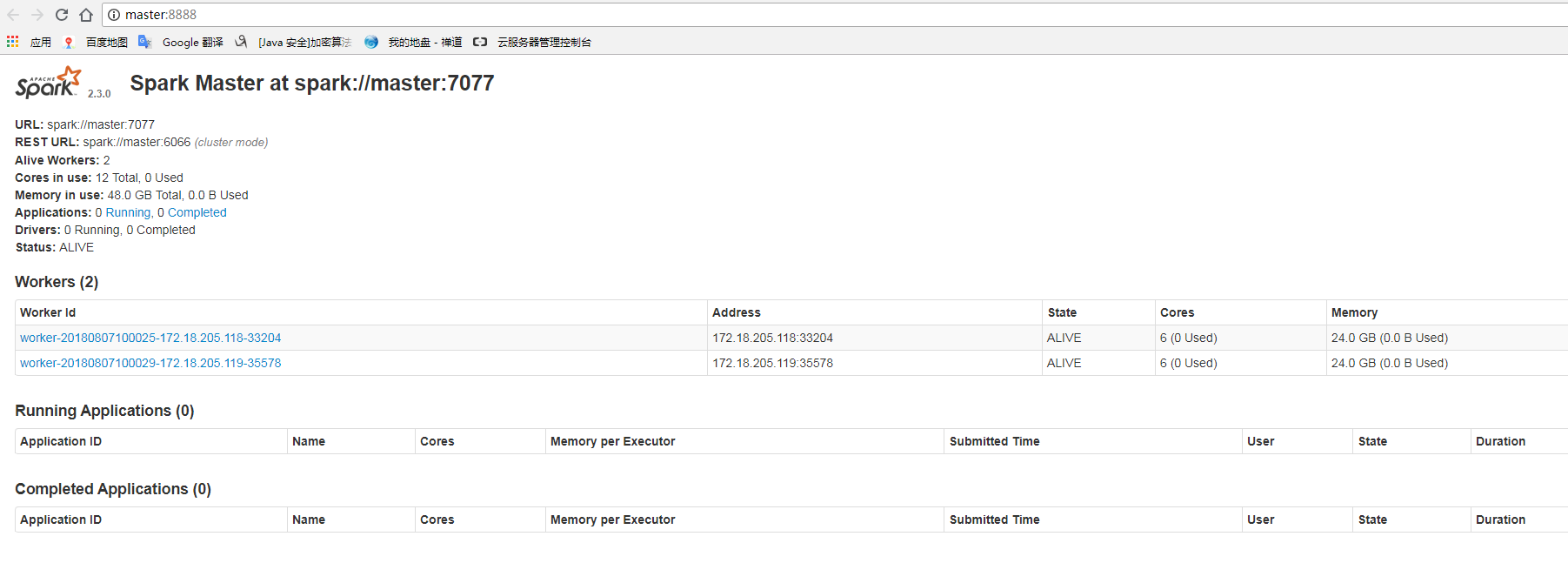

最近在搭建Hadoop集群环境和Spark集群环境,出现的问题可能不太复杂,纯粹记录安装步骤和问题解决办法。

集群环境使用的是(2台)阿里云主机,操作系统是Ubuntu 16.04.9版本

运行环境

Linux 操作系统:Ubuntu 16.04.9

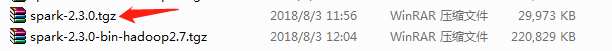

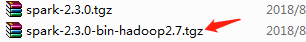

Spark 安装版本(红色箭头的是下图安装报错的版本)

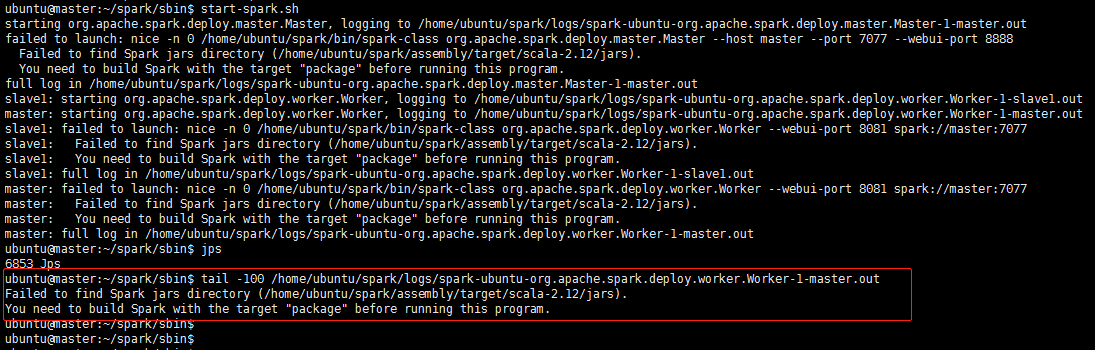

报错信息:

原因:没有用对Spark安装包,应该选择Hadoop编译后的安装包。在http://spark.apache.org/官网选择Pre-build对应hadoop版本的Spark安装包

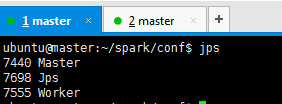

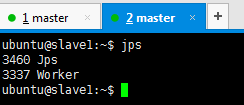

环境搭建

1、修改集群配置文件

mv /spark/conf/slaves.template /spark/conf/slaves

vi /spark/conf/slaves

添加slave主机IP/hostname

2、修改Master节点运行配置

mv /spark/conf/spark-env.sh.template /spark/conf/spark-env.sh

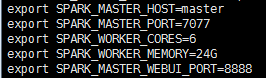

如下配置项:

Spark环境变量配置

1、配置步骤

省略...

2、修改Spark 启动脚本(因为这个和Hadoop启动脚本名称冲突)

mv /spark/sbin/start-all.sh /spark/sbin/start-spark.sh

mv /spark/sbin/stop-all.sh /spark/sbin/stop-spark.sh