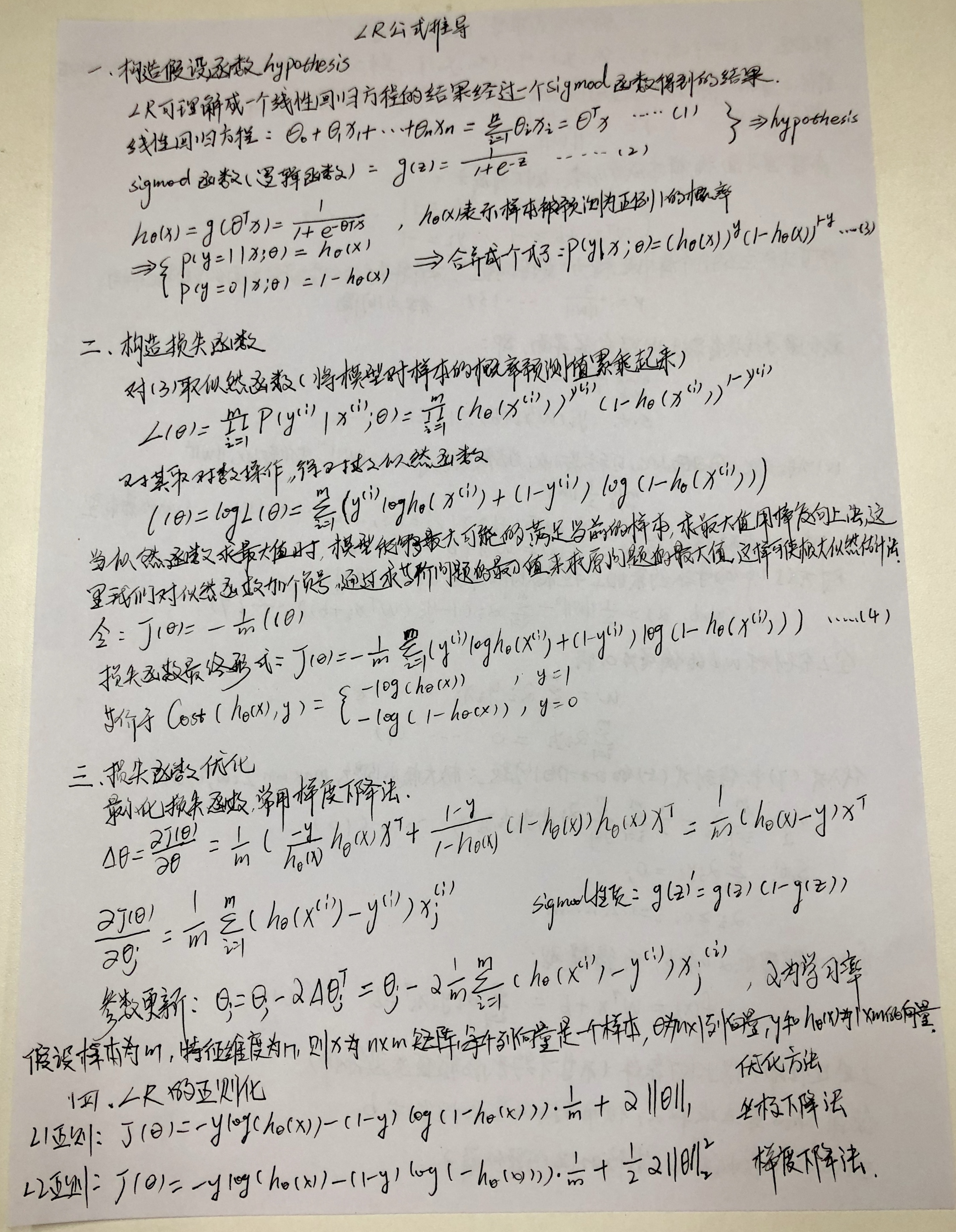

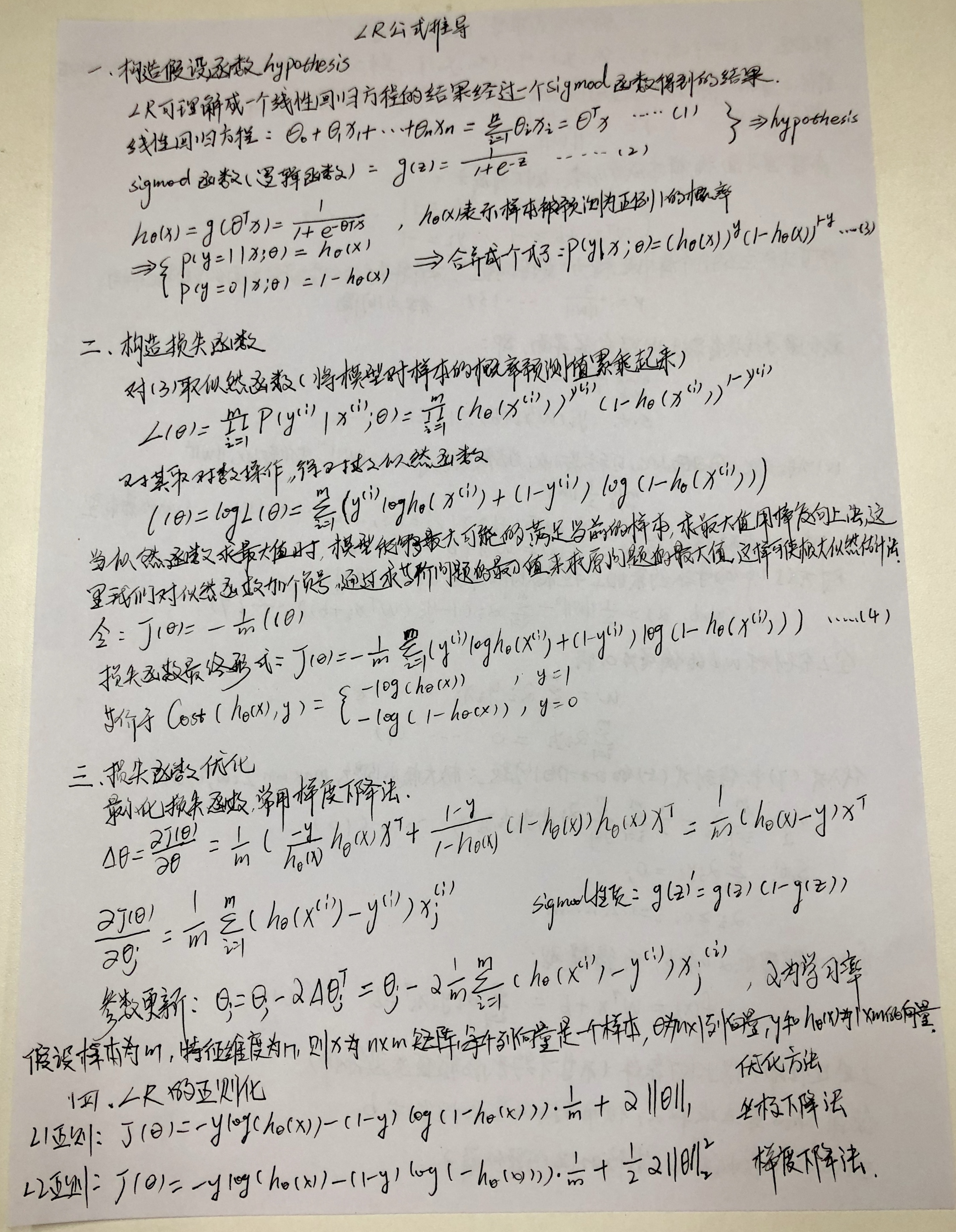

LR:

LR的目标是最小化模型分布和经验分布之间的交叉熵,LR基于概率理论中的极大似然估计。首先假设样本为0或者1的概率可以用sigmoid函数来表示,然后通过极大似然估计的方法估计出参数的值,即让模型产生的分布P(Y|X)尽可能接近训练数据的分布。

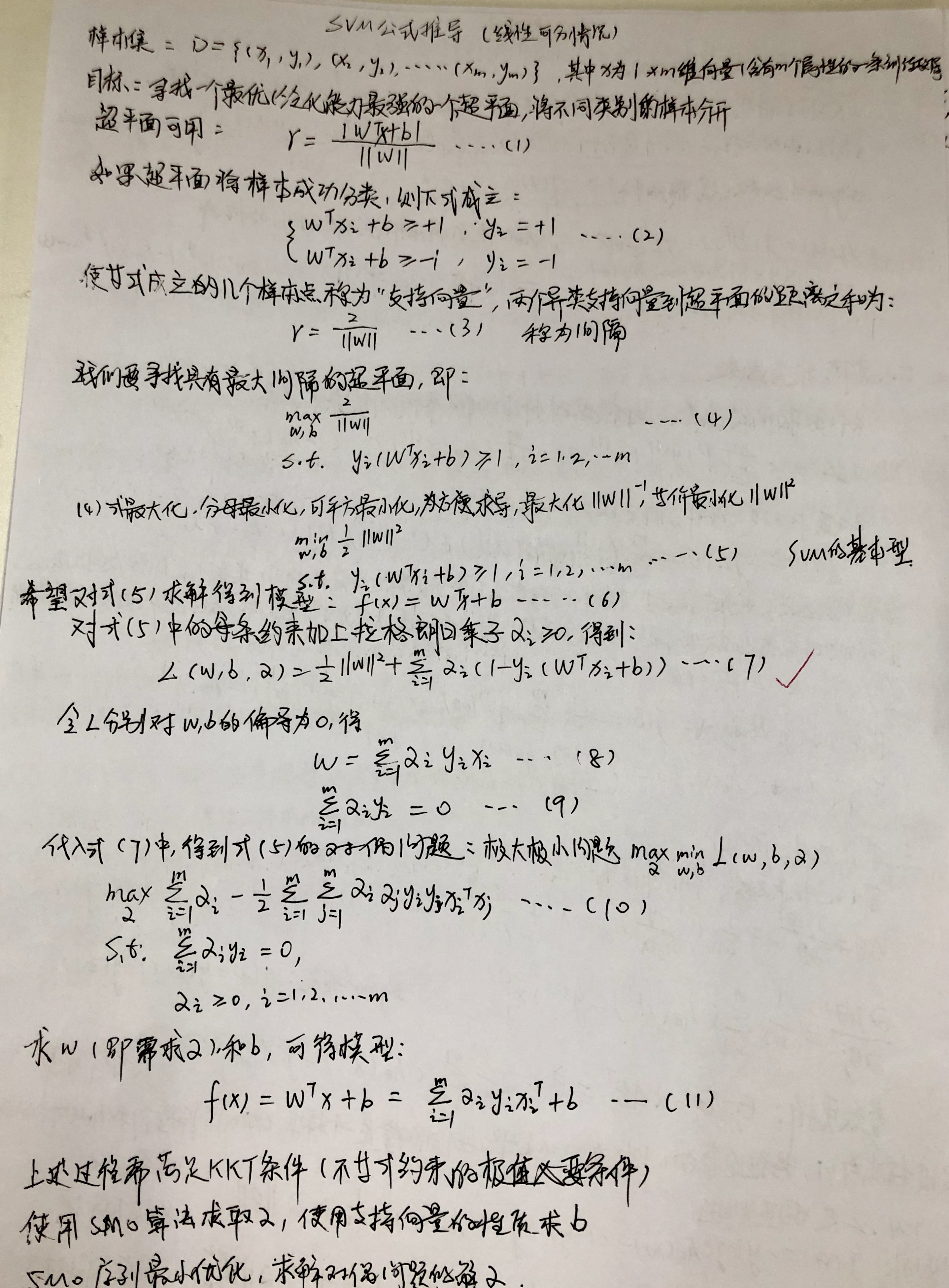

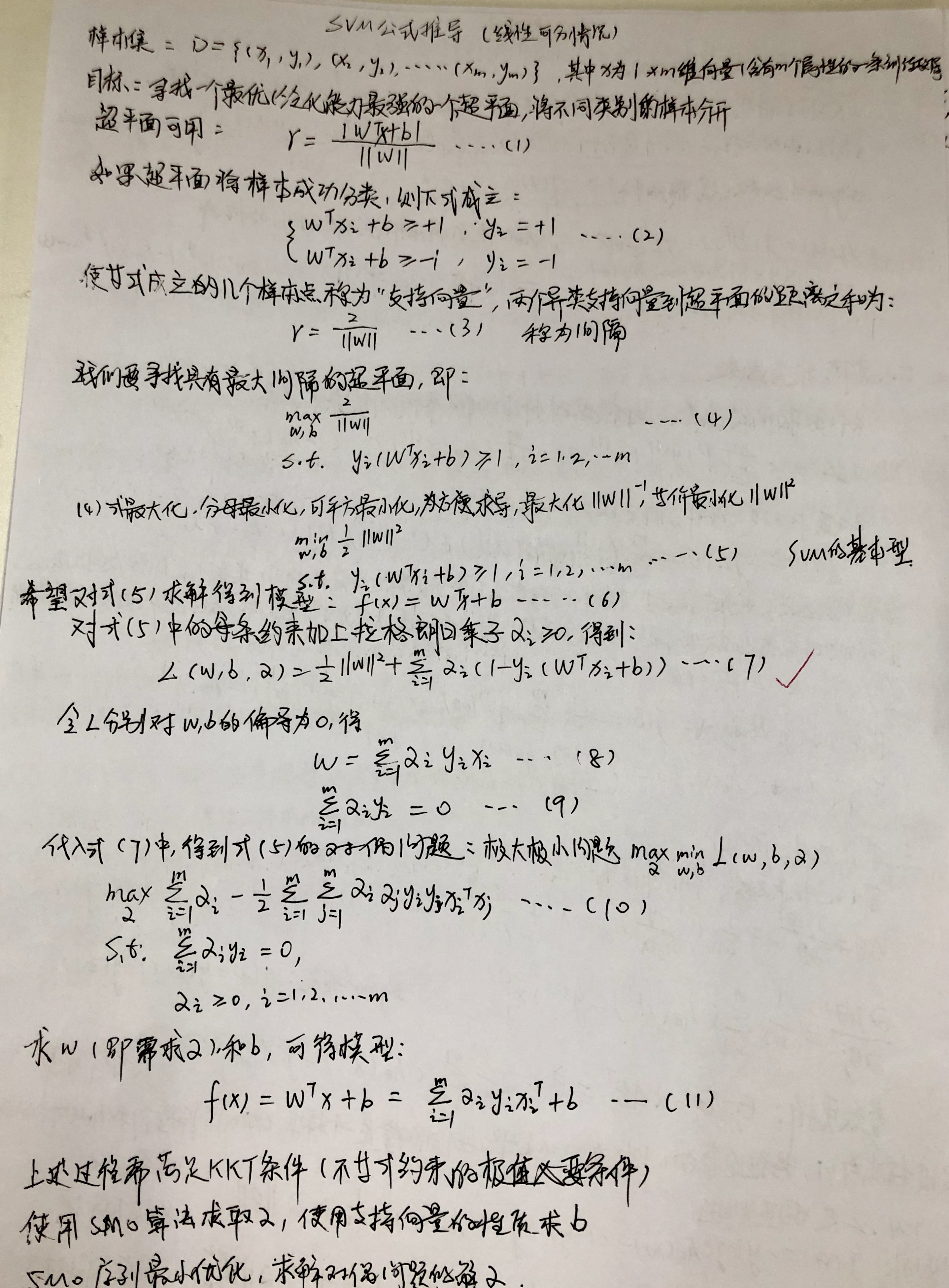

SVM:

SVM的目标是最大化分类间隔(硬SVM),或者最大化 [分类间隔—a*分错的样本数量](软SVM),SVM基于几何间隔最大化原理,认为几何间隔最大的分类面为最优分类面 。

LR:

LR的目标是最小化模型分布和经验分布之间的交叉熵,LR基于概率理论中的极大似然估计。首先假设样本为0或者1的概率可以用sigmoid函数来表示,然后通过极大似然估计的方法估计出参数的值,即让模型产生的分布P(Y|X)尽可能接近训练数据的分布。

SVM:

SVM的目标是最大化分类间隔(硬SVM),或者最大化 [分类间隔—a*分错的样本数量](软SVM),SVM基于几何间隔最大化原理,认为几何间隔最大的分类面为最优分类面 。