Projects' Models

神经网络的基本概念

如无特殊说明, 按以下计:

- 线性层(L)为:(h=X*W+b)

- 全连接层(FC)为: 线性层L+ReLU层

- Softmax层(S)为:(Softmax(x_{i}) = frac{e^{x_{i}}}{sum_{i}e^{x_{i}}})

- 卷积函数(conv)为:(h = conv2d(X,W) + b)

- 卷积层(CONV)为:卷积函数+ReLU+池化

Tricks

- Dropout手段(Drop)为:每次训练随机去除。测试时完全保留。可防止过拟合。

- 数据增强: 不影响标签的前提下,对原始数据作 平移,旋转,翻转,裁剪,缩放,颜色变化,噪声等。可防止过拟合,提高泛化能力。

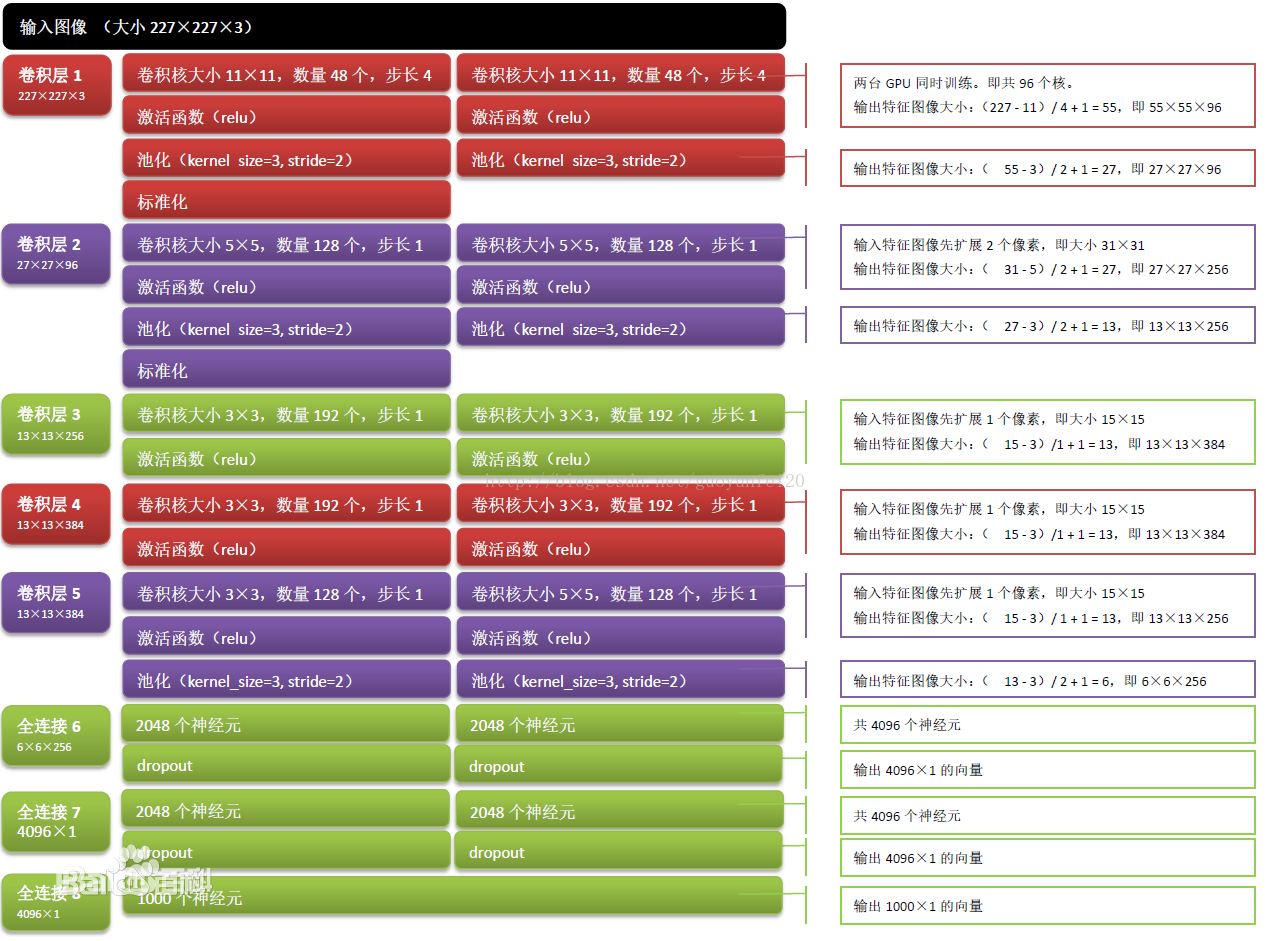

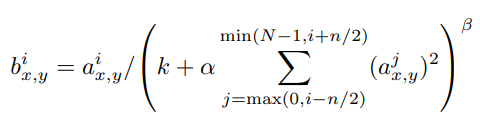

- 局部响应归一化层(LRN层)为(现有模型大多不再采用,可能是伪命题,只有AlexNet使用):

[入门]两个数据集模型实例

| No. | Dataset | Index x [dimn],labelDim | Model | LossFunc | Accuracy |

|---|---|---|---|---|---|

| 1 | MNIST | 55000x28x28,10 | L+S | crossEntropy | 91.85% |

| 2 | MNIST | 55000x28x28,10 | CONV1+CONV2+FC1+Drop+L | softmax_crossEntropy | 99% |

| 3 | CIFAR-10 | 50000x3x32x32,10 | (conv2+pool+BN+ReLU)2+(conv3+pool+BN+ReLU)3+(L+Drop+ReLU)*2+L | softmax_crossEntropy | 85% |

| 4 | CIFAR-10 | 50000x3x32x32,10 | CONV1+LRN1+CONV2+LRN2+FC1+FC2 | softmax_crossEntropy | 86.3% |

ImageNet数据集模型

AlexNet模型