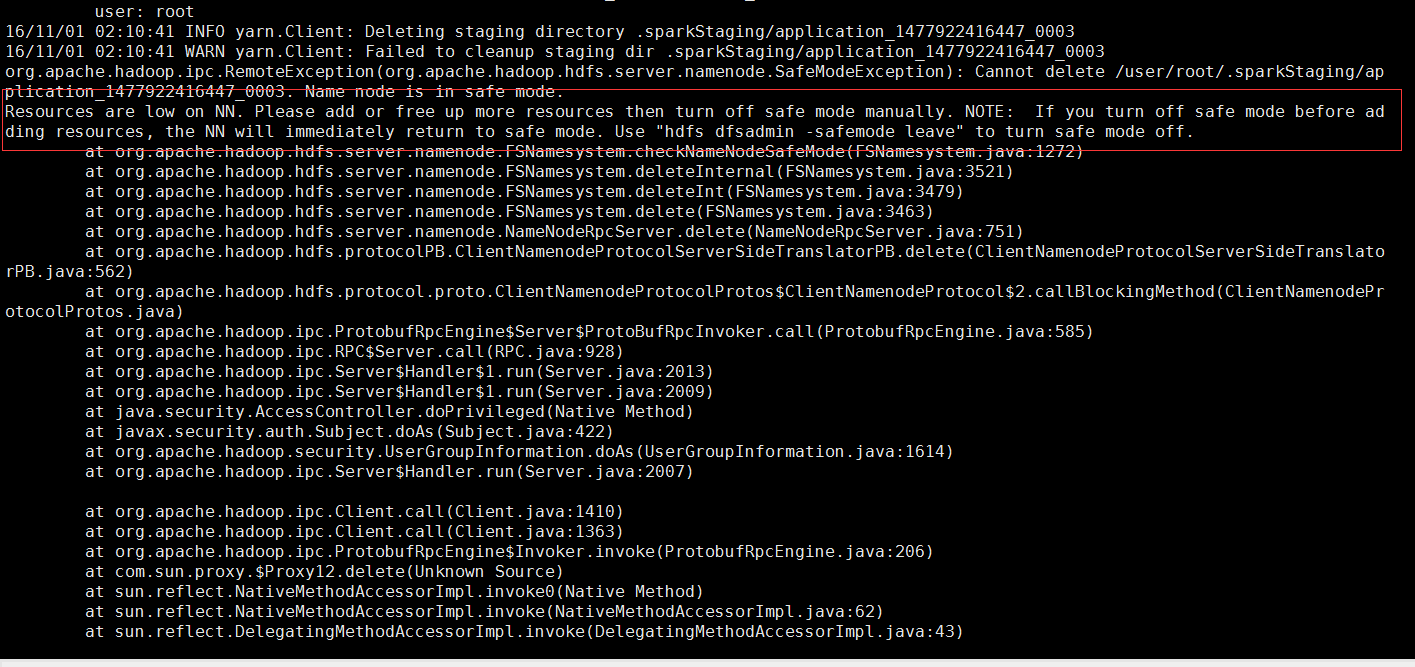

提交spark应用到yarn集群上的时候在跑一段时间就会出现这个报错:

根据上面的报错原因分析是因为集群资源不够,集群的自我保护机制使hdfs处于安全模式,然后我用”hdfs dfsadmin -safemode leave“命令让集群恢复到可用模式但是在提交到集群时还是会报错同样的错误

然后就查找资料说的是节点空间不足,然后就用 df -hl命令查看集群空间的使用情况

看到上面的使用情况资源已经使用100%了

然后在使用du -sh /* 看看是拿些大文件占用了空间

然后把这些占用空间大的文件移动到别的地方然后重新提交任务,到此错误完美解决

//安全模式的开启和关闭

hdfs dfsadmin -safemode get

hdfs dfsadmin -safemode leave