Gerapy 基于Scrapy、Scrapyd、Scrapyd-Client、Scrapyd-API、Django和Vue.js的分布式爬虫管理框架

目录

1、官网: https://pypi.org/project/gerapy/

2、基本知识点

3、创建操作

4、 视频资料

项目简介

Gerapy

基于 Scrapy、Scrapyd、Scrapyd-Client、Scrapyd-API、Django 和 Vue.js 的分布式爬虫管理框架。

文档

文档可在https://docs.gerapy.com/和https://github.com/Gerapy/Docs在线获得。

支持

Gerapy 基于 Python 3.x 开发。以后可能会支持 Python 2.x。

用法

通过pip安装Gerapy:

pip3 install gerapy

安装完成后,您需要执行以下这些操作来运行 Gerapy 服务器:

如果您已成功安装 Gerapy,则可以使用命令gerapy. 如果没有,请检查安装。

首先使用此命令初始化工作区:

初始化

现在您将获得一个名为gerapy. 您也可以通过以下命令指定工作区的名称:

gerapy init <workspace>

然后cd到这个文件夹,并运行这个命令来初始化数据库:

cd gerapy

迁移

接下来你需要通过这个命令创建一个超级用户:

gerapy createsuperuser

然后你可以通过这个命令运行服务器:

gerapy 运行服务器

然后就可以访问http://localhost:8000来享受了。您也可以访问http://localhost:8000/admin以获取管理员管理后端。

如果你想在公共场合运行 Gerapy,只需像这样运行:

gerapy runserver 0.0.0.0:8000

然后它将使用公共主机和端口 8000 运行。

在 Gerapy 中,您可以创建一个可配置的项目,然后自动配置和生成 Scrapy 的代码。但是这个模块不稳定,我们正在尝试改进它。

您也可以将 Scrapy 项目拖到projects文件夹中。然后刷新web,它会出现在Project Index Page 中并且变为unconfigurable,但是你可以通过web 页面编辑这个项目。

至于部署,您可以移至部署页面。首先您需要在Client Index Page中构建您的项目并添加客户端,然后您只需单击按钮即可部署项目。

部署完成后,您可以在监控页面管理作业。

docker

只需运行此命令:

docker run -d -v ~/gerapy:/app/gerapy -p 8000:8000 germey/gerapy

然后它会在8000端口运行。您可以使用临时管理员帐户(用户名:admin,密码:admin)登录。并请稍后更改密码以确保安全。

命令用法:

docker run -d -v <workspace>:/app/gerapy -p <public_port>:<container_port> germey/gerapy

请指定您的工作空间以安装 Gerapy 工作空间-v <workspace>:/app/gerapy并指定服务器端口-p <public_port>:<container_port>。

如果您通过Docker运行Gerapy,您可以访问Gerapy网站例如http://localhost:8000并享受它,无需做其他初始化的事情。

待办事项列表

- <input type="checkbox" checked="" disabled="" /> 添加带预览网站的Spider 可视化配置

- <input type="checkbox" checked="" disabled="" /> 添加 Scrapyd 身份验证管理

- <input type="checkbox" checked="" disabled="" /> 添加Gerapy Auth管理

- <input type="checkbox" checked="" disabled="" /> 添加定时任务调度器

- <input type="checkbox" disabled="" /> 添加 Scrapy 的可视化配置

- <input type="checkbox" disabled="" /> 添加网页智能分析

沟通

操作步骤:

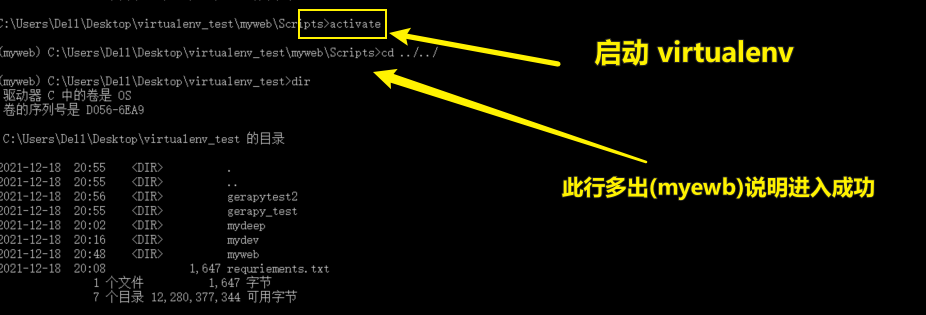

1)进入virtualenv运行环境

virtualenv通过创建一个虚拟化的python运行环境

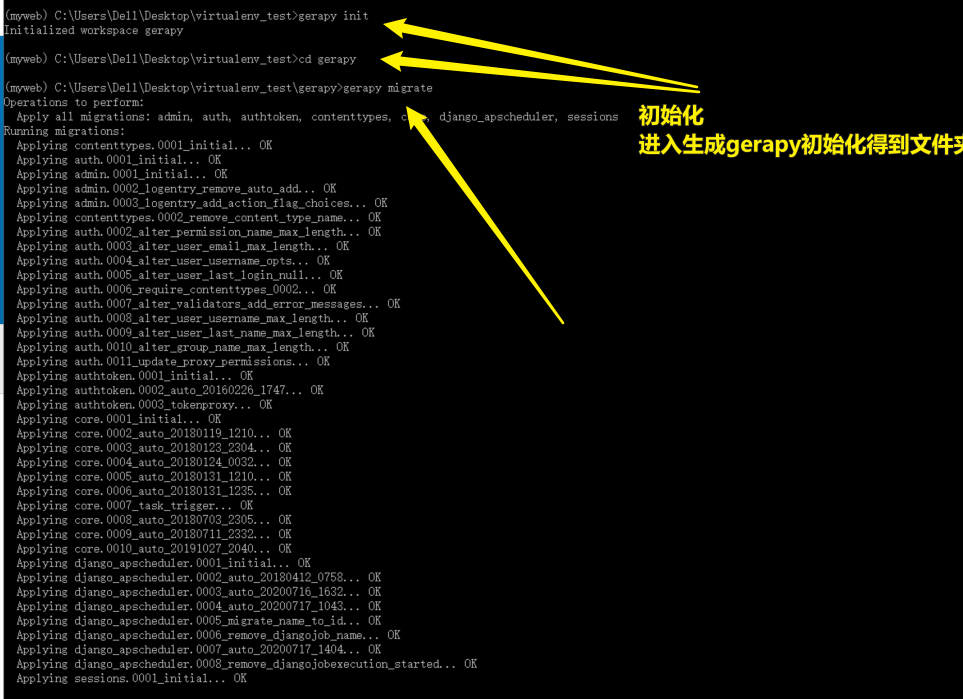

2)gerapy init 初妈化

进过如上可以运行

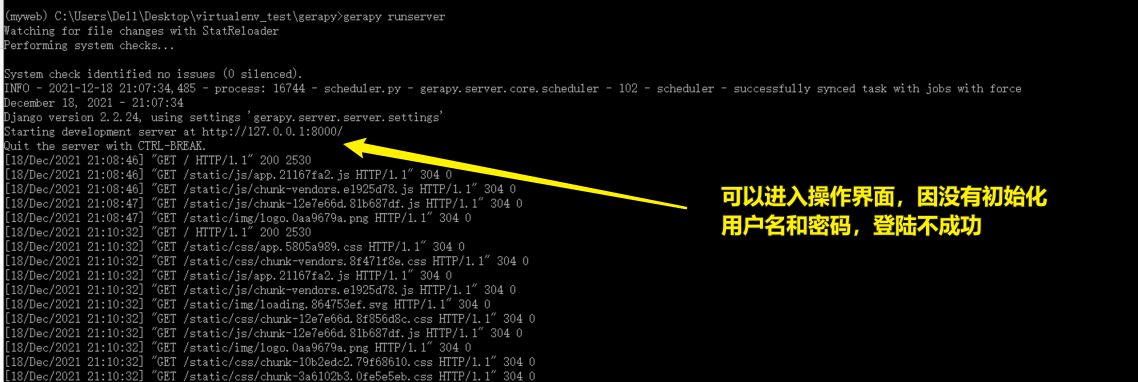

3)gerapy runserver

如上可以进入后台登陆界面,但用户名和密码因没有初始化,无法登陆

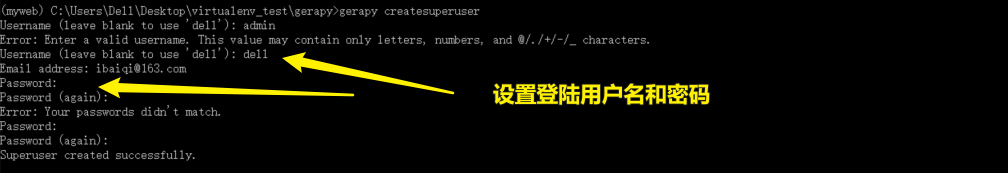

4)别忘记创建用户名和密码

5)Gerapy只是分布式爬虫管理框架,需要启动scrapyd运行后配置进行更多操作.

scrapyd需要单独创建一个接口