先验、后验:原因到结果的论证称为“先验的”,而从结果到原因的论证称为“后验的”。

形象的解释:https://blog.csdn.net/qq_23947237/article/details/78265026

Kullback-Leibler Divergence,即K-L散度,是一种量化两种概率分布P和Q之间差异的方式,又叫相对熵。在概率学和统计学上,我们经常会使用一种更简单的、近似的分布来替代观察数据或太复杂的分布。K-L散度能帮助我们度量使用一个分布来近似另一个分布时所损失的信息。https://www.jianshu.com/p/43318a3dc715?from=timeline&isappinstalled=0

Adam优化算法

https://blog.csdn.net/leadai/article/details/79178787

Leaky ReLUs

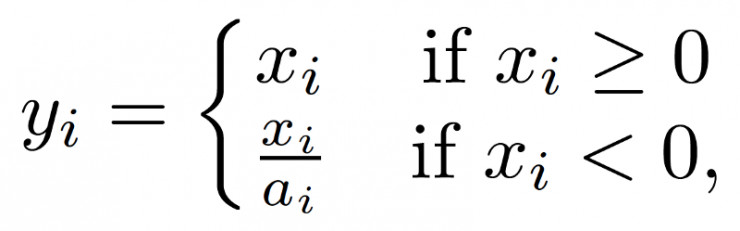

ReLU是将所有的负值都设为零,相反,Leaky ReLU是给所有负值赋予一个非零斜率。Leaky ReLU激活函数是在声学模型(2013)中首次提出的。以数学的方式我们可以表示为:

ai是(1,+∞)区间内的固定参数。

ai是(1,+∞)区间内的固定参数。Batch Normalization BN层 保持分布

推荐的模型结构可视化工具是:Netron

最大池化

resblock 残差结构

tiny-darknet squeezeNet 轻量级框架

RPN anchor

二值交叉熵

one-stage检测算法

mAP

召回率

IOU

准确率(precision)”(你给出的结果有多少是正确的)和“召回率(recall)”(正确的结果有多少被你给出了)

CVPR2017 论文评比