对称矩阵

- 对称矩阵的特征值是实数(越不对称越可能特征值不是实数),并且正交向量是相互正交的。也就是说正交向量构成的矩阵是正交矩阵。

- 在特征值构造对角矩阵这个文章我们提到了矩阵A可以这样分解成正交向量矩阵与特征值构成的对角矩阵的乘积。其中S是特征向量构成的矩阵,而对称矩阵的特征向量都是相互正交。因此S是一个正交矩阵所以,因此.这个在数学叫做谱定理(spectral theorem),谱(spectrum)指的是一个矩阵的特征值集合。来自光谱理论,光分解成几色光而矩阵也被分解成几个特征值。在力学上叫做主轴定理。

- 这个是怎么来的?这个它是由特征值与特征向量之间的关系而得到。,其中是特征值,x是特征向量。然后我们把所有特征x向量放在一个矩阵中这个矩阵叫做S。那么有AS=SΛ,其中S是特征向量矩阵,Λ是对角矩阵对角元素为特征值。然后由于A是对称矩阵所以S是正交矩阵,所以S可逆。于是我们得到了,然后由于正交矩阵有,因此。这就是对称矩阵的奇异值分解。(奇异值和特征值是基本可以等同)

- 与的特征值是一样的。

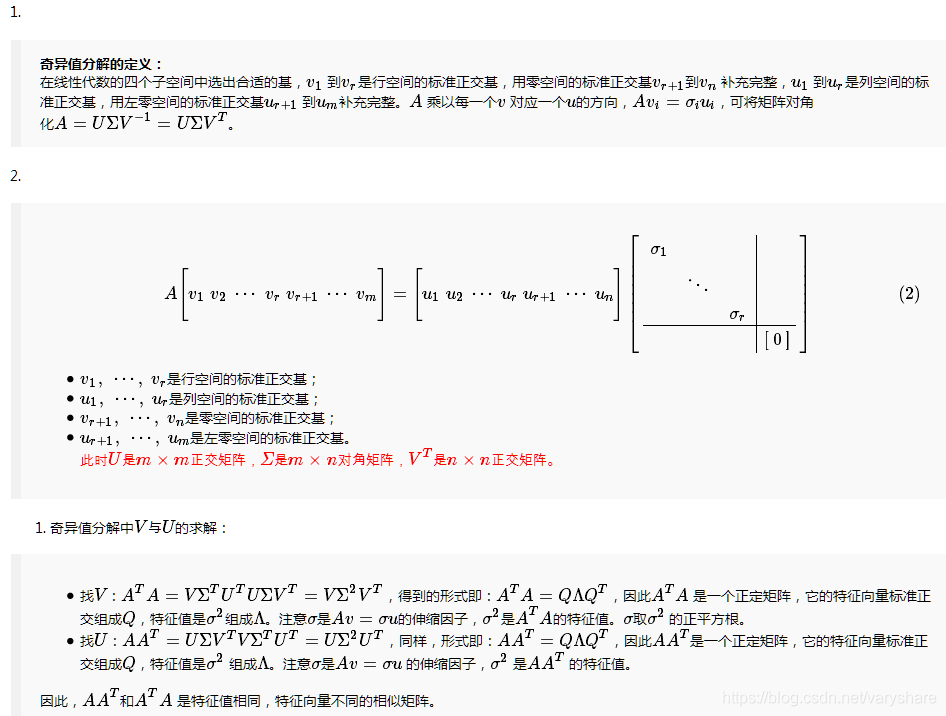

奇异值分解(SVD signal value decomposition)

在机器学习和图形压缩中应用非常广泛。它的动机是。是想把矩阵分解成正交矩阵×对角矩阵×正交矩阵这种形式,用公式表示就是。注意对称矩阵的奇异值分解就是。其中S是特征向量矩阵,Λ是对角矩阵对角元素为特征值。

现在我们只知道对称矩阵的奇异值分解,那么其他非对称矩阵或者更本就不是方阵的矩阵怎么进行分解呢?答:转换为对称矩阵。

比如:矩阵A不是方阵,但是和是方阵并且它是一个对称矩阵。奇异值分解就是利用这两个性质进行分解的。

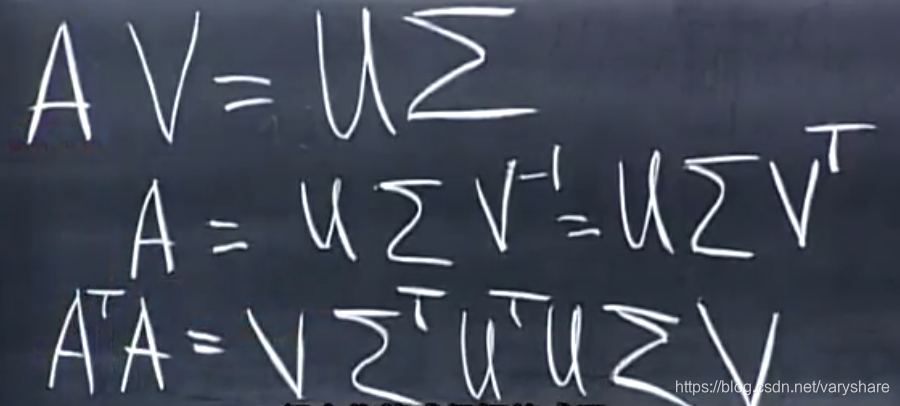

奇异值分解的初衷就是说,假设V是A的行向量的正交基,那么AV就是列向量空间的正交基。假设A的列向量空间的正交基可以表示为U那么根据下面这个图有:

因为U是正交基那么。于是我们消去了U。我们得到了,由于是对称矩阵,那么它可以进行奇异值分解为正交矩阵×对角矩阵×正交矩阵的形式。我们只需要把等于的特征值对角矩阵即可,V等于的特征向量矩阵。

同理可以用消除V,求得U。