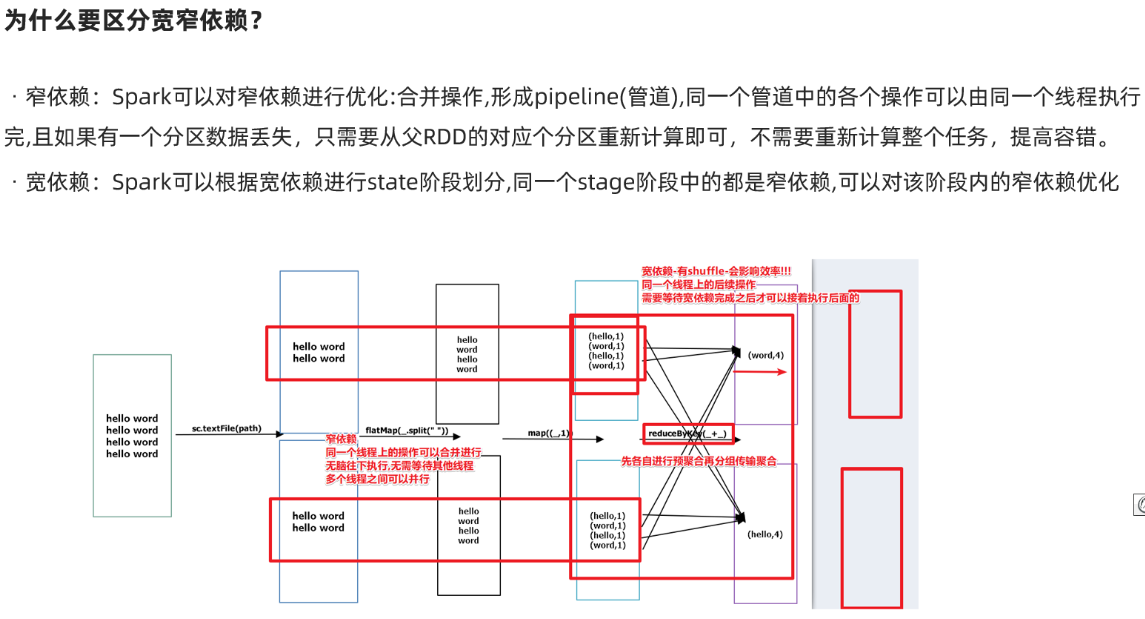

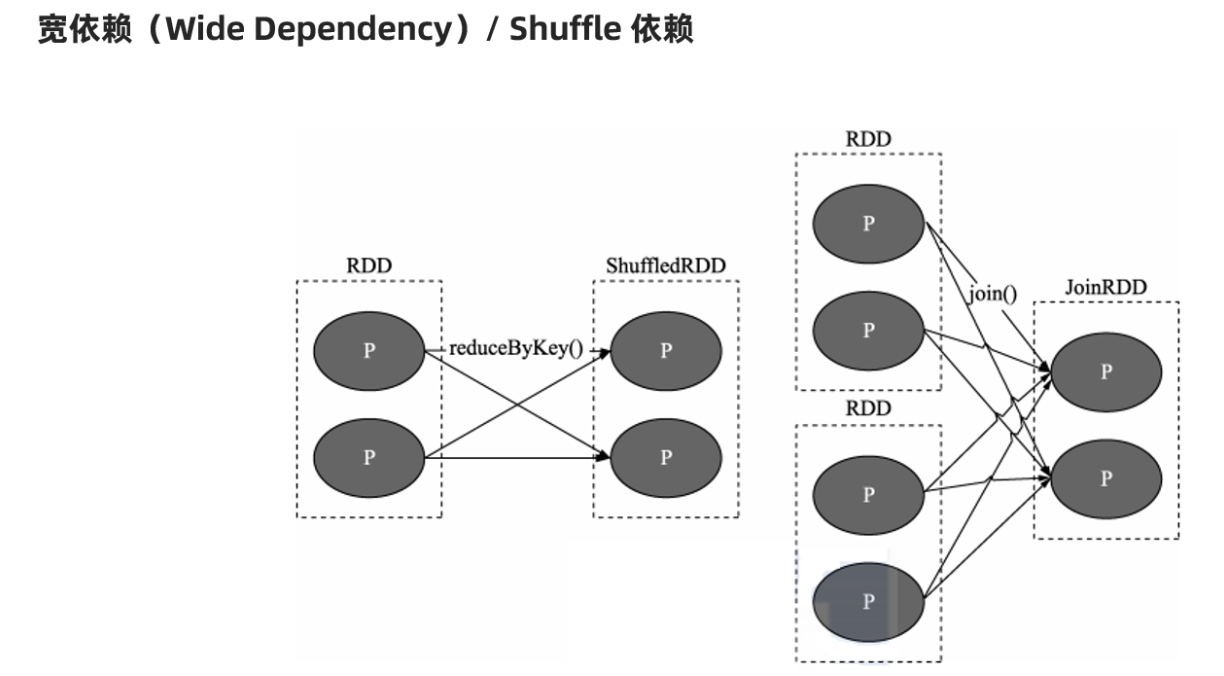

宽依赖:有shuffle

父RDD的一个分区会被子RDD的多个分区所依赖

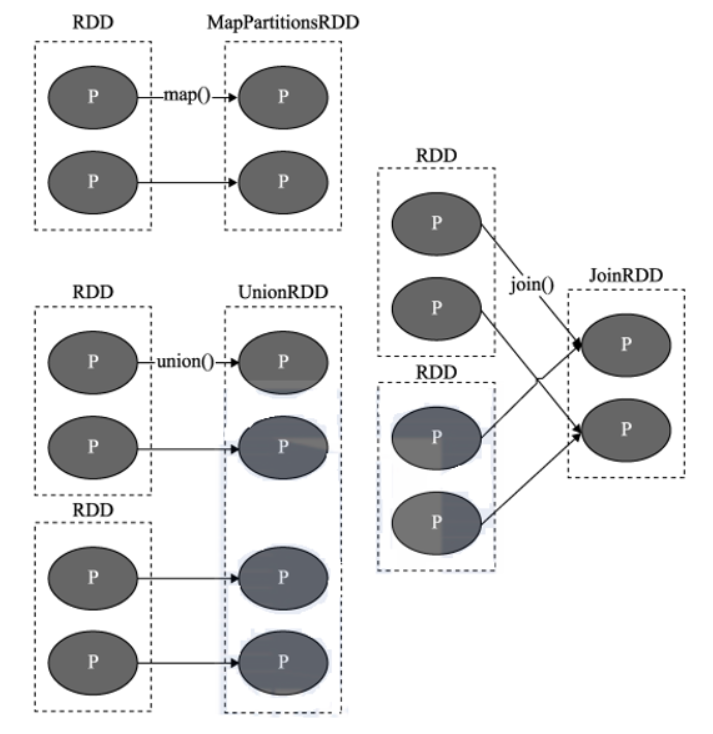

窄依赖:没有shuffle

父RDD的一个分区只会被子RDD的1个分区所依赖

总结:

窄依赖: 并行化+容错

宽依赖: 进行阶段划分(shuffle后的阶段需要等待shuffle前的阶段计算完才能执行)

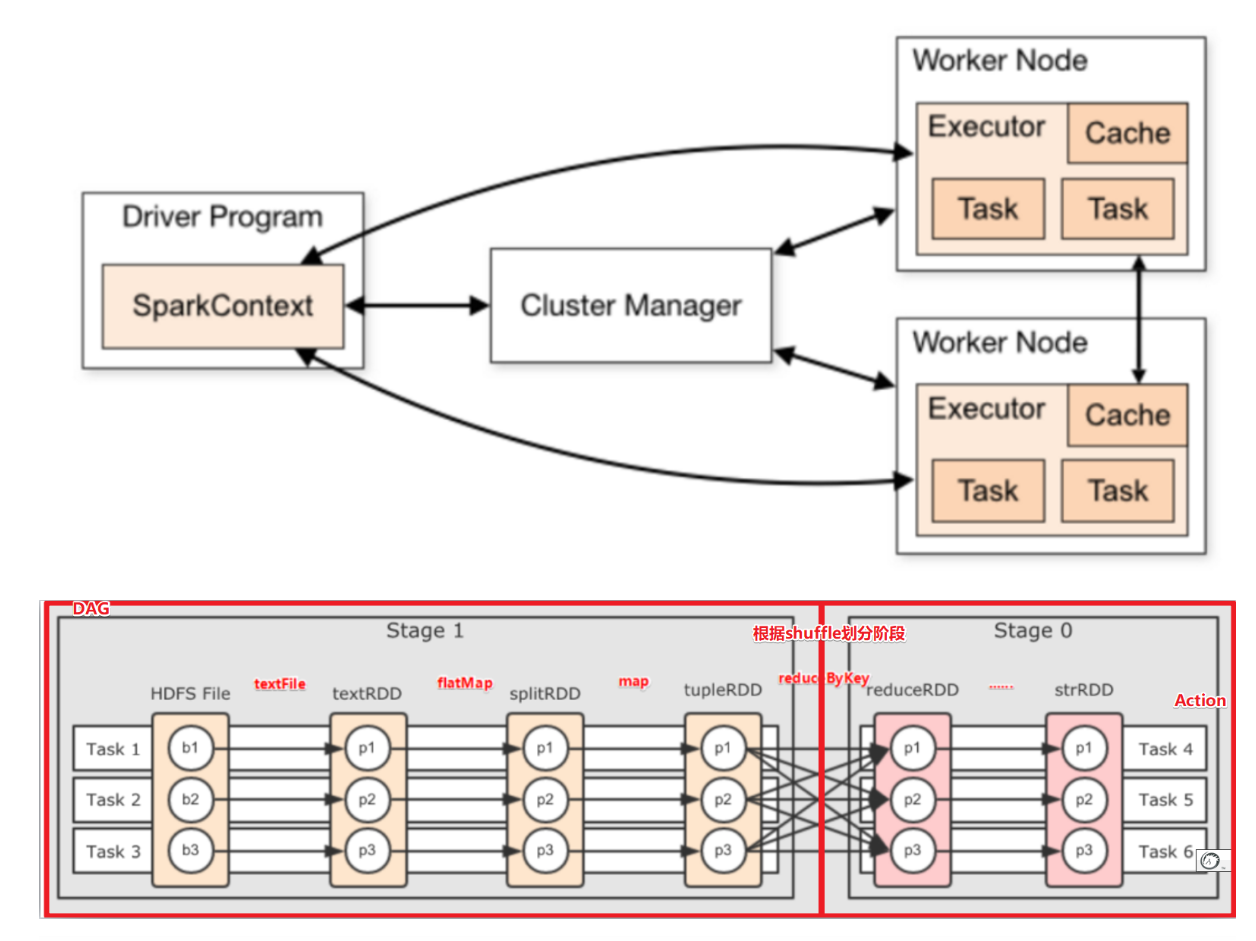

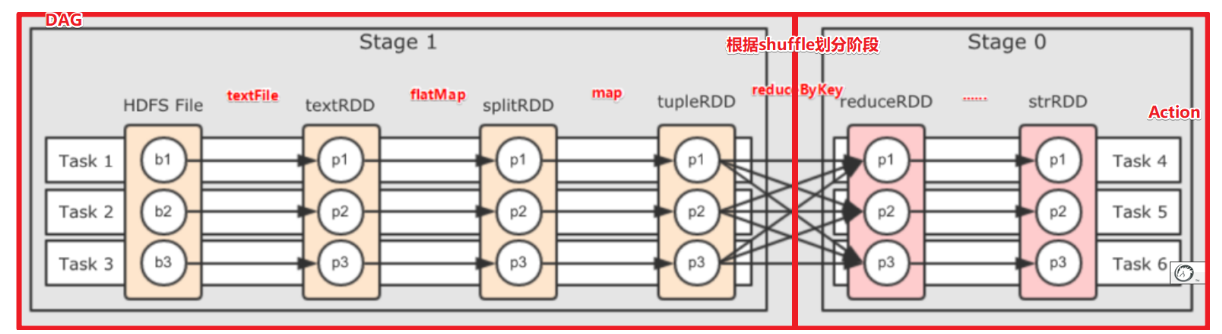

Spark的DAG:就是spark任务/程序执行的流程图!

DAG的开始:从创建RDD开始

DAG的结束:到Action结束

一个Spark程序中有几个Action操作就有几个DAG!

Stage:是DAG中根据shuffle划分出来的阶段!

前面的阶段执行完才可以执行后面的阶段!

同一个阶段中的各个任务可以并行执行无需等待!

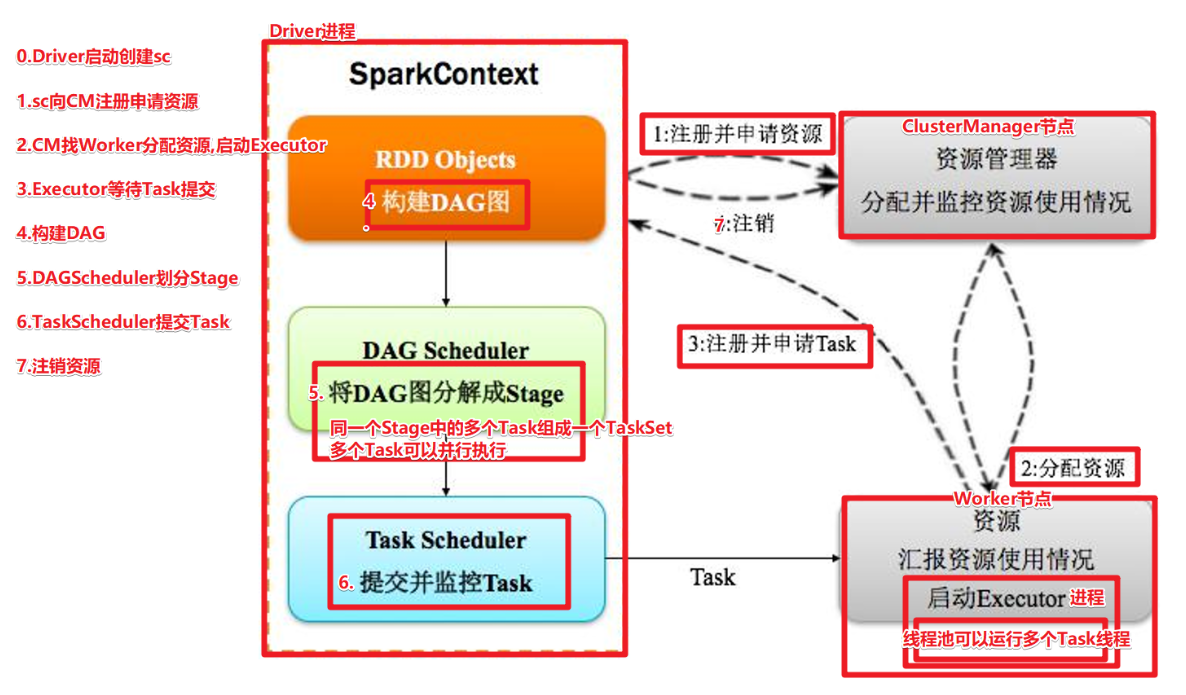

1.Application:应用,就是程序员编写的Spark代码,如WordCount代码 2.Driver:驱动程序,就是用来执行main方法的JVM进程,里面会执行一些Drive端的代码,如创建SparkContext,设置应用名,设置日志级别... 3.SparkContext:Spark运行时的上下文环境,用来和ClusterManager进行通信的,并进行资源的申请、任务的分配和监控等 4.ClusterManager:集群管理器,对于Standalone模式,就是Master,对于Yarn模式就是ResourceManager/ApplicationMaster,在集群上做统一的资源管理的进程 5.Worker:工作节点,是拥有CPU/内存等资源的机器,是真正干活的节点 6.Executor:运行在Worker中的JVM进程! 7.RDD:弹性分布式数据集 8.DAG:有向无环图,就是根据Action形成的RDD的执行流程图---静态的图 9.Job:作业,按照DAG进行执行就形成了Job---按照图动态的执行 10.Stage:DAG中,根据shuffle依赖划分出来的一个个的执行阶段! 11.Task:一个分区上的一系列操作(pipline上的一系列流水线操作)就是一个Task,同一个Stage中的多个Task可以并行执行!(一个Task由一个线程执行),所以也可以这样说:Task(线程)是运行在Executor(进程)中的最小单位! 12.TaskSet:任务集,就是同一个Stage中的各个Task组成的集合!