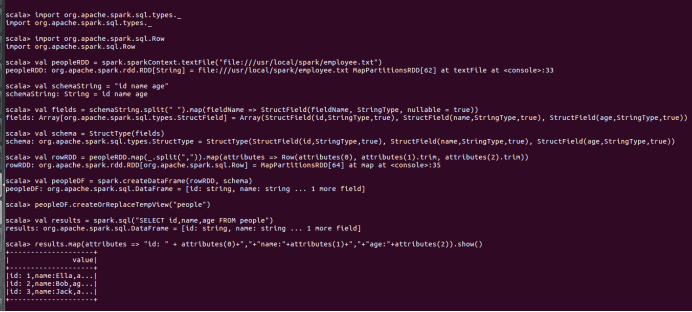

2 .编程实现将 RDD 转换为 DataFrame

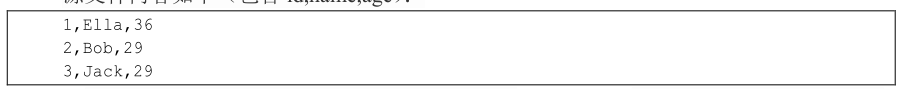

源文件内容如下(包含 id,name,age):

请将数据复制保存到 Linux 系统中,命名为 employee.txt,实现从 RDD 转换得到

DataFrame,并按“id:1,name:Ella,age:36”的格式打印出 DataFrame 的所有数据。请写出程序代

码。

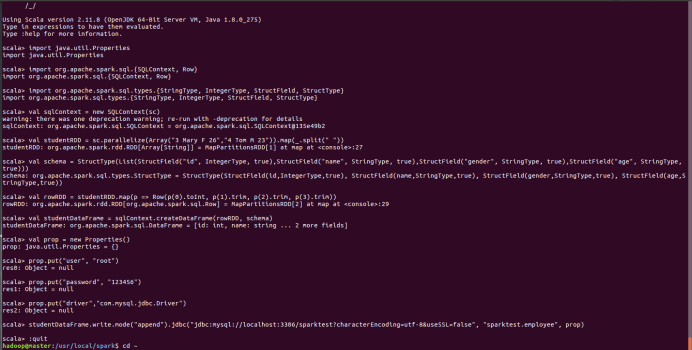

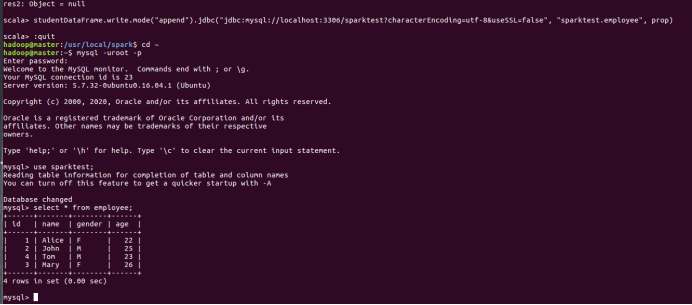

3. 编程实现利用 DataFrame 读写 MySQL 的数据

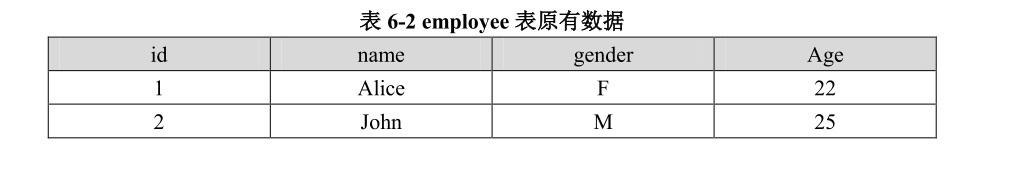

(1)在 MySQL 数据库中新建数据库 sparktest,再创建表 employee,包含如表 6-2 所示的

两行数据。

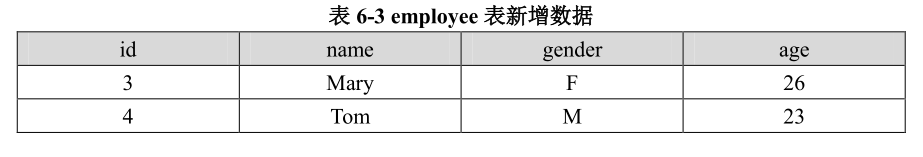

(2)配置 Spark 通过 JDBC 连接数据库 MySQL,编程实现利用 DataFrame 插入如表 6-3 所

示的两行数据到 MySQL 中,最后打印出 age 的最大值和 age 的总和。

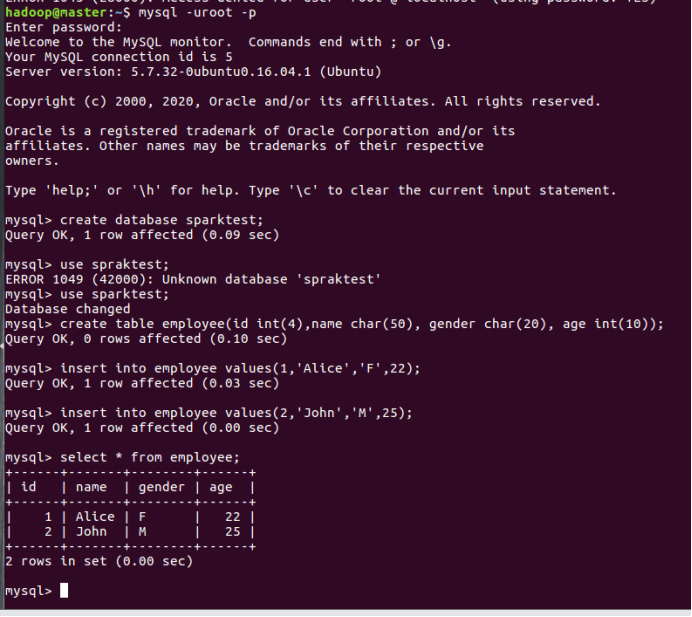

mysql -uroot -p

create database sparktest; use sparktest; create table employee(id int(4),name char(50), gender char(20), age int(10)); insert into employee values(1,'Alice','F',22); insert into employee values(2,'John','M',25); select * from employee;

ctrl+z退出

cd /usr/local/spark

./bin/spark-shell --jars /usr/local/spark/mysql-connector-java-5.1.46/mysql-connector-java-5.1.46-bin.jar --driver-class-path /usr/local/spark/mysql-connector-java-5.1.46-bin.jar

import java.util.Properties import org.apache.spark.sql.{SQLContext, Row} import org.apache.spark.sql.types.{StringType, IntegerType, StructField, StructType} val sqlContext = new SQLContext(sc) val studentRDD = sc.parallelize(Array("3 Mary F 26","4 Tom M 23")).map(_.split(" ")) val schema = StructType(List(StructField("id", IntegerType, true),StructField("name", StringType, true),StructField("gender", StringType, true),StructField("age", StringType, true))) val rowRDD = studentRDD.map(p => Row(p(0).toInt, p(1).trim, p(2).trim, p(3).trim)) val studentDataFrame = sqlContext.createDataFrame(rowRDD, schema) val prop = new Properties() prop.put("user", "root") prop.put("password", "123456") prop.put("driver","com.mysql.jdbc.Driver") studentDataFrame.write.mode("append").jdbc("jdbc:mysql://localhost:3306/sparktest?characterEncoding=utf-8&useSSL=false", "sparktest.employee", prop)