原文:https://www.cnblogs.com/pyedu/p/12461819.html

一、什么是Celery

1.1、celery是什么

Celery是一个简单、灵活且可靠的,处理大量消息的分布式系统,专注于实时处理的异步任务队列,同时也支持任务调度。

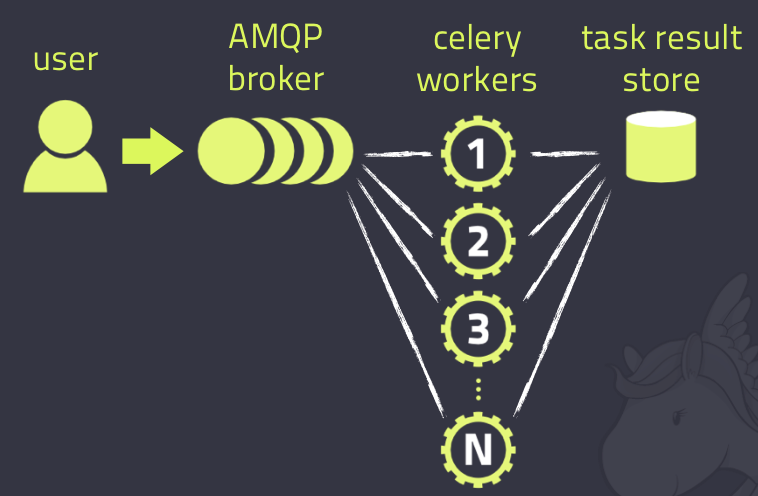

Celery的架构由三部分组成,消息中间件(message broker),任务执行单元(worker)和任务执行结果存储(task result store)组成。

消息中间件

Celery本身不提供消息服务,但是可以方便的和第三方提供的消息中间件集成。包括,RabbitMQ, Redis等等

任务执行单元

Worker是Celery提供的任务执行的单元,worker并发的运行在分布式的系统节点中。

任务结果存储

Task result store用来存储Worker执行的任务的结果,Celery支持以不同方式存储任务的结果,包括AMQP, redis等

另外, Celery还支持不同的并发和序列化的手段

- 并发:Prefork, Eventlet, gevent, threads/single threaded

- 序列化:pickle, json, yaml, msgpack. zlib, bzip2 compression, Cryptographic message signing 等等

1.2、使用场景

celery是一个强大的 分布式任务队列的异步处理框架,它可以让任务的执行完全脱离主程序,甚至可以被分配到其他主机上运行。我们通常使用它来实现异步任务(async task)和定时任务(crontab)。

异步任务:将耗时操作任务提交给Celery去异步执行,比如发送短信/邮件、消息推送、音视频处理等等

定时任务:定时执行某件事情,比如每天数据统计

1.3、Celery具有以下优点

Simple(简单)

Celery 使用和维护都非常简单,并且不需要配置文件。

Highly Available(高可用)

woker和client会在网络连接丢失或者失败时,自动进行重试。并且有的brokers 也支持“双主”或者“主/从”的方式实现高可用。

Fast(快速)

单个的Celery进程每分钟可以处理百万级的任务,并且只需要毫秒级的往返延迟(使用 RabbitMQ, librabbitmq, 和优化设置时)

Flexible(灵活)

Celery几乎每个部分都可以扩展使用,自定义池实现、序列化、压缩方案、日志记录、调度器、消费者、生产者、broker传输等等。

1.4、Celery安装

你可以安装Celery通过Python包管理平台(PyPI)或者源码安装

使用pip安装:

pip install Celery

或着:

sudo easy_install Celery

二、Celery执行异步任务

2.1、基本使用

创建项目celerypro

创建异步任务执行文件celery_task(相当于是消费者)

安装环境 python3.9.5 pip install Celery==5.2.6 pip install redis==4.3.1 # 如果我们要使用redis作为消息中间件,则需要安装redis模块 pip install eventlet==0.33.1

import celery import time backend = 'redis://127.0.0.1:6379/1' broker = 'redis://127.0.0.1:6379/2' cel = celery.Celery('test', backend=backend, broker=broker) @cel.task def send_email(name): """ 我们这个函数就是任务执行单元(worker) 在cel装饰器中,指定了消息中间件(broker)为redis的2库 在cel装饰器中,指定了任务结果存储(result)为redis的1库 """ print("向%s发送邮件..." % name) time.sleep(5) print("向%s发送邮件完成" % name) return "ok"

命令行启动celery监听消息队列:

celery -A celery_task worker -l info -P eventlet

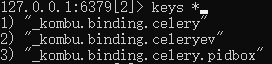

启动后可以看下redis的broker

创建执行任务文件,produce_task.py(相当于是生产者)

from celery_task import send_email # 使用 celery 提供的 delay 方法启动异步任务 result = send_email.delay("发送邮件啦!") print(result.id) result2 = send_email.delay("我再发!") print(result2.id)

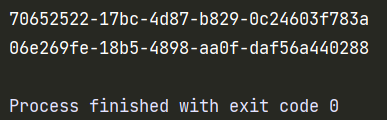

右键点击运行produce_task.py,我们立刻能看到返回的任务id

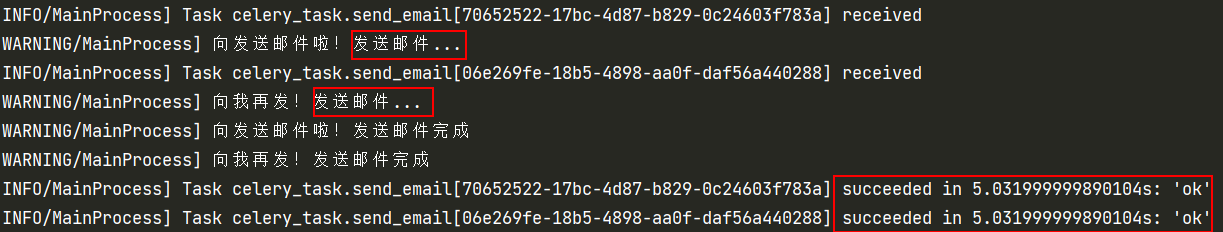

再看celery任务那边,可以看到也是立刻先打印发送邮件的提示,五秒后,两个任务差不多同时打印发送邮件完成

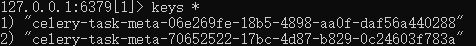

此时也可以看看redis任务结果保存的result

当我们想使用这个异步任务的结果时:

创建py文件:result.py,查看任务执行结果

from celery.result import AsyncResult from celery_task import cel # 使用celery提供的AsyncResult,根据任务id获取结果 async_result = AsyncResult(id="70652522-17bc-4d87-b829-0c24603f783a", app=cel) if async_result.successful(): # 任务执行成功 result = async_result.get() print("任务执行成功,结果是:%s" % result) # result.forget() # 将结果删除 elif async_result.failed(): # 任务执行失败 print('执行失败') elif async_result.status == 'PENDING': # 任务等待被执行 print('任务等待被执行') elif async_result.status == 'RETRY': # 任务重试 print('任务异常后正在重试') elif async_result.status == 'STARTED': # 任务正在执行 print('任务已经开始被执行')

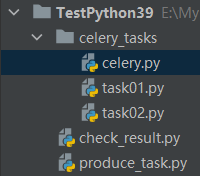

2.1、多任务结构

celery.py:

"""创建celery及其相关的参数""" from celery import Celery cel = Celery('celery_demo', broker='redis://127.0.0.1:6379/1', backend='redis://127.0.0.1:6379/2', # 包含以下两个任务文件,去相应的py文件中找任务,对多个任务做分类 # 当celery对象跟worker不在同一个py文件时,用include告诉celery实例去哪里找 include=['celery_tasks.task01', 'celery_tasks.task02' ]) # 时区 cel.conf.timezone = 'Asia/Shanghai' # 是否使用UTC cel.conf.enable_utc = False

task01.py,task02.py:

# task01 import time from celery_tasks.celery import cel @cel.task def send_email(res): print("开始向%s发送邮件" % res) time.sleep(5) return "完成向%s发送邮件任务" % res # task02 import time from celery_tasks.celery import cel @cel.task def send_msg(name): print("开始向%s发送短信" % name) time.sleep(5) return "完成向%s发送短信任务" % name

# 启动celery

celery -A celery_tasks worker -l info -P eventlet

produce_task.py:

from celery_tasks.task01 import send_email from celery_tasks.task02 import send_msg # 立即告知celery去执行test_celery任务,并传入一个参数 result = send_email.delay('小明') print(result.id) result = send_msg.delay('小红') print(result.id)

check_result.py:

from celery.result import AsyncResult from celery_tasks.celery import cel async_result = AsyncResult(id="fb8cb578-546d-4052-a3c4-ab1477d8fed7", app=cel) if async_result.successful(): result = async_result.get() print(result) # result.forget() # 将结果删除,执行完成,结果不会自动删除 # async.revoke(terminate=True) # 无论现在是什么时候,都要终止 # async.revoke(terminate=False) # 如果任务还没有开始执行呢,那么就可以终止。 elif async_result.failed(): print('执行失败') elif async_result.status == 'PENDING': print('任务等待中被执行') elif async_result.status == 'RETRY': print('任务异常后正在重试') elif async_result.status == 'STARTED': print('任务已经开始被执行')

步骤总结如下:

- 代码都编辑完成

- 开启work:celery -A celery_tasks worker -l info -P eventlet

- 添加任务(执行produce_task.py)

- 检查任务执行结果(执行check_result.py)

三、Celery执行定时任务

设定时间让celery执行一个定时任务,使用produce_task.py简单的启动定时任务:

from celery_tasks.task01 import send_email from datetime import datetime from datetime import timedelta # 方式一 local_time = datetime(2022, 5, 27, 22, 22, 00) utc_time = datetime.utcfromtimestamp(local_time.timestamp()) # 注意:apply_async跟delay都是异步任务函数,起定作用的是 eta 参数 cron_result = send_email.apply_async(args=["彪哥", ], eta=utc_time) # 需要使用utc时间 print(cron_result.id) # 方式二 now_time = datetime.now() utc_time = datetime.utcfromtimestamp(now_time.timestamp()) time_delay = timedelta(seconds=10) task_time = utc_time + time_delay # 使用apply_async并设定时间 result = send_email.apply_async(args=["牛哥"], eta=task_time) print(result.id)

此时这么启动的celery: celery -A celery_tasks worker -l info -P eventlet 执行produce_task.py之后,只会执行一次你定义的定时任务。

多任务结构中celery.py修改如下:

"""创建celery及其相关的参数""" from celery import Celery from celery.schedules import crontab from datetime import timedelta cel = Celery('celery_demo', broker='redis://127.0.0.1:6379/1', backend='redis://127.0.0.1:6379/2', # 包含以下两个任务文件,去相应的py文件中找任务,对多个任务做分类 # 当celery对象跟worker不在同一个py文件时,用include告诉celery实例去哪里找 include=['celery_tasks.task01', 'celery_tasks.task02' ]) # 时区 cel.conf.timezone = 'Asia/Shanghai' # 是否使用UTC cel.conf.enable_utc = False # 通过beat_schedule设置定时任务 # 表示每xx时间向redis插入一个定时任务,即可实现无限循环的定时任务 cel.conf.beat_schedule = { # 定时任务名称,可随意起 'add-every-10-seconds': { # 执行tasks1下的test_celery函数 'task': 'celery_tasks.task01.send_email', # 每隔10秒执行一次 # 'schedule': 1.0, # 'schedule': crontab(minute="*/1"), 'schedule': timedelta(seconds=10), # 传递参数 'args': ('RNG',) }, # 'add-every-12-seconds': { # 'task': 'celery_tasks.task01.send_email', # 每年4月11号,8点42分执行 # 'schedule': crontab(minute=42, hour=8, day_of_month=11, month_of_year=4), # 'args': ('IG',) # }, }

直接在produce_task.py定义定时任务并执行,相当于向消息队列broker添加一次定时任务, 下面我们可以使用celery beat命令启动定时任务,相当于每隔一段时间向消息队列broker添加定时任务 1.启动 Beat 程序: Celery Beat进程会读取配置文件的内容,周期性的将配置中到期需要执行的任务发送给任务队列: # 3.x版本的写法:celery beat -A celery_tasks -l info celery -A celery_tasks beat -l info 2.celery beat启动之后,我们再启动 celery worker 进程: # 3.x版本的写法:celery worker -A celery_tasks -l info -P eventlet celery -A celery_tasks worker -l info -P eventlet

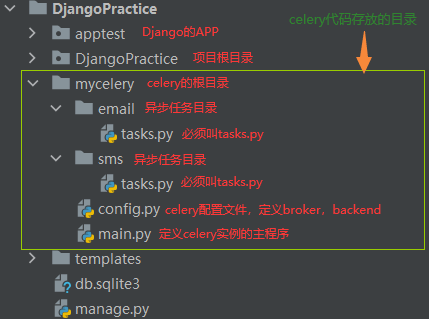

四、Django中使用celery

Django==1.11.17 python==3.9.5,项目根目录创建celery包,目录结构如下:

配置文件mycelery/config.py

broker_url = 'redis://127.0.0.1:6379/15' result_backend = 'redis://127.0.0.1:6379/14'

任务文件mycelery/email/tasks.py和mycelery/sms/tasks.py

# email/tasks # celery的任务必须写在tasks.py的文件中,别的文件名称不识别!!! import time import logging from mycelery.main import app log = logging.getLogger("django") @app.task # name表示设置任务的名称,如果不填写,则默认使用函数名做为任务名 def send_email(email_addr): """发送邮件""" print("向邮箱%s发送邮件成功!" % email_addr) time.sleep(5) return "send_email OK" # sms/tasks # celery的任务必须写在tasks.py的文件中,别的文件名称不识别!!! import time import logging from mycelery.main import app log = logging.getLogger("django") @app.task # name表示设置任务的名称,如果不填写,则默认使用函数名做为任务名 def send_sms(mobile): """发送短信""" print("向手机号%s发送短信成功!" % mobile) time.sleep(5) return "send_sms OK" @app.task # name表示设置任务的名称,如果不填写,则默认使用函数名做为任务名 def send_sms2(mobile): print("向手机号%s发送短信成功!" % mobile) time.sleep(5) return "send_sms2 OK"

main.py主程序中对django的配置文件进行加载

# 主程序 import os from celery import Celery # 创建celery实例对象,此时不在这里定义backend跟broker,解耦出来 app = Celery("mycelery") # 把celery和django进行组合,识别和加载django的配置文件 os.environ.setdefault('DJANGO_SETTINGS_MODULE', 'celeryPros.settings.dev') # 通过app对象加载配置 app.config_from_object("mycelery.config") # 加载任务 # 参数必须必须是一个列表,里面的每一个任务都是任务的路径名称 # app.autodiscover_tasks(["任务1","任务2"]),写到目录即可,会自动去目录下找tasks.py app.autodiscover_tasks(["mycelery.sms", "mycelery.email"]) # 因此名称必须为tasks

最后启动worker监听

启动Celery的命令

强烈建议切换目录到mycelery根目录下启动,在命令行cmd下执行

celery -A mycelery.main worker -l info -P eventlet

Django视图调用:

from datetime import timedelta from datetime import datetime from django.shortcuts import HttpResponse from django.views import View from mycelery.sms.tasks import send_sms, send_sms2 from mycelery.email.tasks import send_email class CeleryTest(View): def get(self, request): # 异步任务 send_sms.delay("123") send_sms2.delay("456") send_email.delay("test@sina.com") # 定时任务 local_time = datetime.now() # 默认用utc时间 utc_time = datetime.utcfromtimestamp(local_time.timestamp()) time_delay = timedelta(seconds=10) task_time = utc_time + time_delay result = send_sms.apply_async(["13111", ], eta=task_time) print(result.id) return HttpResponse('ok')

浏览器只要访问了这个路由视图,就会去执行我们定义的异步任务