完全分布式---------------

1.配置文件

[core-site.xml]

hdfs 地址 fs.defaultFS=hdfs://s129:8020/

[hdfs-site.xml] 副本

replication=1 //伪分布

replication=3 //完全分布

[mapred-site.xml] yarn框架

mapreduce.framework.name=yarn

[yarn-site.xml] 资源管理器主机名

rm.name=s129

[slaves]

s128

s127

s126

2.分发文件

a)ssh

openssh-server //sshd

openssh-clients //ssh

openssh //ssh-keygen

b)scp/rsync

3.格式化文件系统

$>hadoop namenode -format

4.启动hadoop所有进程

//start-dfs.sh + start-yarn.sh

$>start-all.sh

5.xcall.sh jps

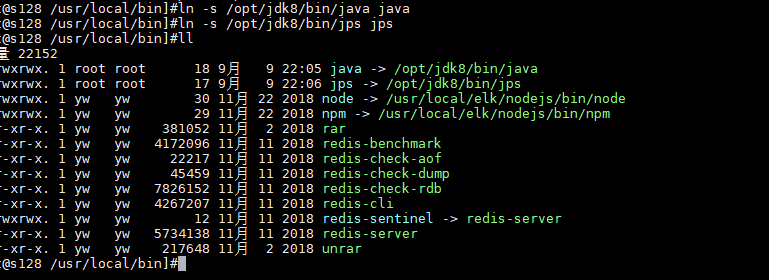

创建符号连接 ln -s xxxx xx

ln -s /opt/jdk8/bin/java java

ln -s /opt/jdk8/bin/jps jps

/usr/local/bin/jps

/usr/local/bin/java

6.查看jps进程

$>xcall.sh jps

或

$>netstat -tunpl | grep 端口号

7.关闭centos的防火墙

$>sudo service firewalld stop // <=6.5 start/stop/status/restart

$>sudo systemctl stop firewalld // 7.0 停止 start/stop/status/restart

$>sudo systemctl disable firewalld //关闭

$>sudo systemctl enable firewalld //启用

7.最终通过webui

http://s201:50070/

符号连接

----------------

1.修改符号连接的owner

$>chown -h centos:centos xxx //-h:针对连接本身,而不是所指文件.

2.修改符号链接

$>ln -sfT index.html index //覆盖原有的连接。

运行命令

start-all.sh 启动所有的Hadoop守护进程。包括NameNode、 Secondary NameNode、DataNode、JobTracker、 TaskTrack

stop-all.sh 停止所有的Hadoop守护进程。包括NameNode、 Secondary NameNode、DataNode、JobTracker、 TaskTrack

start-dfs.sh 启动Hadoop HDFS守护进程NameNode、SecondaryNameNode和DataNode

stop-dfs.sh 停止Hadoop HDFS守护进程NameNode、SecondaryNameNode和DataNode

hadoop-daemons.sh start namenode 单独启动NameNode守护进程

hadoop-daemons.sh stop namenode 单独停止NameNode守护进程

hadoop-daemons.sh start datanode 单独启动DataNode守护进程

hadoop-daemons.sh stop datanode 单独停止DataNode守护进程

hadoop-daemons.sh start secondarynamenode 单独启动SecondaryNameNode守护进程

hadoop-daemons.sh stop secondarynamenode 单独停止SecondaryNameNode守护进程

start-mapred.sh 启动Hadoop MapReduce守护进程JobTracker和TaskTracker

stop-mapred.sh 停止Hadoop MapReduce守护进程JobTracker和TaskTracker

hadoop-daemons.sh start jobtracker 单独启动JobTracker守护进程

hadoop-daemons.sh stop jobtracker 单独停止JobTracker守护进程

hadoop-daemons.sh start tasktracker 单独启动TaskTracker守护进程

hadoop-daemons.sh stop tasktracker 单独启动TaskTracker守护进程

hadoop模块

-------------------

common //

hdfs //

mapreduce //

yarn //

进程

------------------

[hdfs]start-dfs.sh

NameNode NN

DataNode DN

SecondaryNamenode 2NN

[yarn]start-yarn.sh

ResourceMananger RM

NodeManager NM

脚本分析

-------------------

sbin/start-all.sh

--------------

libexec/hadoop-config.sh

start-dfs.sh

start-yarn.sh

sbin/start-dfs.sh

--------------

libexec/hadoop-config.sh

sbin/hadoop-daemons.sh --config .. --hostname .. start namenode ...

sbin/hadoop-daemons.sh --config .. --hostname .. start datanode ...

sbin/hadoop-daemons.sh --config .. --hostname .. start sescondarynamenode ...

sbin/hadoop-daemons.sh --config .. --hostname .. start zkfc ... //

sbin/start-yarn.sh

--------------

libexec/yarn-config.sh

bin/yarn-daemon.sh start resourcemanager

bin/yarn-daemons.sh start nodemanager

sbin/hadoop-daemons.sh

----------------------

libexec/hadoop-config.sh

slaves

hadoop-daemon.sh

sbin/hadoop-daemon.sh

-----------------------

libexec/hadoop-config.sh

bin/hdfs ....

sbin/yarn-daemon.sh

-----------------------

libexec/yarn-config.sh

bin/yarn

bin/hadoop

------------------------

hadoop verion //版本

hadoop fs //文件系统客户端.

hadoop jar //

hadoop classpath

hadoop checknative

bin/hdfs

------------------------

dfs // === hadoop fs

classpath

namenode -format

secondarynamenode

namenode

journalnode

zkfc

datanode

dfsadmin

haadmin

fsck

balancer

jmxget

mover

oiv

oiv_legacy

oev

fetchdt

getconf

groups

snapshotDiff

lsSnapshottableDir

portmap

nfs3

cacheadmin

crypto

storagepolicies

version

hdfs常用命令

--------------------

hdfs dfs -ls / (查看文件系统列表)

$>hdfs dfs -mkdir /usr/local/hadoop/ (创建目录)

$>hdfs dfs -ls -r /usr/local/hadoop/ (查看)

$>hdfs dfs -lsr /usr/local/hadoop/(递归查看)

$>hdfs dfs -put jdk-8u191-linux-x64.tar.gz /usr/local/hadoop/ (复制文件)

$>hdfs dfs -get /usr/local/hadoop/ xxxx (获取文件)

$>hdfs dfs -rm -r -f /usr/local/hadoop/ (删除)

no route

--------------------

关闭防火墙。

$>su root

$>xcall.sh "service firewalld stop"

$>xcall.sh "systemctl disable firewalld"

hdfs

--------------------

500G

1024G = 2T/4T

切割。

寻址时间:10ms左右

磁盘速率 : 100M /s

64M

128M //让寻址时间占用读取时间的1%.

1ms

1 / 100

size = 181260798

block-0 : 134217728

block-1 : 47043070

--------------------

b0.no : 1073741829

b1.no : 1073741830

HA

-----------------------

high availability,高可用性。通常用几个9衡量。

99.999%

SPOF:

-----------------------

single point of failure,单点故障。解决:多配置节点至少两个

secondarynamenode 辅助名称节点 (定期抓取名称节点数据 不高可用)

----------------------

HDFS

找到所有的配置文件

----------------------

1.tar开hadoop-2.7.3.tar.gz

hadoop-2.7.3sharehadoopcommonhadoop-common-2.7.3.jarcore-default.xml

hadoop-2.7.3sharehadoophdfshadoop-hdfs-2.7.3.jarhdfs-default.xml

hadoop-2.7.3sharehadoopmapreducehadoop-mapreduce-client-core-2.7.3.jarmapred-default.xml

hadoop-2.7.3sharehadoopyarnhadoop-yarn-common-2.7.3.jaryarn-site.xml

本地模式

-----------

[core-site.xml]

fs.defaultFS=file:/// //默认值

配置hadoop临时目录

---------------------

1.配置[core-site.xml]文件

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://s129/</value>

</property>

<!--- 配置新的本地目录 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/usr/local/hadoop</value>

</property>

</configuration>

//以下属性均由hadoop.tmp.dir决定,在hdfs-site.xml文件中配置。

dfs.namenode.name.dir=file://${hadoop.tmp.dir}/dfs/name

dfs.datanode.data.dir=file://${hadoop.tmp.dir}/dfs/data

dfs.datanode.data.dir=file://${hadoop.tmp.dir}/dfs/data

dfs.namenode.checkpoint.dir=file://${hadoop.tmp.dir}/dfs/namesecondary

dfs.namenode.checkpoint.dir=file://${hadoop.tmp.dir}/dfs/namesecondary

2.分发core-site.xml文件

$>xsync core-site.xml

3.格式化文件系统,只对namenode的本地目录进行初始化。

$>hadoop namenode -format //hdfs namenode -format

4.启动hadoop

$>start-dfs.sh

使用xcall.sh在所有节点上创建jps符号连接,指向/soft/jdk/bin/jps

------------------------------------------------------------------

1.切换到root用户

$>su root

2.创建符号连接

$>xcall.sh "ln -sfT /soft/jdk/bin/jps /usr/local/bin/jps"

3.修改jps符号连接的owner

$>xcall.sh "chown -h centos:centos /usr/local/bin/jps"

4.查看所有主机上的java进程

$>xcall.sh jps

在centos桌面版中安装eclipse 在虚拟机中编写代码

----------------------------

1.下载eclipse linux版

eclipse-jee-mars-R-linux-gtk-x86_64.tar.gz

2.tar开到/soft下,

$>tar -xzvf eclipse-jee-mars-R-linux-gtk-x86_64.tar.gz -C /soft

3.启动eclipse

$>cd /soft/eclipse

$>./eclipse & //后台启动

4.创建桌面快捷方式

$>ln -s /soft/eclipse/eclipse ~/Desktop/eclipse

5.