最近因为公司业务需要,刚刚接触了kettle.这不看不知道,一看才发现kettle的功能是在是太强大了,让我有种相见恨晚的感觉。由于主要是应用kettle与hadoop集群和hive连接进行数据处理。所以这里简单叙述下kettle与hadoop集群连接时的大致步骤:

1.双击kettle(即data-integeration)目录下的spoon.bat,启动kettle

2.kettle启动后,新建一个作业(job)。可以命名为load_hdfs

3.在load_hdfs中有个Hadoop cluster子项,右键->New cluster,创建一个新集群

4.在新集群创建面板上填写好各个组件的IP+Port等信息

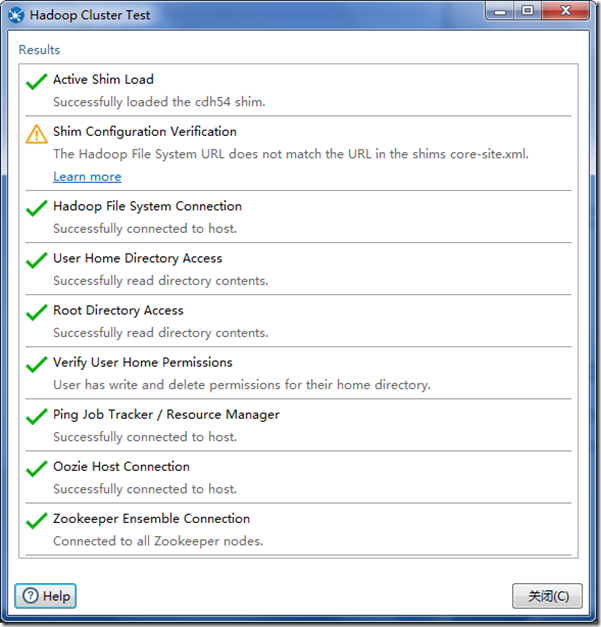

5.点击“测试”按钮,测试新集群能否正常连接

一般若你的kettle刚安装还没有配置过的话,这里会报错显示连接失败。这是正常的,接下来我们就要在kettle包里配置一下相关信息

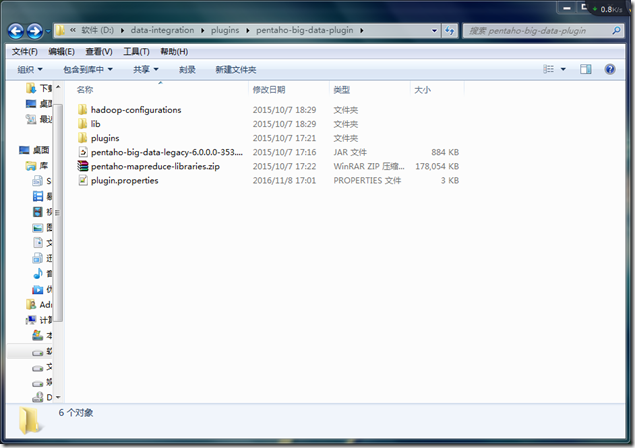

6.首先到{$KETTLE_HOME}/plugins/pentaho-big-data-plugin/目录下找到名为plugin.properties的配置文件,并用notepad++(不一定非得用notepad++,只要是能打开此类文本的编辑器都可以)打开。文件位置和内容如下图所示:

上图中标蓝部分就是我们需要配置的信息了,在此处填远程集群的版本,如我的是cdh5.1,所以填的是cdh51.

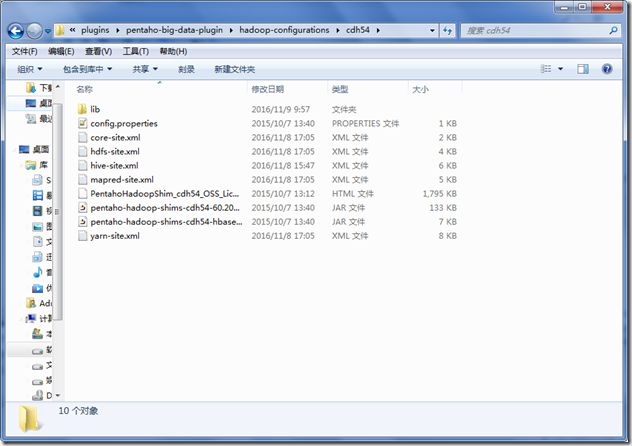

7.保存修改,然后转到data-integrationpluginspentaho-big-data-pluginhadoop-configurations下,我这里只有

cdh54,所以我就直接用了这个配置,即上面配置文件中修改为cdh54(亲测可用)。cdh54文件夹内容如图,

8.接下来是最后一步,就是将上图中的.xml文件替换为远程集群中的相对应的文件

9.配置完成后,重启kettle,即再次执行1-5步(如果没保存作业的话),会发现集群连接成功

至此,hadoop集群就连接成功了。