关于线性回归,推荐几篇博文,讲得很好:

JerryLead的对线性回归,logistic回归和一般回归的认识

leftnoteasy的机器学习中的数学(1)-回归(regression)、梯度下降(gradient descent)

苏冉旭的博客的Logistic regression (逻辑回归) 概述

本文主要是我对线性回归的一些理解。

一.线性回归

线性回归假设特征x和结果y满足线性关系。线性回归的目标函数为:

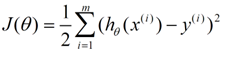

线性回归的损失函数为:

可以用梯度下降法或者最小二乘法调整θ来最小化这个J(θ)。

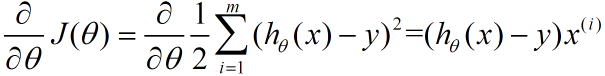

梯度下降法:J(θ)对θ求导得到:

那么θ的更新可以表示为:

最小二乘法:用normal equation直接求得参数的解,结果为:

不过此方法要求X是满秩的,因为要求X-1。

二.逻辑回归

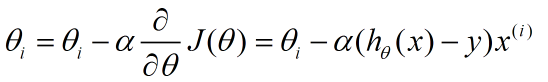

逻辑回归时一个线性分类器,逻辑函数表达式为:

g(z)的求导为

逻辑回归方法主要是用最大似然估计来学习的,所以单个样本的后验概率为:

![]()

那么整个样本的后验概率为:

两边求对数得到:

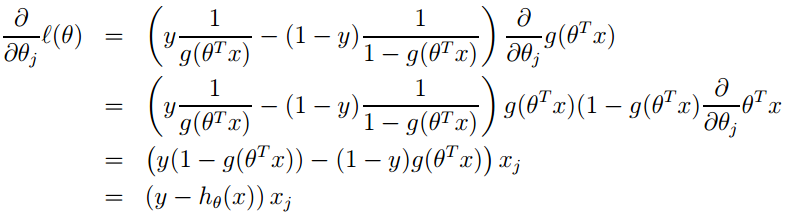

上式即为损失函数,可用梯度下降法求解:

那么θ的更新可以表示为:

![]()

转载请注明出处:http://www.cnblogs.com/Rosanna/p/3623276.html