机器学习西瓜书课后习题答案---1、绪论

一、总结

一句话总结:

一些【特别花时间又不太重要】的东西(比如一些概念),可以【多参照别人的视频解释】,这样节约时间

1、试述机器学习在互联网搜索的哪些环节起什么作用?

1.【消息推送】:比如当我搜索“机器学习”之后,再打开某些网页的时候,会推送有关机器学习培训的广告

2.【网站相关度排行】:通过点击量,网页内容进行综合分析。

3.【图片搜索】:现在大部分还是通过标签来搜索,不过基于像素的搜索也总会有的吧。

二、1、绪论

转自或参考:

一、问题

二、参考答案1

以下是博客https://blog.csdn.net/benzhaohao/article/details/78913588?utm_medium=distribute.pc_feed_404.none-task-blog-searchFromBaidu-5.nonecase&depth_1-utm_source=distribute.pc_feed_404.none-task-blog-searchFromBaidu-5.nonecas的结果

1.1求版本空间

首先看版本空间的定义,这篇文章写的很好

http://blog.csdn.net/qq_18433441/article/details/55682732

概况说来,版本空间就是从假设空间剔除了与正例不一致和与反例一致的假设,它可以看成是对正例的最大泛化。

现在只有西瓜1和西瓜4两个样本:

西瓜1((色泽=青绿、根蒂=蜷缩、敲声=浊响),好瓜))为正例,找到假设空间中和它一致的假设:1,2,4,7,10,16,22,31

西瓜4((色泽=乌黑、根蒂=稍蜷、敲声=沉闷),坏瓜)为反例,找到假设空间中和它一致的假设:1,3,6,9,15,21,30,48

从西瓜1的结果,去除西瓜4的结果,得到版本空间:2,4,7,10,16,22,31

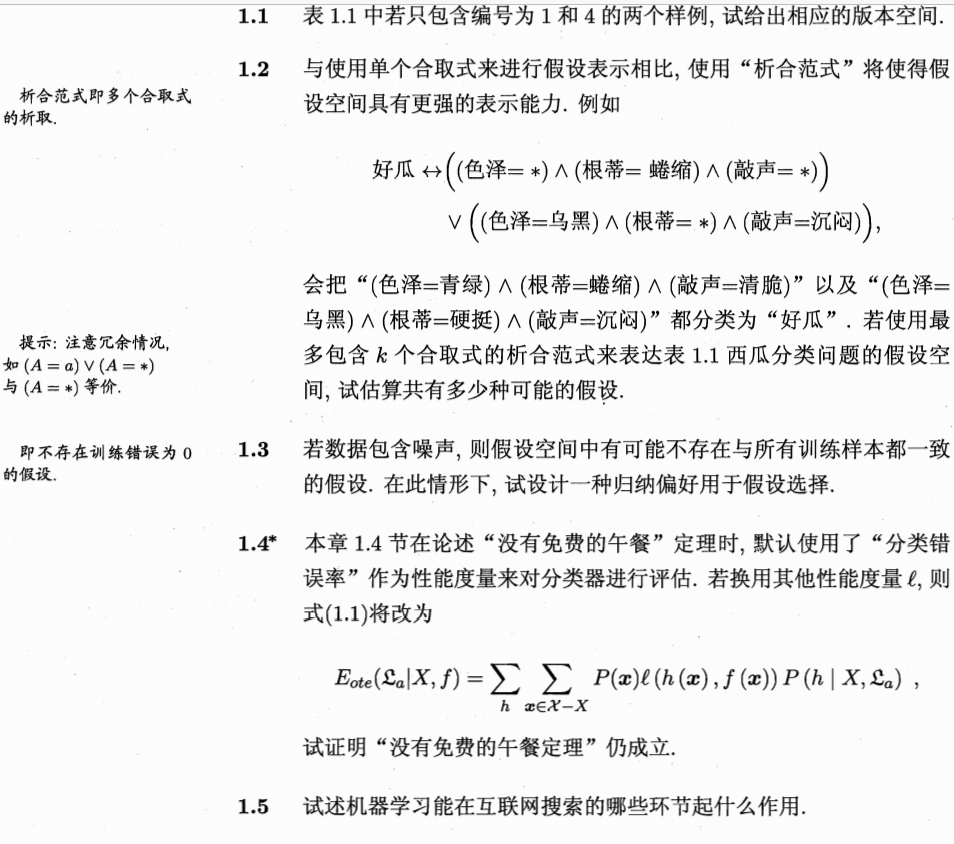

1.2与使用单个合取式来进行假设表示相比,使用“析合范式”将使得假设空间具有更强的表示能力。若使用最多包含k个合取式的析合范式来表达1.1的西瓜分类问题的假设空间,试估算有多少种可能的假设。

http://blog.csdn.net/icefire_tyh/article/details/52065626

1.3.若数据包含噪声,则假设空间中可能不存在与所有训练样本都一致的假设。在此情形下,试设计一种归纳偏好用于假设选择

通常认为两个数据的属性越相近,则更倾向于将他们分为同一类。若相同属性出现了两种不同的分类,则认为它属于与他最临近几个数据的属性。也可以考虑同时去掉所有具有相同属性而不同分类的数据,留下的数据就是没误差的数据,但是可能会丢失部分信息。

1.4.本章1.4节在论述“没有免费的午餐”定理时,默认使用了“分类错误率”作为性能度量来对分类器进行评估。若换用其他性能度量l,试证明没有免费的午餐”定理仍成立

还是考虑二分类问题,NFL首先要保证真是目标函数f均匀分布,对于有X个样本的二分类问题,显然f共有2X种情况。其中一半是与假设一致的,也就 P(f(x)=h(x))=0.5。

此时, ∑fl(h(x),f(x))=0.5∗2X∗(l(h(x)=f(x))+l(h(x)≠f(x)))

l(h(x)=f(x))+l(h(x)≠f(x))应该是个常数,隐含的条件就该是(一个比较合理的充分条件) l(0,0)=l(1,1),l(1,0)=l(0,1)。如果不满足, NFL 应该就不成立了(或者不那么容易证明)。

1.5.试述机器学习在互联网搜索的哪些环节起什么作用

1.消息推送。比如当我搜索“机器学习”之后,再打开某些网页的时候,会推送有关机器学习培训的广告

2.网站相关度排行,通过点击量,网页内容进行综合分析。

3.图片搜索,现在大部分还是通过标签来搜索,不过基于像素的搜索也总会有的吧。

三、找到的参考答案2

以下是博客https://blog.csdn.net/u010083327/article/details/79653053?utm_medium=distribute.pc_feed_404.none-task-blog-BlogCommendFromBaidu-2.nonecase&depth_1-utm_source=distribute.pc_feed_404.none-task-blog-BlogCommendFromBaidu-2.nonecas的内容

表1.1 包含4个样例,3种属性,假设空间中有3 * 4 * 4 + 1 = 49种假设。在不考虑冗余的情况下,最多包含k个合取式来表达假设空间,显然k的最大值是49,每次从中选出k个来组成析合式,共种可能。但是其中包含了很多沉余的情况(至少存在一个合取式被剩余的析合式完全包含<空集除外>)。

如果考虑沉余的情况 在这里忽略空集,一个原因是并不是太明白空集是否应该加入析合式,另外就算需要加入,求出了前面48种假设的组合,可以很容易求出加入空集后的组合数(每种可能都可以加上空集,再加上1种空集单独的情况)。 48种假设中: 具体假设:2∗3∗3=18种 一个属性泛化假设:2∗3+3∗3+2∗3=21种 两个属性泛化假设:2+3+3=8种 三属性泛化:1种

回答1:

1). 通常认为两个数据的属性越相近,则更倾向于将他们分为同一类。若相同属性出现了两种不同的分类,则认为它属于与他最临近几个数据的属性。

2). 也可以考虑同时去掉所有具有相同属性而不同分类的数据,留下的数据就是没误差的数据,但是可能会丢失部分信息。

回答2:

1). 定义一个阈值,只要训练后满足的样本数量百分比达到这个阈值即可。

2). 在训练过程中选择满足最多样本的假设。

NFL首先要保证真目标函数f均匀分布。对于X个训练数据的二分类问题,显然f共有种情况,其中一半是与假设一致的,也就是P(f(x) = h(x)) = 0.5.因此,其中应为常数,如果性能度量为错误率,二者各为0.5,则该值为1,如果为其他性能度量,根据网友的想法:,应当隐含这样的充分条件。

https://wenku.baidu.com/view/fd90c73f4b35eefdc8d3335e.html