pycurl模块用法:

(这块是抄的 ,引用地址:http://blog.csdn.net/xsj_blog/article/details/52102652)

,引用地址:http://blog.csdn.net/xsj_blog/article/details/52102652)

c = pycurl.Curl() #创建一个curl对象

c.setopt(pycurl.CONNECTTIMEOUT, 5) #连接的等待时间,设置为0则不等待

c.setopt(pycurl.TIMEOUT, 5) #请求超时时间

c.setopt(pycurl.NOPROGRESS, 0) #是否屏蔽下载进度条,非0则屏蔽

c.setopt(pycurl.MAXREDIRS, 5) #指定HTTP重定向的最大数

c.setopt(pycurl.FORBID_REUSE, 1) #完成交互后强制断开连接,不重用

c.setopt(pycurl.FRESH_CONNECT,1) #强制获取新的连接,即替代缓存中的连接

c.setopt(pycurl.DNS_CACHE_TIMEOUT,60) #设置保存DNS信息的时间,默认为120秒

c.setopt(pycurl.URL,"http://www.baidu.com") #指定请求的URL

c.setopt(pycurl.USERAGENT,"Mozilla/5.2 (compatible; MSIE 6.0; Windows NT 5.1; SV1; .NET CLR 1.1.4322; .NET CLR 2.0.50324)") #配置请求HTTP头的User-Agent

c.setopt(pycurl.HEADERFUNCTION, getheader) #将返回的HTTP HEADER定向到回调函数getheader

c.setopt(pycurl.WRITEFUNCTION, getbody) #将返回的内容定向到回调函数getbody

c.setopt(pycurl.WRITEHEADER, fileobj) #将返回的HTTP HEADER定向到fileobj文件对象

c.setopt(pycurl.WRITEDATA, fileobj) #将返回的HTML内容定向到fileobj文件对象

c.getinfo(pycurl.HTTP_CODE) #返回的HTTP状态码

c.getinfo(pycurl.TOTAL_TIME) #传输结束所消耗的总时间

c.getinfo(pycurl.NAMELOOKUP_TIME) #DNS解析所消耗的时间

c.getinfo(pycurl.CONNECT_TIME) #建立连接所消耗的时间

c.getinfo(pycurl.PRETRANSFER_TIME) #从建立连接到准备传输所消耗的时间

c.getinfo(pycurl.STARTTRANSFER_TIME) #从建立连接到传输开始消耗的时间

c.getinfo(pycurl.REDIRECT_TIME) #重定向所消耗的时间

c.getinfo(pycurl.SIZE_UPLOAD) #上传数据包大小

c.getinfo(pycurl.SIZE_DOWNLOAD) #下载数据包大小

c.getinfo(pycurl.SPEED_DOWNLOAD) #平均下载速度

c.getinfo(pycurl.SPEED_UPLOAD) #平均上传速度

c.getinfo(pycurl.HEADER_SIZE) #HTTP头部大小代码如下:

#!/usr/bin/env python

# __*__coding:utf8__*__

#Author:wangpengtai

#Blog:http://wangpengtai.blog.51cto.com/

import pycurl

import sys

import StringIO #引用该模块的原因是:使用pycurl后会打印出页面内容,我们不需要看到这个内容,只需要获取页面反馈信息就行了,只能将其写入缓存中,目前没找到好办法,学艺不精,不会使用重定向写到os.devnull中,无奈初次下策。。。

#开始使用的是写入临时文件,但是会有权限问题,导致zabbix无法获取到数据。

class WebStatus(object):

def __init__(self, url):

self.url = url

self.curl = pycurl.Curl()

self.string = StringIO.StringIO()

# 连接等待时间,0则不等待

self.curl.setopt(pycurl.CONNECTTIMEOUT, 5)

# 超时时间

self.curl.setopt(pycurl.TIMEOUT, 5)

# 下载进度条,非0则屏蔽

self.curl.setopt(pycurl.NOPROGRESS, 1)

# 指定HTTP重定向最大次数

self.curl.setopt(pycurl.MAXREDIRS, 5)

# 完成交互后强制断开连接,不重用

self.curl.setopt(pycurl.FORBID_REUSE, 1)

# 设置DNS信息保存时间,默认为120秒

self.curl.setopt(pycurl.DNS_CACHE_TIMEOUT, 60)

# 设置请求的Url

self.curl.setopt(pycurl.URL, self.url)

self.curl.setopt(pycurl.WRITEFUNCTION, self.string.write)#将页面内容写入缓存

self.curl.perform()

def request_value(self):

data = {

"Http_code": self.curl.getinfo(pycurl.HTTP_CODE),

"Speed_download": self.curl.getinfo(pycurl.SPEED_DOWNLOAD),

"Connect_time": self.curl.getinfo(pycurl.CONNECT_TIME),

"Total_time": self.curl.getinfo(pycurl.TOTAL_TIME),

"Dnslookup_time": self.curl.getinfo(pycurl.NAMELOOKUP_TIME),

"Redirect_time": self.curl.getinfo(pycurl.REDIRECT_TIME),

"Redirect_count": self.curl.getinfo(pycurl.REDIRECT_COUNT)

}

return data

def __end__(self): #释放内存和连接,做一个有始有终,有责任心的运维狗

self.string.close()

self.curl.close()

if __name__ == "__main__":

Usage = """

Usage: python web_monitor.py url [Http_code|Speed_download|Connect_time|Total_time|Dnslookup_time|Redirect_time|Redirect_count]

"""

try:

url = sys.argv[1]

request = sys.argv[2]

try:

s = WebStatus(url)

try:

print s.request_value()[request]

except KeyError:

print "Make sure 2nd argument is right!"

except pycurl.error:

print "Make sure the url is right or reachable!"

except IndexError:

print "Must be 2 arguments given!%s" % Usage 验证:www.baidu.com一直是我测(攻)试(击)的对象

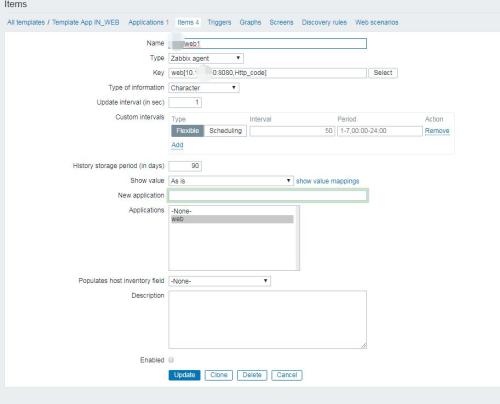

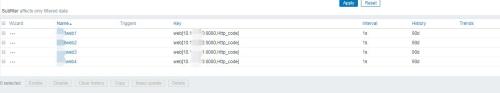

二、配置zabbix自定义监控

这个相对来说比较灵活,可以找一台机器专门用来做监控,只需要在这台机器上配置以下内容就可以监控多个URL了。

zabbix界面中可以配置一个模版,将其挂在该机器上就行了。

1、将代码写到下面目录下并加上可执行权限

[root@zabbix-12-195 scripts]# pwd

/etc/zabbix/scripts

[root@zabbix-12-195 scripts]# vim web_monitor.py

[root@zabbix-12-195 scripts]# chmod +x web_monitor.py2、配置zabbix_agentd.conf

[root@zabbix-12-195 scripts]# cat /etc/zabbix_agentd.conf

UserParameter=web[*],/etc/zabbix/scripts/web_monitor.py $1 $23、重启zabbix-agentd

[root@zabbix-12-195 scripts]# service zabbix-agentd restart三、配置zabbix监控