一、摘要:

本文模型 LRML(潜在相关度量学习)是一种新的度量学习方法的推荐。【旨在学习用户和项目之间的相关关系,而不是简单的用户和项目之间的push和pull关系,push和pull主要针对LMNN算法】

为了做到这一点,本文采用了一个增强的存储器模块,并通过这些记忆块来构建用户和项目潜在的关系。

二、引言:

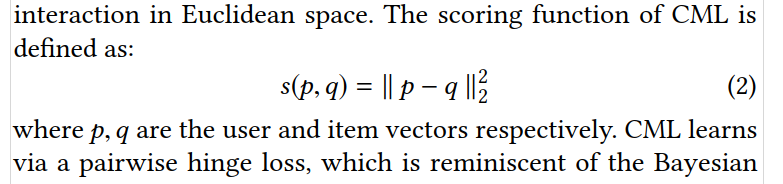

(1)MF的总体思想如下:用户和项目被表示为一个矩阵,然后被分解为潜在的组件,这些组件也可以被解释为使用内部产品来建模用户和项目之间的关系。但其内积违反了三角不等式,故CML被提出。

(2)CML的缺点:

- CML的评分函数具有明显的几何约束性。给定用户-项目交互,CML试图将这对匹配到向量空间中的相同点。【考虑到协作排序问题的多对多性质,从几何角度来看,在向量空间中执行良好的拟合可能确实具有挑战性,特别是因为每个用户和项目的最佳点是在向量空间中的单个点。直观地,这试图将用户及其所有交互项目放入同一点上,即几何上拥挤且不灵活。虽然可以学习用户-用户和项-项相似性集群,但这是以对问题进行排序的精确性和准确性为代价的,特别是对于存在数百万交互的大型数据集】

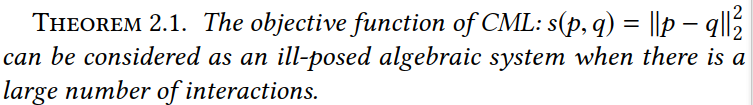

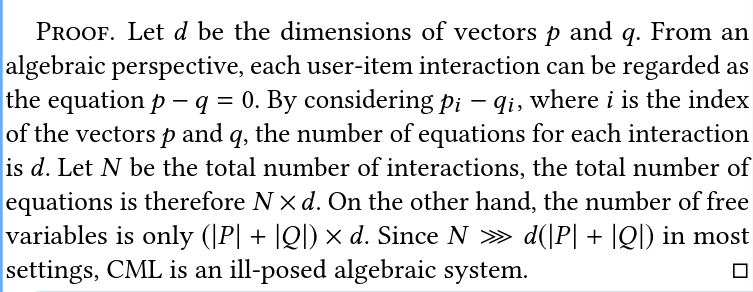

- CML是一个不适定的代数系统[36],它进一步加强和加剧了几何不灵活性问题。

原因:

本文模型LRML(潜在关系度量学习)学习用户和项目交互之间的自适应关系向量,找到每个交互对之间的最优翻译向量。

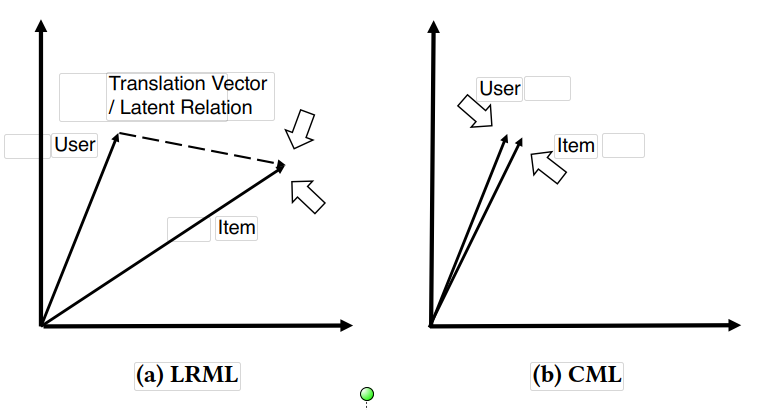

(3)LRML与CML的区别:CML聚于一点

(4)注意力机制:本文主要用来学习用户和项目之间的交互关系。

三、模型:

CML:令 p ≈ q,会使所有的 用户项目向量聚集于一点

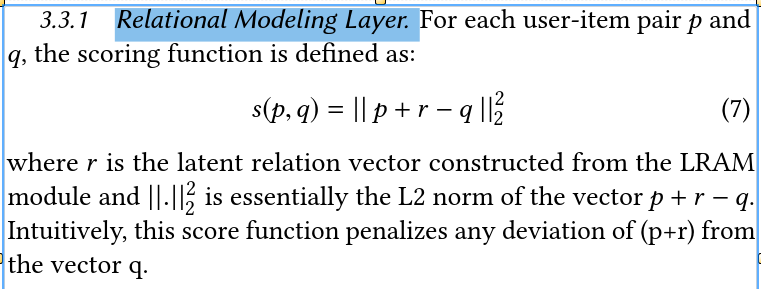

LRML:p + r ≈ q,r为用户-项目关系向量。

(1)Embedding Layer

P = Rd×|U|,Q=Rd×|I|,|U|、|I|是全部用户和项目的数量,d是用户和项目向量的维度。

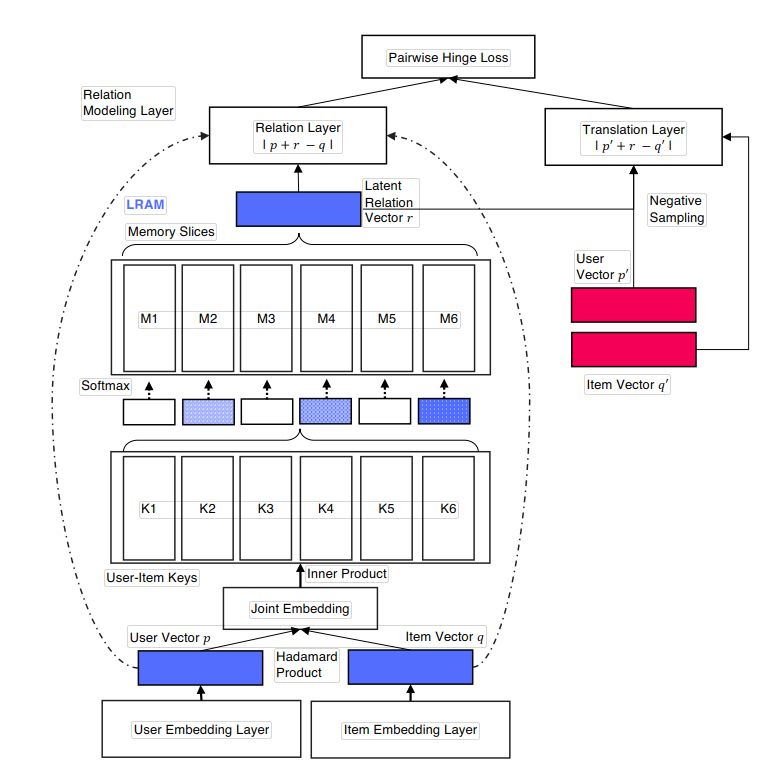

(2)LRAM——Latent Relational Attentive Memory Module

①联合用户-项目向量:Joint User-Item Embedding.

![]()

其中s为联合向量。s∈Rd,⊙是 Hadamard product。【矩阵乘法】

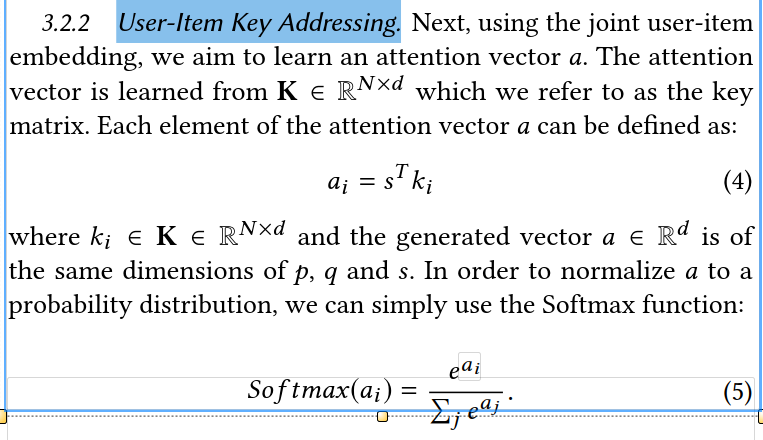

②User-Item Key Addressing.

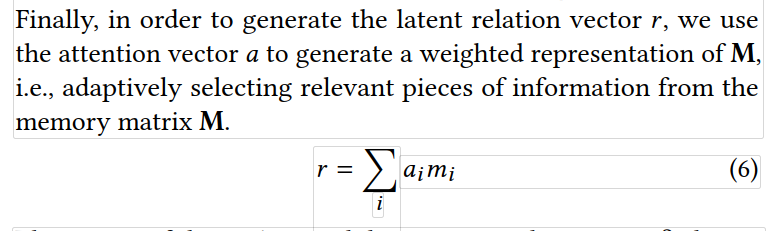

③Generating Latent Relations via Memory-based Attention.

(3)Optimization and Learning

①Relational Modeling Layer.

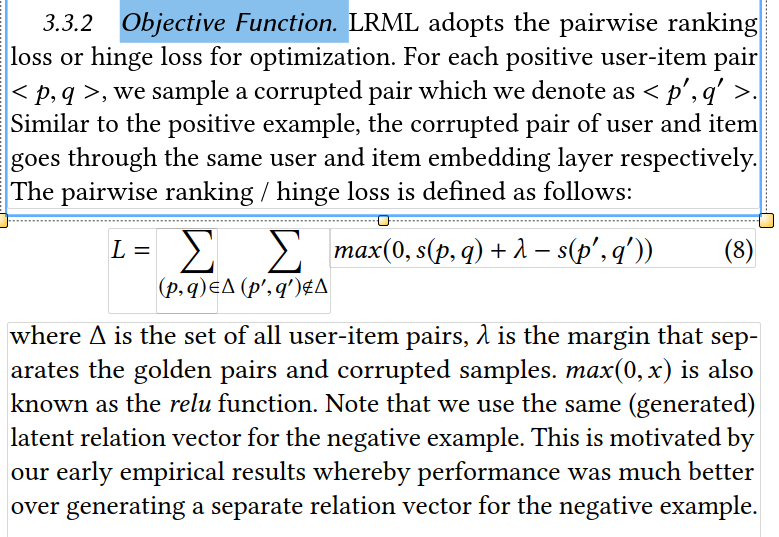

②Objective Function.